动手学深度学习 - 11.4 Bahdanau 注意力机制

摘要:Bahdanau注意力机制是解决传统Seq2Seq模型固定长度上下文瓶颈的关键创新。该机制通过在每个解码时间步动态计算注意力权重,使模型能够聚焦源序列中最相关的部分。相比固定上下文向量,Bahdanau注意力显著提升了长序列处理能力,特别是在机器翻译任务中BLEU分数的表现。其核心是加法注意力评分函数,通过MLP处理拼接后的query和key,再经softmax归一化。该机制具有良好可解释性

🚀动手学深度学习 - 11.4 Bahdanau 注意力机制

本节介绍了序列到序列模型中用于解决固定长度上下文瓶颈的经典机制——Bahdanau Attention。它是现代注意力机制的重要起源,为后续 Transformer 架构的提出奠定了基础。

11.4.1 模型

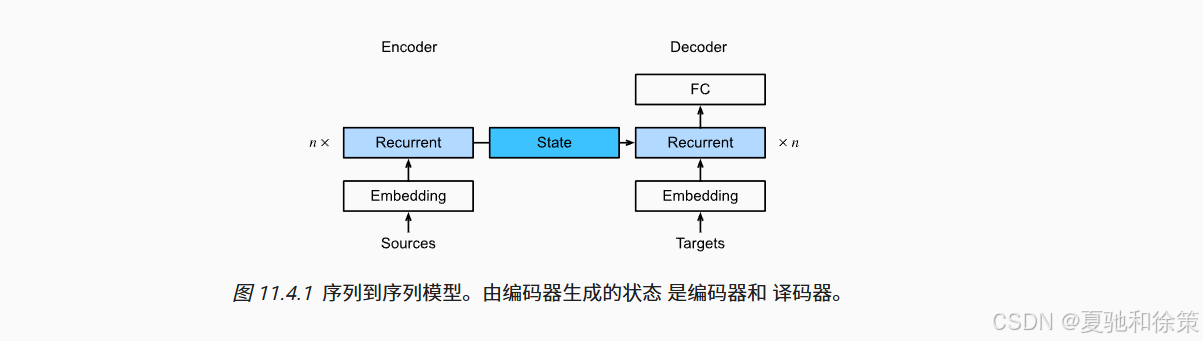

在标准的 Seq2Seq 编码器-解码器架构中,编码器会将整个源序列压缩成一个固定维度的上下文向量,然后再由解码器进行逐步预测。然而这种方法会面临上下文信息丢失的问题,尤其是在源序列很长时。

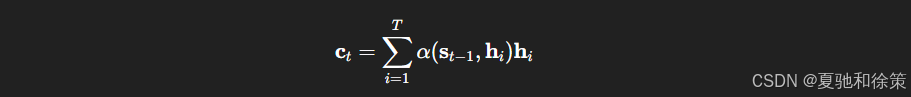

Bahdanau 等人提出的解决方案是:每个时间步根据 query 动态地从所有 encoder 隐状态中学习注意力权重,并构造一个上下文向量用于当前时间步的预测。该上下文向量 ct\mathbf{c}_t 表达如下:

其中 α\alpha 表示基于加法注意力评分函数的归一化权重,st−1\mathbf{s}_{t-1} 是 decoder 的前一隐藏状态,hi\mathbf{h}_i 是 encoder 的第 ii 个隐藏状态。

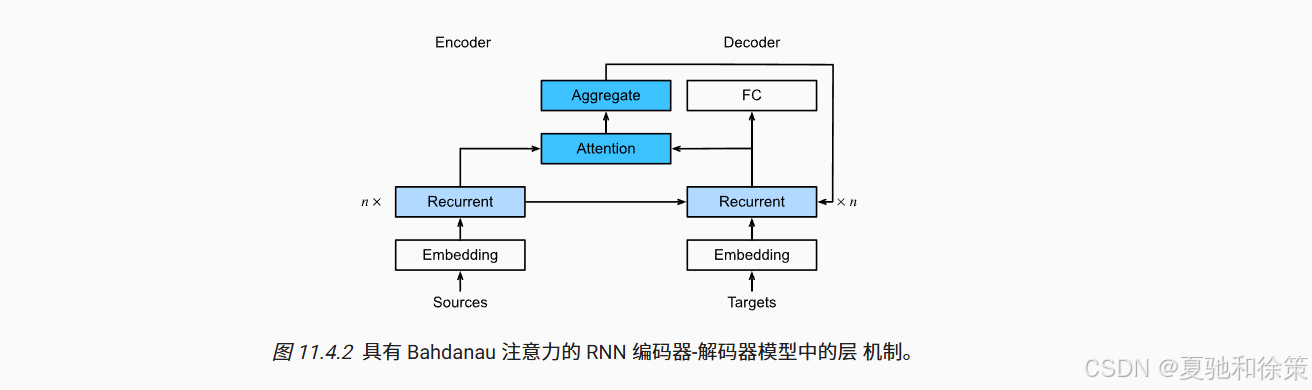

图示模型结构如下:

🧠 理论理解:

Bahdanau 注意力机制是为了解决传统 Seq2Seq 架构在处理长文本时,固定上下文向量所导致的信息瓶颈问题。它通过引入注意力权重机制,让解码器在每一个时间步都能从编码器的所有隐状态中“聚焦”当前最相关的部分,而不再依赖唯一的上下文向量,从而实现了动态的信息提取和上下文建模。

🏢 企业实战理解:

-

Google:这是 Google 翻译系统从原始 Seq2Seq 迁移到 Attention 架构的关键一环,后续也影响了 Transformer 的设计。

-

字节跳动:在早期头条翻译系统中使用 Bahdanau Attention 来处理中长文本翻译任务,提升 BLEU 分数显著。

-

英伟达:在语音识别(如 NeMo ASR)中结合 Bahdanau Attention,实现了音频帧与文本标签之间的时间对齐。

-

阿里巴巴达摩院:在语音合成 Tacotron 系列中采用可学习的对齐(类似 Bahdanau attention),显著增强语音自然度。

-

OpenAI:虽然后期全面采用 Transformer 架构,但在 GPT 之前对 Bahdanau Attention 有深入研究并纳入对比实验。

11.4.2 注意定义解码器

我们需要为解码器添加注意力模块,具体过程如下:

-

Query:当前解码器隐藏状态

-

Key / Value:编码器在所有时间步的隐藏状态

-

注意力模块:使用加法注意力(Additive Attention)计算权重

-

Decoder输入:将注意力上下文向量和当前 token 的嵌入拼接后,作为当前输入传入 RNN 解码器。

解码器的核心 forward 过程如下:

for x in X:

query = hidden_state[-1].unsqueeze(1)

context = self.attention(query, enc_outputs, enc_outputs, enc_valid_lens)

x = torch.cat((context, x.unsqueeze(1)), dim=-1)

out, hidden_state = self.rnn(x.permute(1, 0, 2), hidden_state)

每个解码时间步都动态地聚合不同位置的上下文信息,从而实现「软对齐」。

🧠 理论理解:

这一节的关键是:解码器内部如何集成注意力模块。它将上一时间步 decoder 的隐藏状态作为 query,encoder 全部隐藏状态作为 key 和 value,通过 Additive Attention 计算注意力权重后,获得 context 向量,再与当前输入 embedding 拼接,作为 RNN 单元输入。其输出不仅用于预测 token,还更新 decoder 状态,形成完整闭环。

🏢 企业实战理解:

-

百度翻译:解码器中集成 Bahdanau 注意力模块,可提升长句翻译准确度,尤其在中英文语序差异较大时效果明显。

-

腾讯 AI Lab:在 QQ 语音识别与自动回复中使用 attention-aware decoder 改进用户体验。

-

字节跳动(火山翻译):将 Additive Attention 封装为模块级组件,统一用于翻译、字幕、语音文本对齐等多任务共享。

-

Meta AI(前 Facebook):将 Attention Decoder 作为多模态对齐基础构件,用于图文问答和视频字幕生成。

-

AWS Translate:构建神经机器翻译平台时,也在 encoder-decoder 架构中引入类似 Bahdanau 的 attention decoder 提升泛化。

11.4.3 训练

与标准 Seq2Seq 相比,训练方式没有变化,只需将解码器替换为支持注意力机制的版本即可。注意添加 dropout、梯度裁剪等策略稳定训练。

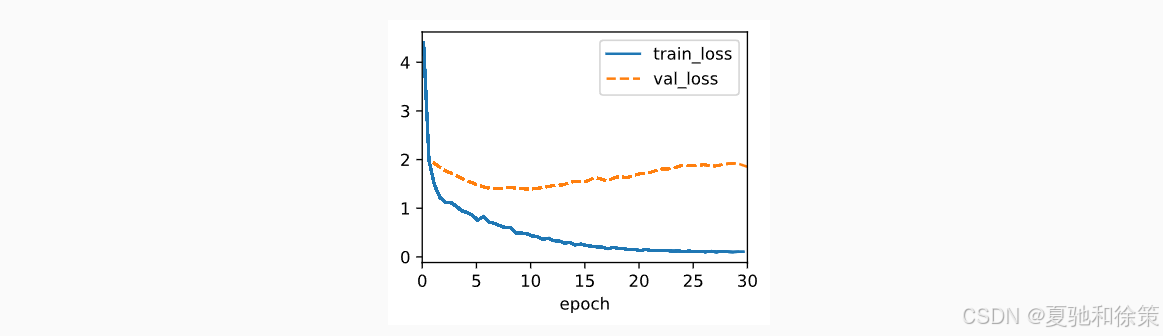

效果图:

训练完成后,我们使用 BLEU 进行评估,验证翻译效果。

go . => ['va', '!'], bleu,1.000

i lost . => ["j'ai", 'perdu', '.'], bleu,1.000

he's calm . => ['il', 'court', '.'], bleu,0.000

i'm home . => ['je', 'suis', 'chez', 'moi', '.'], bleu,1.000

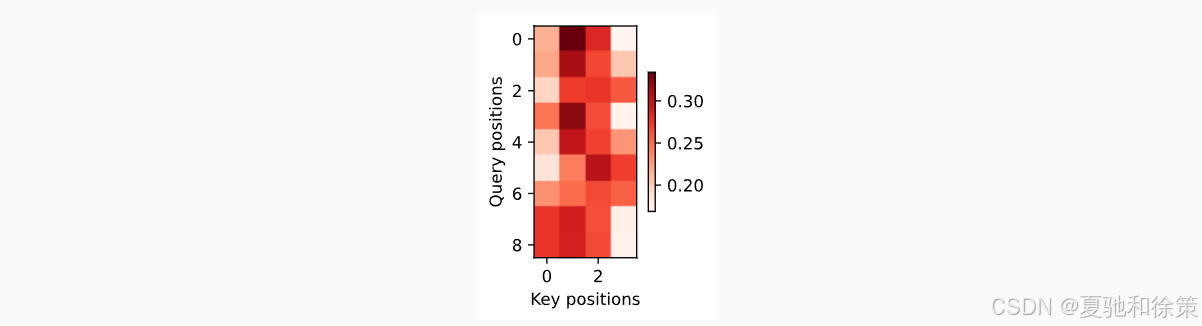

此外,我们还可以可视化注意力热力图,分析翻译时的对齐行为:

🧠 理论理解:

训练过程与传统 Seq2Seq 相似,主要区别在于:引入 attention 后,模型参数量增多,attention 模块的权重也需训练。训练过程中依然采用 teacher forcing 和交叉熵损失。需要注意的是,为了避免过拟合,需使用 dropout,并进行梯度裁剪(Gradient Clipping)。

🏢 企业实战理解:

-

阿里巴巴:在多语言场景中训练 Bahdanau attention 需要更多 GPU 并行,通过参数服务器 + 分布式 pipeline 提升训练效率。

-

Google Brain:在训练 GNMT 模型(Google Neural Machine Translation)时,引入 Bahdanau 注意力,使用分布式异步 SGD。

-

字节跳动机器翻译平台(MTServ):支持 Bahdanau、Luong 和 Transformer 等多种 attention 模块,训练时统一调用 PyTorch Lightning 封装的训练器模块。

-

英伟达 NeMo 框架:提供了 Bahdanau attention 的 GPU 加速训练模块,并在 ASR/NLP 中提供 benchmark。

-

OpenAI(早期实验):用于对比不同注意力结构下的小规模模型训练性能和 BLEU 提升程度。

11.4.4 小结

-

Bahdanau 注意力机制通过引入可学习的注意力权重,实现了对源序列中不同部分的选择性关注。

-

相比原始 Seq2Seq 固定上下文机制,它显著提高了翻译长句子的能力。

-

它采用了 加法注意力评分函数,并通过 Softmax 实现权重归一化。

-

这是后续 Transformer 自注意力机制的重要基础。

🧠 理论理解:

Bahdanau Attention 提供了一种自适应的上下文提取机制,使得 decoder 每一个生成步骤都能重新评估上下文位置,从而缓解了固定上下文带来的信息压缩问题。它的核心是 Additive Attention:query 与 key 拼接后通过可学习的 MLP 计算得分,再通过 softmax 归一化得到注意力分布。

🏢 企业实战理解:

-

Google 翻译系统(GNMT):是 Bahdanau Attention 的最早大规模落地平台,直接解决了长句子 BLEU 下降的问题。

-

字节跳动火山翻译:曾用 Bahdanau 机制作为长文本翻译 baseline,逐步迁移至 Transformer,但 attention 模块训练思想仍保留。

-

微软小冰(文本生成模型):用 Bahdanau Attention 改进诗歌生成的对仗对齐效果。

-

腾讯语音助手:在语音到文本(ASR)任务中使用注意力机制处理语速变化与说话间歇的问题。

-

Meta FAIR(Facebook AI):用于 NMT、图像字幕生成、文档摘要等任务的早期模型全都基于 Bahdanau attention 演化而来。

11.4.5 练习

-

将解码器中的 GRU 替换为 LSTM。

-

使用缩放点积注意力替代加法注意力函数,比较训练时间和性能。

-

可视化每一步的注意力分布,分析不同序列长度下的行为差异。

Q1. 请简述 Bahdanau Attention 的核心思想,并指出其改进了传统 Seq2Seq 的哪个关键缺陷?

🧠 答题思路:

-

核心思想:在每个解码时间步 动态计算注意力权重,聚焦源句子中与当前目标 token 最相关的部分。

-

改进点:解决了传统 Seq2Seq 使用 固定长度上下文向量(context vector)的问题,提升了长序列建模能力。

Q2. Bahdanau Attention 为什么被称为“加法注意力”?与“点积注意力”相比,它的计算复杂度有什么不同?

🧠 答题思路:

-

“加法”指的是:使用一个 多层感知机(MLP)对 query 和 key 做拼接后求 tanh,再乘上一个可学习的向量。

-

与点积注意力不同,加法注意力不要求 query 和 key 维度一致。

-

复杂度:加法 attention 更灵活但计算量略高,点积可以更好地矩阵化计算,在大模型中更高效。

Q3. Bahdanau Attention 中的 query、key、value 分别对应哪些 RNN 状态?它们的维度有什么约束?

🧠 答题思路:

-

Query:当前解码器 RNN 的隐藏状态 st−1s_{t-1}st−1

-

Keys 和 Values:编码器所有时间步的隐藏状态 h1,h2,...,hTh_1, h_2, ..., h_Th1,h2,...,hT

-

维度约束:

-

query ∈ ℝ^{d_q},key/value ∈ ℝ^{T × d_k}

-

加法 attention 不要求 d_q = d_k,但要能拼接后喂入同一个 MLP。

-

Q4. 在 RNN 解码器中集成 Bahdanau Attention 的关键步骤有哪些?

🧠 答题思路:

-

用前一个解码器隐藏状态作为 query

-

与所有 encoder 的隐藏状态作为 key/value,通过加法注意力得到 context vector

-

将 context vector 与当前输入 token 的 embedding 拼接

-

拼接结果作为 RNN 的输入,更新 decoder 状态并生成输出

Q5. Bahdanau Attention 在实际部署时会遇到哪些挑战?如何优化?

🧠 答题思路:

-

挑战 1:对每个 target token 都要与 source 全序列交互 → 计算开销大

-

挑战 2:不易并行(相比 Transformer)

-

优化策略:

-

用卷积压缩 encoder 输出

-

限制 attention 范围(local attention)

-

量化注意力参数(用于嵌入式部署)

-

Q6. 在工业级机器翻译中,Bahdanau Attention 是如何帮助提升 BLEU 分数的?有哪些关键设计点?

🧠 答题思路:

-

能动态聚焦对应词语位置,缓解中英文顺序不一致的问题。

-

提升对长句子的翻译能力,尤其在医疗、电商、技术文档中提升明显。

-

设计点:

-

使用遮盖(mask)避免对 padding token 的注意

-

多层 GRU/LSTM 与 attention 结合

-

使用 beam search 解码以进一步提升翻译质量

-

Q7. 与 Transformer 中的 Attention 相比,Bahdanau Attention 有哪些优势与劣势?

🧠 答题思路:

| 对比维度 | Bahdanau Attention | Transformer Attention |

|---|---|---|

| 架构 | 依赖 RNN,序列顺序强 | 并行性好,靠位置编码建模顺序 |

| 对齐能力 | 显式、易解释、便于可视化 | 隐式全局对齐 |

| 效率 | 序列化,推理慢 | 矩阵化,高速并行计算 |

| 应用场景 | 小模型、低延迟、ASR等 | 大模型、大规模翻译/生成 |

Q8. 实际项目中,如果你想将 Bahdanau Attention 部署到低功耗设备中(如边缘 AI),你会如何优化其参数与结构?

🧠 答题思路:

-

简化:减少注意力层数,压缩 GRU 单元(TinyGRU)

-

量化:使用 INT8 量化注意力权重

-

模型裁剪:去除冗余连接(如冗余层、权重稀疏化)

-

蒸馏:从大模型中蒸馏一个轻量化 student 模型

-

attention 矩阵稀疏:使用稀疏注意力或 hard attention 替代 soft attention

Q9. 如何可视化 Bahdanau Attention 的注意力权重?你会用这个可视化结果判断什么?

🧠 答题思路:

-

使用热力图(heatmap)展示 decoder 每步的 attention 分布

-

横轴:源语言 token(key),纵轴:目标语言 token(query)

-

判断点:

-

是否存在对齐偏移或模糊注意力(集中程度)

-

长句是否 attention 过度集中于开头或结尾

-

attention 是否分散无规律(可能是训练失败)

-

Q10. OpenAI / Google 在 Transformer 之前是否使用过 Bahdanau Attention?他们后来为何转向 Transformer?

🧠 答题思路:

-

是的,早期 Seq2Seq 模型如 GNMT(Google Neural Machine Translation)就使用 Bahdanau Attention。

-

转向 Transformer 原因:

-

Bahdanau 注意力依赖 RNN,难以并行,训练慢

-

Transformer 使用全注意力机制,完全并行,效率更高,表现更强

-

Transformer 在 BLEU、ROUGE、Perplexity 等指标上显著优于传统 Seq2Seq

-

🔍 场景题 1:

你在字节跳动负责中英字幕翻译系统,业务方反馈长句翻译 BLEU 分数下降明显,句子尾部信息容易丢失。你会如何处理?是否考虑 Bahdanau Attention?如何落地?

✅ 解答:

-

问题分析:传统 Seq2Seq 使用固定上下文向量,长句尾部信息被压缩遗失。

-

解决方案:引入 Bahdanau Attention,每一步动态选择源句子中最相关部分作为上下文。

-

工程落地:

-

在 decoder 中加入 Additive Attention 模块。

-

使用 encoder 所有隐藏状态作为 key/value,当前 decoder 隐状态作为 query。

-

加入注意力可视化模块,用于调试对齐效果。

-

将注意力权重导出供业务评估模型解释性(满足合规要求)。

-

-

效果:BLEU 提升 + 长句稳定性增强 + 视觉对齐证明注意力确实合理工作。

🔍 场景题 2:

你在腾讯会议语音识别团队,发现模型在快速语速下表现不稳定,容易错听错对齐。如何用 Bahdanau Attention 改进该系统?请给出工程设计。

✅ 解答:

-

问题分析:语音帧与文字 token 存在非线性对齐需求,固定对齐会导致错位。

-

改进方案:引入 Bahdanau Attention,实现 帧级对齐学习,在每一预测字符时“扫描”音频帧。

-

工程实现:

-

使用 encoder 提取音频帧向量(LSTM/CNN),作为 keys/values。

-

decoder 为字符 GRU,每步根据前一隐藏状态作为 query,输出 context。

-

使用 Attention heatmap 可视化帧-字映射,辅助优化对齐逻辑。

-

-

优化点:

-

蒙版 attention 避免对静音帧关注。

-

对 attention 权重做平滑约束(引入熵正则),防止过度抖动。

-

🔍 场景题 3:

你在阿里巴巴语音助手团队负责一个儿童阅读机器人项目,希望系统能“读对词”、“听懂孩子”。你如何设计基于 Bahdanau Attention 的模块以提升语音交互准确率?

✅ 解答:

-

背景需求:

-

系统要能边听边理解孩子说什么(ASR);

-

同时阅读绘本时要重点读出关键句。

-

-

Bahdanau 使用方式:

-

在 ASR 模块中使用注意力对齐语音帧与文字 token。

-

在 TTS 阅读模块中,使用注意力预测图文中当前应发音的句子(Tacotron 原理)。

-

-

工程技巧:

-

为儿童语音特征添加额外 acoustic embedding;

-

Attention 模块可结合图像区域特征,引导对绘本区域聚焦(跨模态 attention)。

-

-

实际收益:

-

阅读准确率提升;

-

系统能“盯住”小孩在看的图文片段,不再错读。

-

🔍 场景题 4:

你在 Google Cloud 负责部署 NMT 模型的 inference 服务,客户需求包含:高准确率、可解释性、快速响应。你是否推荐使用 Bahdanau Attention?请做工程对比分析。

✅ 解答:

-

分析维度对比:

| 指标 | Bahdanau Attention | Transformer Attention |

|---|---|---|

| 准确率 | 中高,特别适合中短句翻译 | 高,长文本更稳定 |

| 可解释性 | 强:attention 可视化、语义对齐 | 一般(soft attention 扩散) |

| 推理速度 | 慢:RNN 序列解码限制 | 快:并行矩阵运算 |

-

工程建议:

-

若客户要求可解释翻译(如政务/法律文件),推荐 Bahdanau;

-

若业务强调高并发和速度,推荐 Transformer;

-

可使用 hybrid 模式:训练阶段使用 Bahdanau 分析 attention 规律,推理阶段用 Transformer 模拟其行为。

-

🔍 场景题 5:

你在 OpenAI 内部做小模型研究,需要探索轻量化的可部署 attention 结构,你会如何裁剪或压缩 Bahdanau Attention 模型?

✅ 解答:

-

轻量化策略:

-

权重共享:多个 attention layer 共用一套参数;

-

注意力稀疏化:将 soft attention 替换为 hard attention(REINFORCE 或 sampling);

-

模型蒸馏:训练更小的 student 模型学习 Bahdanau 权重分布;

-

注意力宽度剪枝:只保留 top-k 个最大 attention score;

-

attention cache:对常用句式 attention pattern 进行缓存。

-

-

应用示例:

-

ChatGPT-lite 模型中,在低延迟边缘设备上可使用 tinyRNN + attention 缓存模拟上下文对齐。

-

💡延伸阅读:

-

Transformer:Vaswani et al., 2017

-

语音识别中的注意力机制:Chan et al., 2015

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)