基于深度学习YOLOv10的工地安全帽防护衣检测系统(YOLOv10+YOLO数据集+UI界面+Python项目源码+模型)

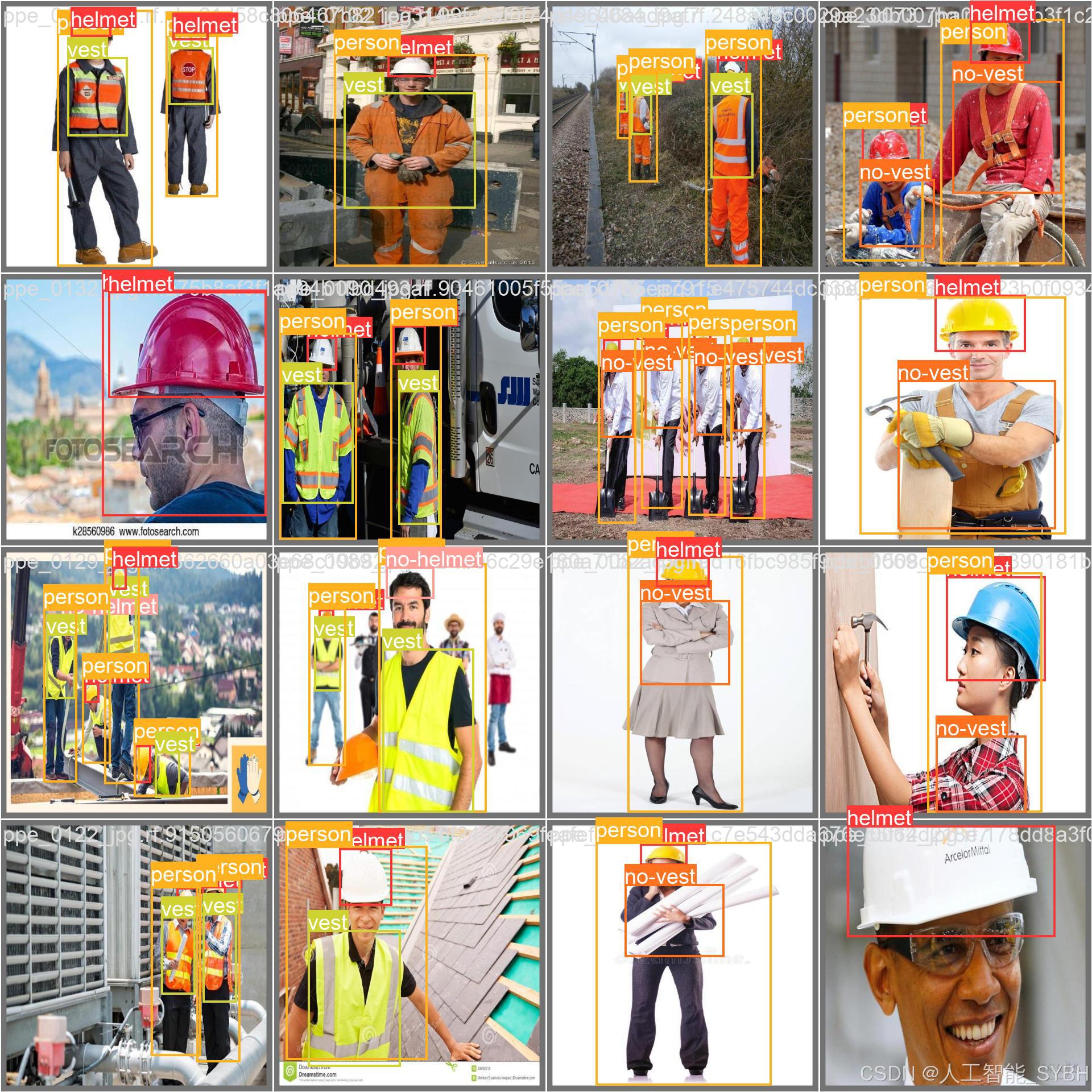

本项目基于先进的YOLOv10目标检测算法,开发了一套高效精准的工地安全防护装备智能检测系统。系统能够实时识别并分类五种关键目标:'helmet'(安全帽)、'no-helmet'(未戴安全帽)、'no-vest'(未穿防护衣)、'person'(人员)和'vest'(防护衣)。项目使用包含1206张标注图像的专业数据集(训练集997张,验证集119张,测试集90张)进行模型训练与优化,实现了施工

一、项目介绍

摘要

本项目基于先进的YOLOv10目标检测算法,开发了一套高效精准的工地安全防护装备智能检测系统。系统能够实时识别并分类五种关键目标:'helmet'(安全帽)、'no-helmet'(未戴安全帽)、'no-vest'(未穿防护衣)、'person'(人员)和'vest'(防护衣)。项目使用包含1206张标注图像的专业数据集(训练集997张,验证集119张,测试集90张)进行模型训练与优化,实现了施工现场安全合规性的自动化监测。该系统可集成于各类监控设备,为建筑工地安全管理提供智能化解决方案,有效预防因防护装备缺失导致的安全事故。

项目意义

建筑工地安全事故中,因未佩戴安全防护装备导致的人身伤害占比居高不下。传统人工巡查方式存在监管盲区、效率低下等问题。本项目的实施具有以下重要价值:

-

提升安全管理效能:实现7×24小时不间断自动监测,覆盖传统人工巡查难以顾及的区域和时间段,大幅提高监管效率。

-

降低事故发生率:通过实时预警未佩戴安全装备的行为,及时纠正违规操作,从源头预防高空坠物打击等典型事故。

-

数字化安全管理:建立可追溯的违规记录数据库,为安全培训、责任认定和保险理赔提供客观依据。

-

降低管理成本:减少专职安全员的人力投入,长期可节省安全管理成本。

-

促进智慧工地建设:作为物联网感知层的关键组件,为工地数字化转型提供核心技术支撑,推动建筑业智能化升级。

-

合规性保障:自动生成符合OSHA等安全标准的检测报告,帮助企业满足日益严格的安全生产监管要求。

目录

七、项目源码(视频下方简介内)

基于深度学习YOLOv10的工地安全帽防护衣检测系统(YOLOv10+YOLO数据集+UI界面+Python项目源码+模型)_哔哩哔哩_bilibili

基于深度学习YOLOv10的工地安全帽防护衣检测系统(YOLOv10+YOLO数据集+UI界面+Python项目源码+模型)

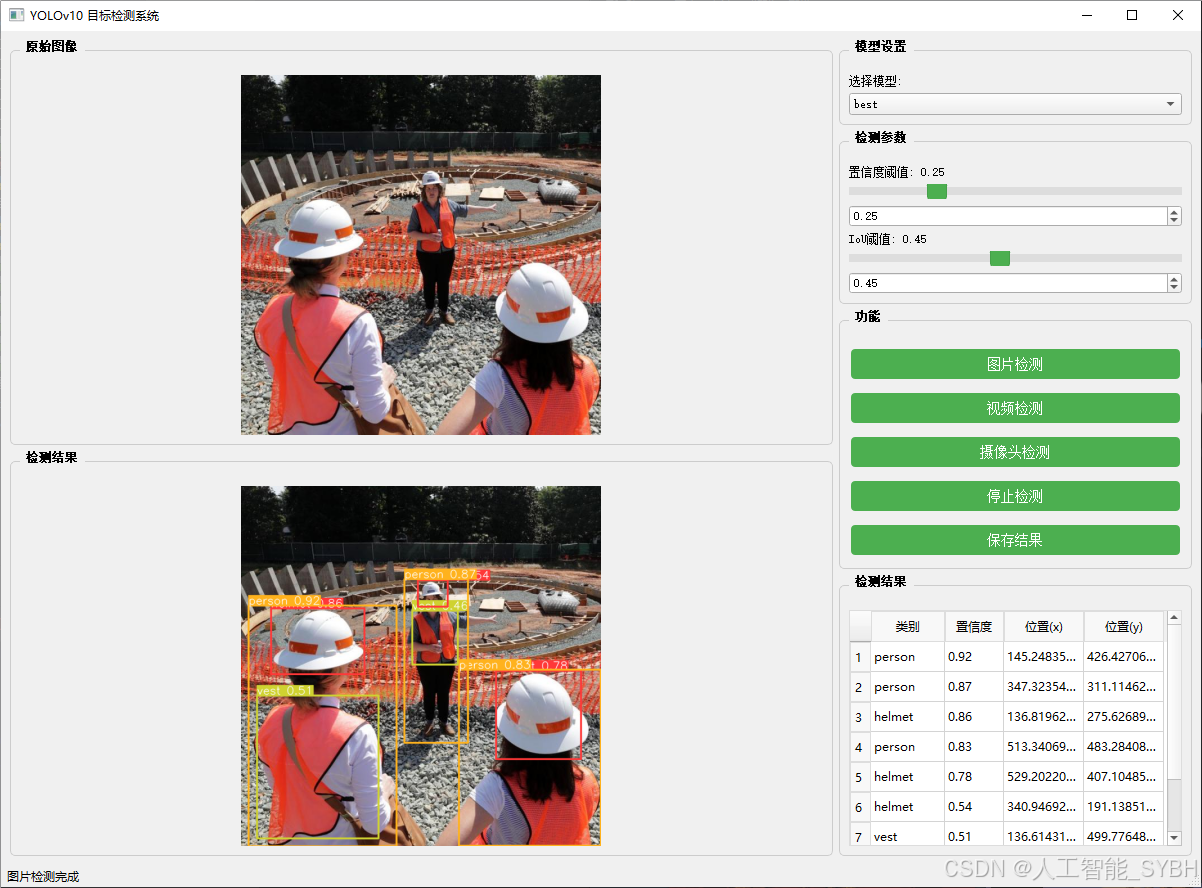

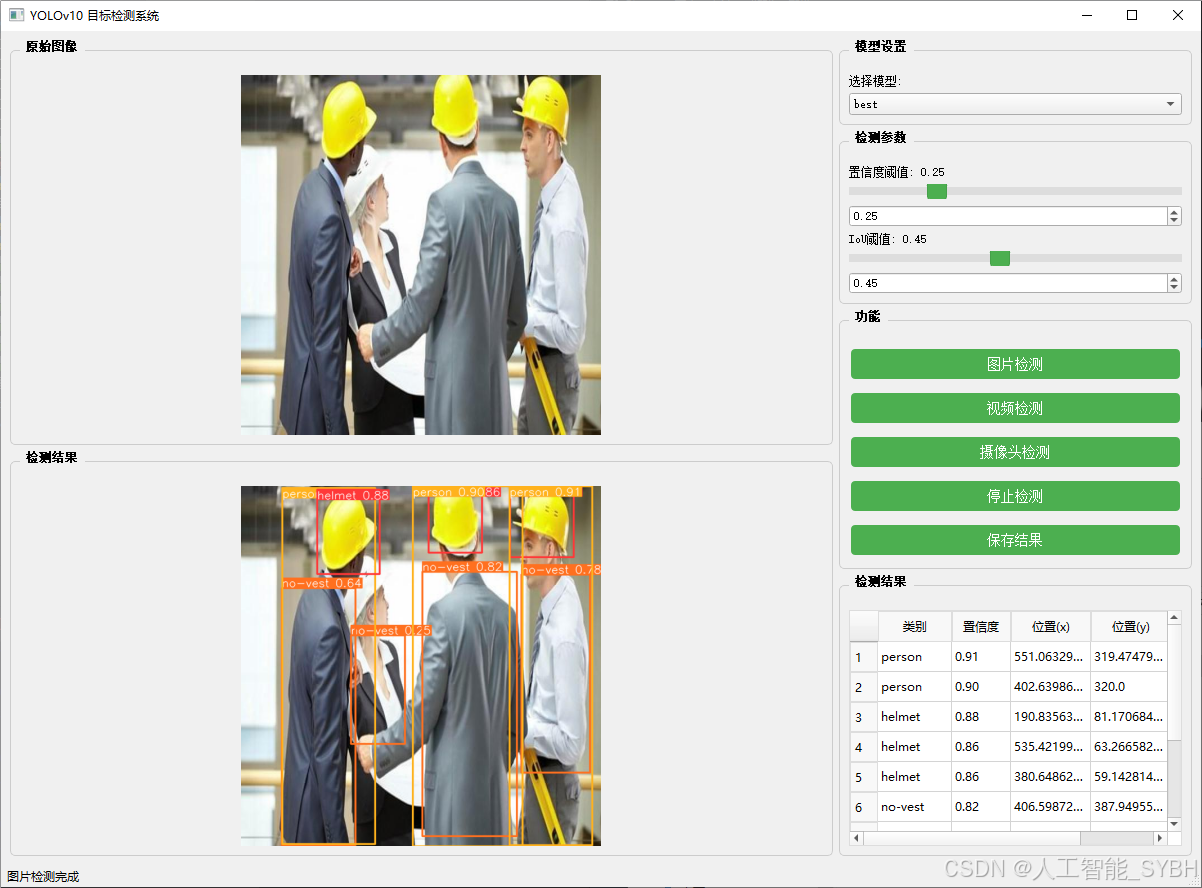

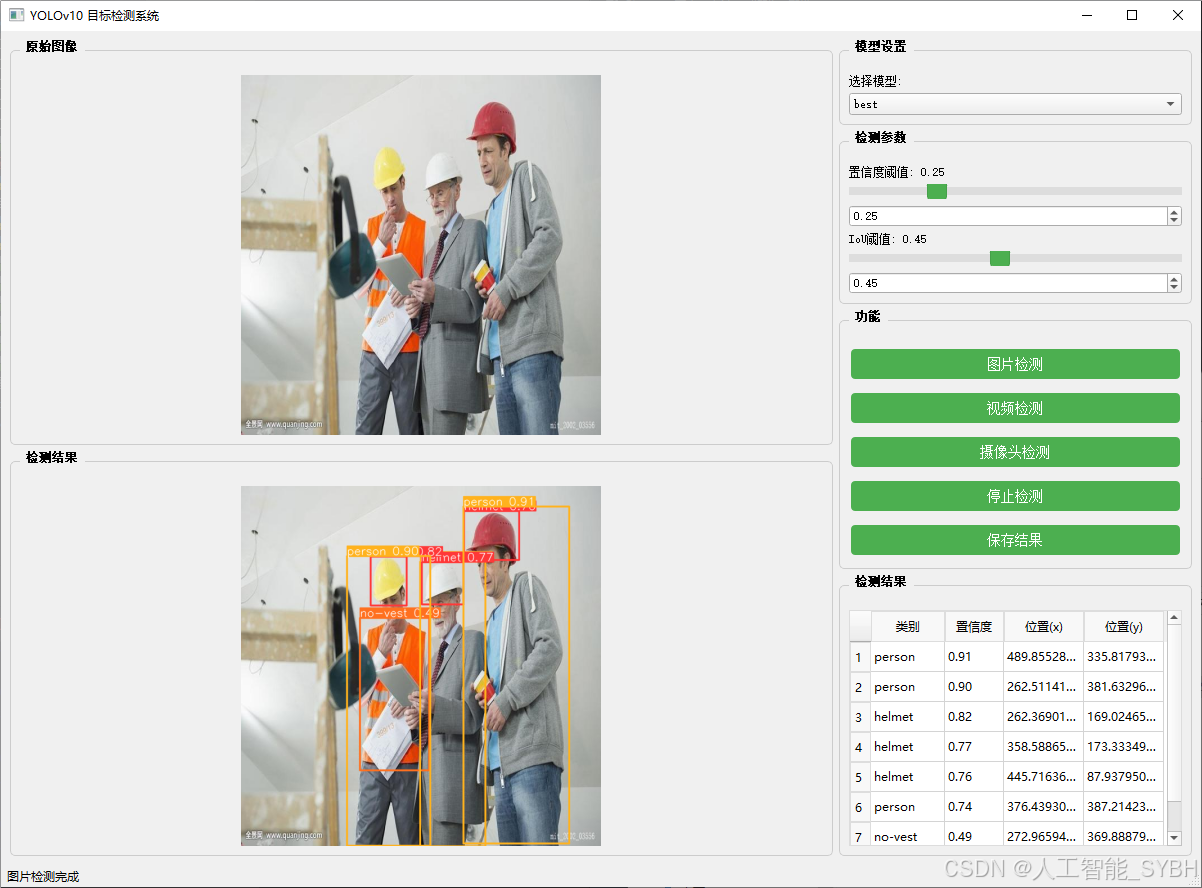

二、项目功能展示

系统功能

✅ 图片检测:可对图片进行检测,返回检测框及类别信息。

✅ 视频检测:支持视频文件输入,检测视频中每一帧的情况。

✅ 摄像头实时检测:连接USB 摄像头,实现实时监测。

✅参数实时调节(置信度和IoU阈值)

-

图片检测

该功能允许用户通过单张图片进行目标检测。输入一张图片后,YOLO模型会实时分析图像,识别出其中的目标,并在图像中框出检测到的目标,输出带有目标框的图像。

-

视频检测

视频检测功能允许用户将视频文件作为输入。YOLO模型将逐帧分析视频,并在每一帧中标记出检测到的目标。最终结果可以是带有目标框的视频文件或实时展示,适用于视频监控和分析等场景。

-

摄像头实时检测

该功能支持通过连接摄像头进行实时目标检测。YOLO模型能够在摄像头拍摄的实时视频流中进行目标检测,实时识别并显示检测结果。此功能非常适用于安防监控、无人驾驶、智能交通等应用,提供即时反馈。

核心特点:

- 高精度:基于YOLO模型,提供精确的目标检测能力,适用于不同类型的图像和视频。

- 实时性:特别优化的算法使得实时目标检测成为可能,无论是在视频还是摄像头实时检测中,响应速度都非常快。

- 批量处理:支持高效的批量图像和视频处理,适合大规模数据分析。

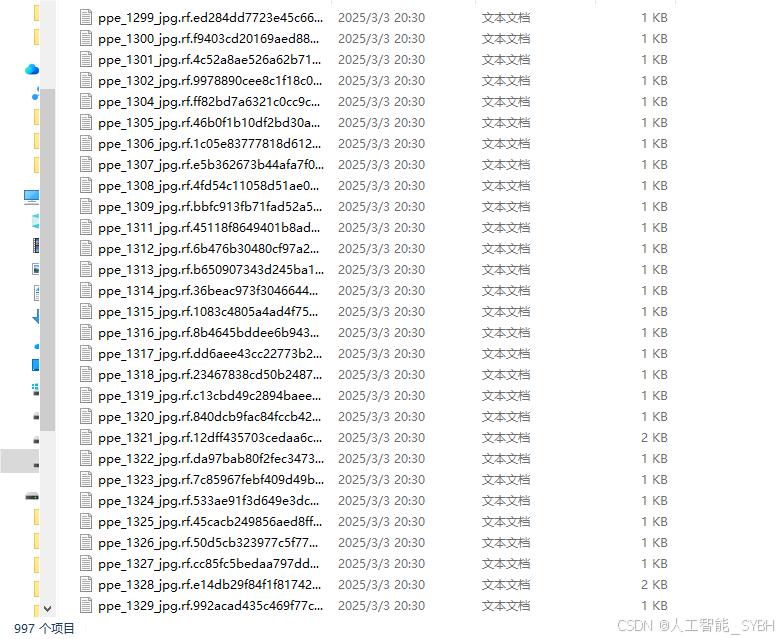

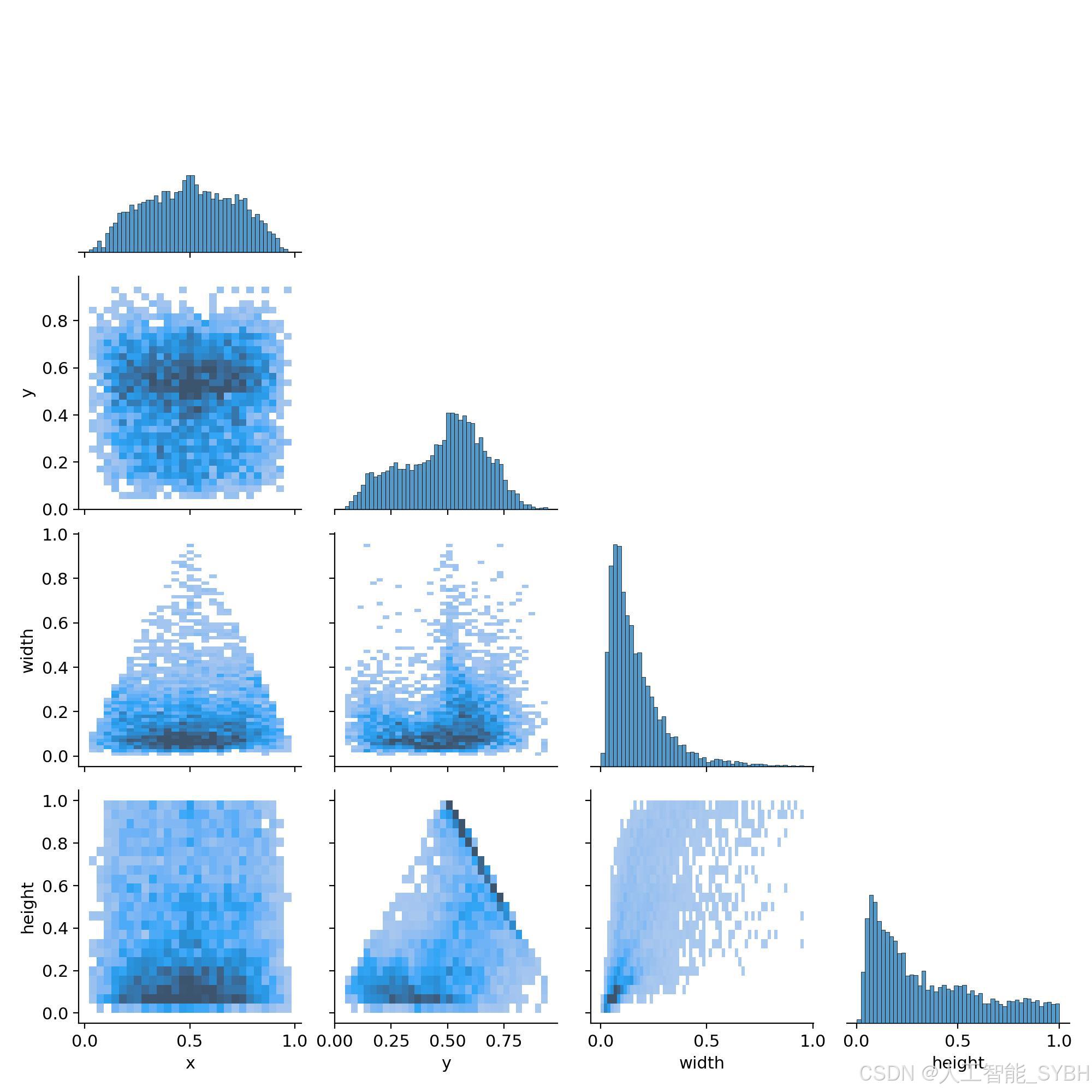

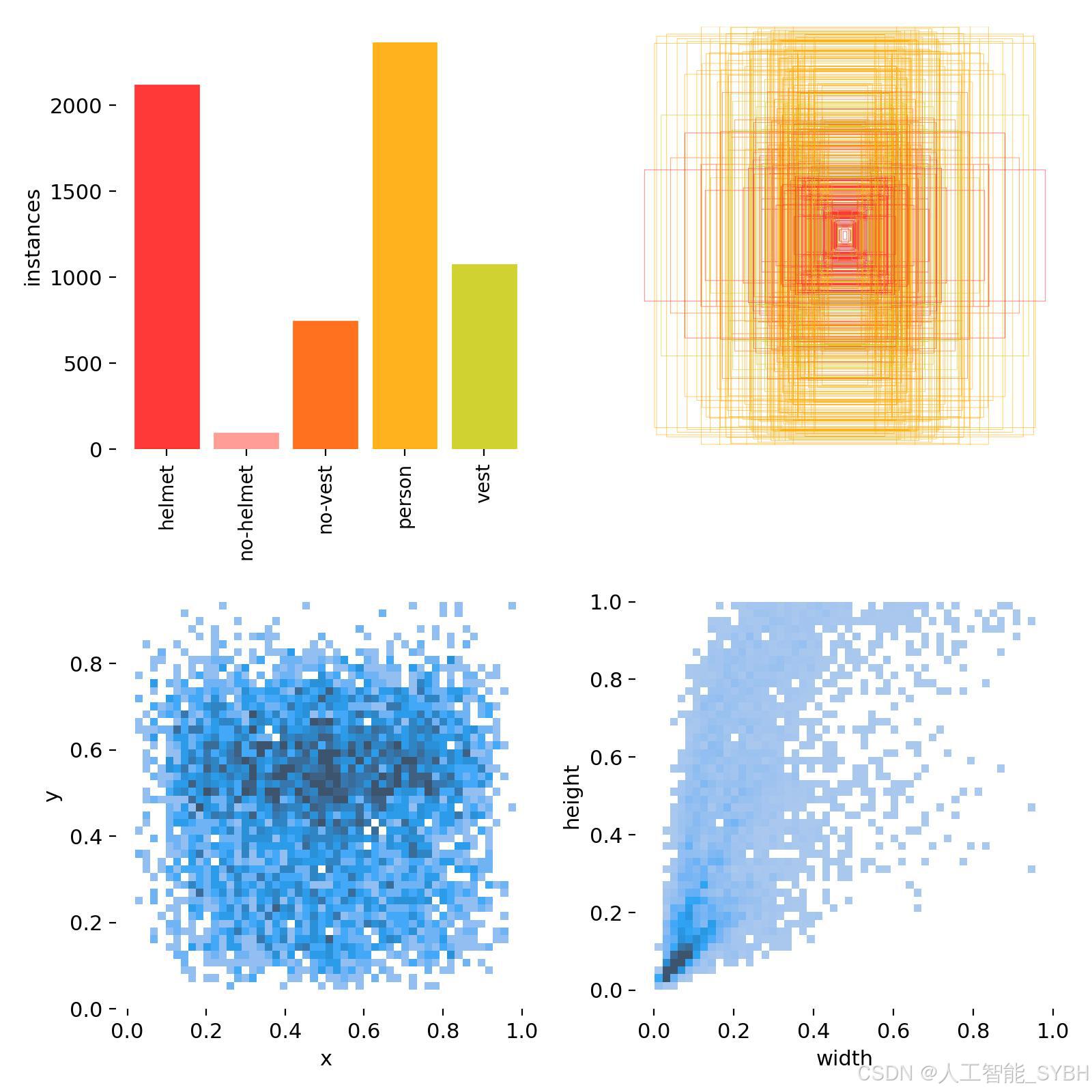

三、数据集介绍

数据集概述

本项目构建的专业化工地安全检测数据集共包含1206张高质量图像:

-

训练集:997张图像,用于模型特征提取能力的培养

-

验证集:119张图像,用于训练过程中的模型选择和参数调优

-

测试集:90张图像,用于最终模型性能的客观评估

数据集覆盖了五类关键检测目标,每张图像均包含精细标注,标注格式严格遵循YOLO模型规范。

数据集特点

-

场景多样性:

-

采集自不同类型的建筑工地(住宅、商业、基建等)

-

包含不同施工阶段(地基、结构、装修等)的场景

-

覆盖多种天气条件(晴天、阴天、雨天)和光照变化

-

-

现实挑战性:

-

存在目标遮挡、小尺度目标(远距离人员)等复杂情况

-

包含安全帽与相似形状物体(桶、工具等)的干扰场景

-

处理不同颜色、样式的安全防护装备变体

-

-

专业实用性:

-

特别标注"no-helmet"和"no-vest"等违规状态类别

-

包含群体密集场景下的个体检测挑战

-

反映真实工地中常见的装备佩戴不规范案例

-

数据集配置文件

项目采用标准化的YOLO格式数据集配置文件(safety.yaml),核心内容如下:

path: ../datasets/construction_safety

train: images/train

val: images/val

test: images/test

nc: 5

names: ['helmet', 'no-helmet', 'no-vest', 'person', 'vest']关键配置说明:

-

path: 数据集存储根目录路径 -

train/val/test: 各子集图像存储路径 -

nc: 检测类别总数(5类目标) -

names: 类别名称列表,与标注文件中的类别ID严格对应

数据集制作流程

-

多源数据采集:

-

使用4K工业摄像头在真实工地现场采集图像

-

整合公开数据集中的相关场景样本

-

采用无人机俯拍和固定监控平拍等多视角采集

-

-

严格数据筛选:

-

剔除模糊、过暗或重复性高的图像

-

确保每类目标的样本量均衡分布

-

保留具有挑战性的遮挡、小目标样本

-

-

精细化标注:

-

使用CVAT标注工具进行边界框标注

-

对模糊目标实行三级质量审核制度

-

特别处理部分遮挡目标的可见区域标注

-

-

针对性数据增强:

-

模拟工地扬尘环境添加微粒噪声

-

应用光照条件变换模拟不同时段效果

-

生成雨雾等天气条件下的合成图像

-

-

科学数据集划分:

-

按工地类型和场景特征分层抽样

-

确保同一工地的不同区域不会跨数据集出现

-

测试集专门保留最难检测的典型案例

-

-

四、项目环境配置

创建虚拟环境

首先新建一个Anaconda环境,每个项目用不同的环境,这样项目中所用的依赖包互不干扰。

终端输入

conda create -n yolov10 python==3.9

激活虚拟环境

conda activate yolov10

安装cpu版本pytorch

pip install torch torchvision torchaudio

pycharm中配置anaconda

安装所需要库

pip install -r requirements.txt

五、模型训练

训练代码

from ultralytics import YOLOv10

model_path = 'yolov10s.pt'

data_path = 'datasets/data.yaml'

if __name__ == '__main__':

model = YOLOv10(model_path)

results = model.train(data=data_path,

epochs=500,

batch=64,

device='0',

workers=0,

project='runs/detect',

name='exp',

)根据实际情况更换模型 yolov10n.yaml (nano):轻量化模型,适合嵌入式设备,速度快但精度略低。 yolov10s.yaml (small):小模型,适合实时任务。 yolov10m.yaml (medium):中等大小模型,兼顾速度和精度。 yolov10b.yaml (base):基本版模型,适合大部分应用场景。 yolov10l.yaml (large):大型模型,适合对精度要求高的任务。

--batch 64:每批次64张图像。--epochs 500:训练500轮。--datasets/data.yaml:数据集配置文件。--weights yolov10s.pt:初始化模型权重,yolov10s.pt是预训练的轻量级YOLO模型。

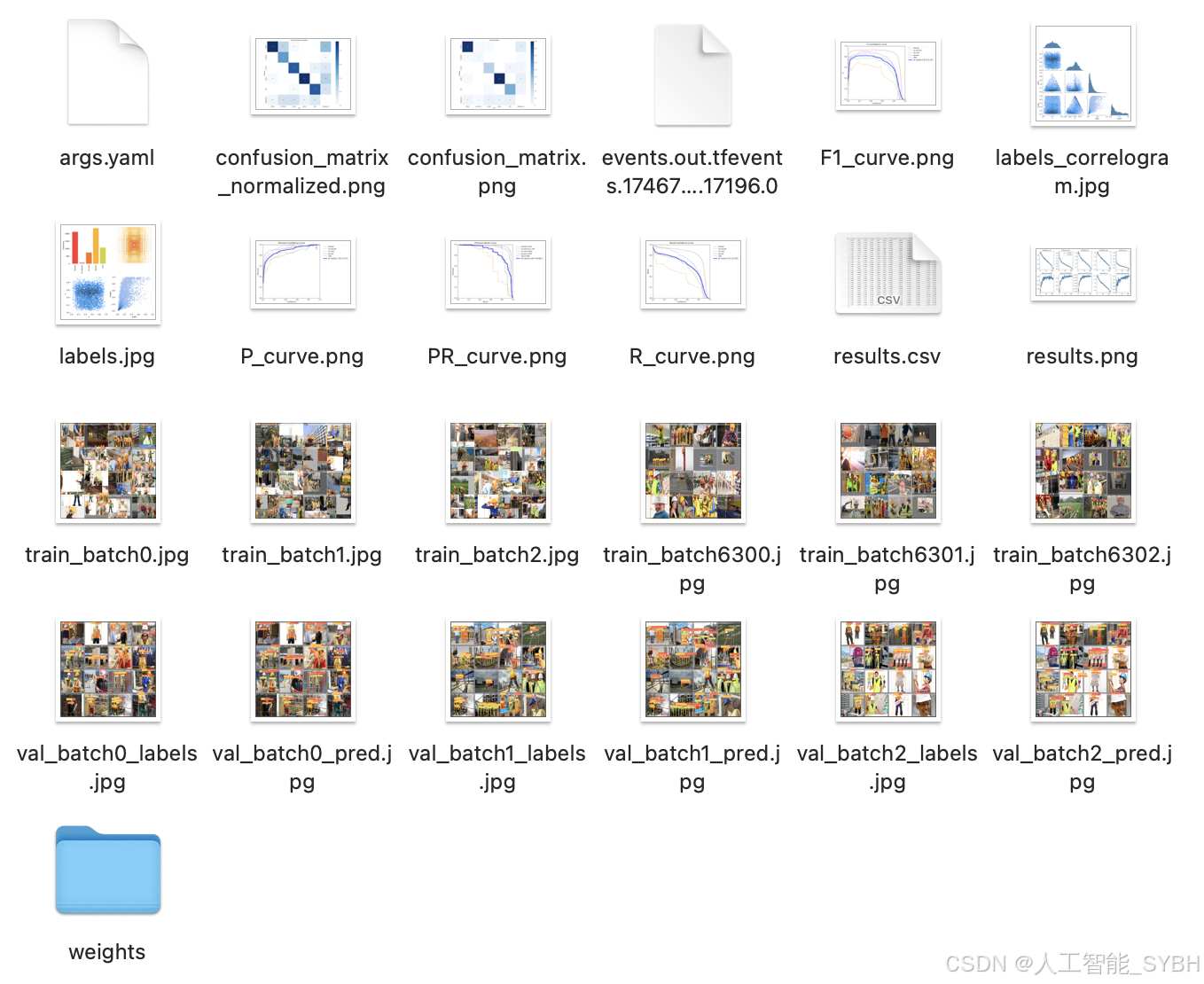

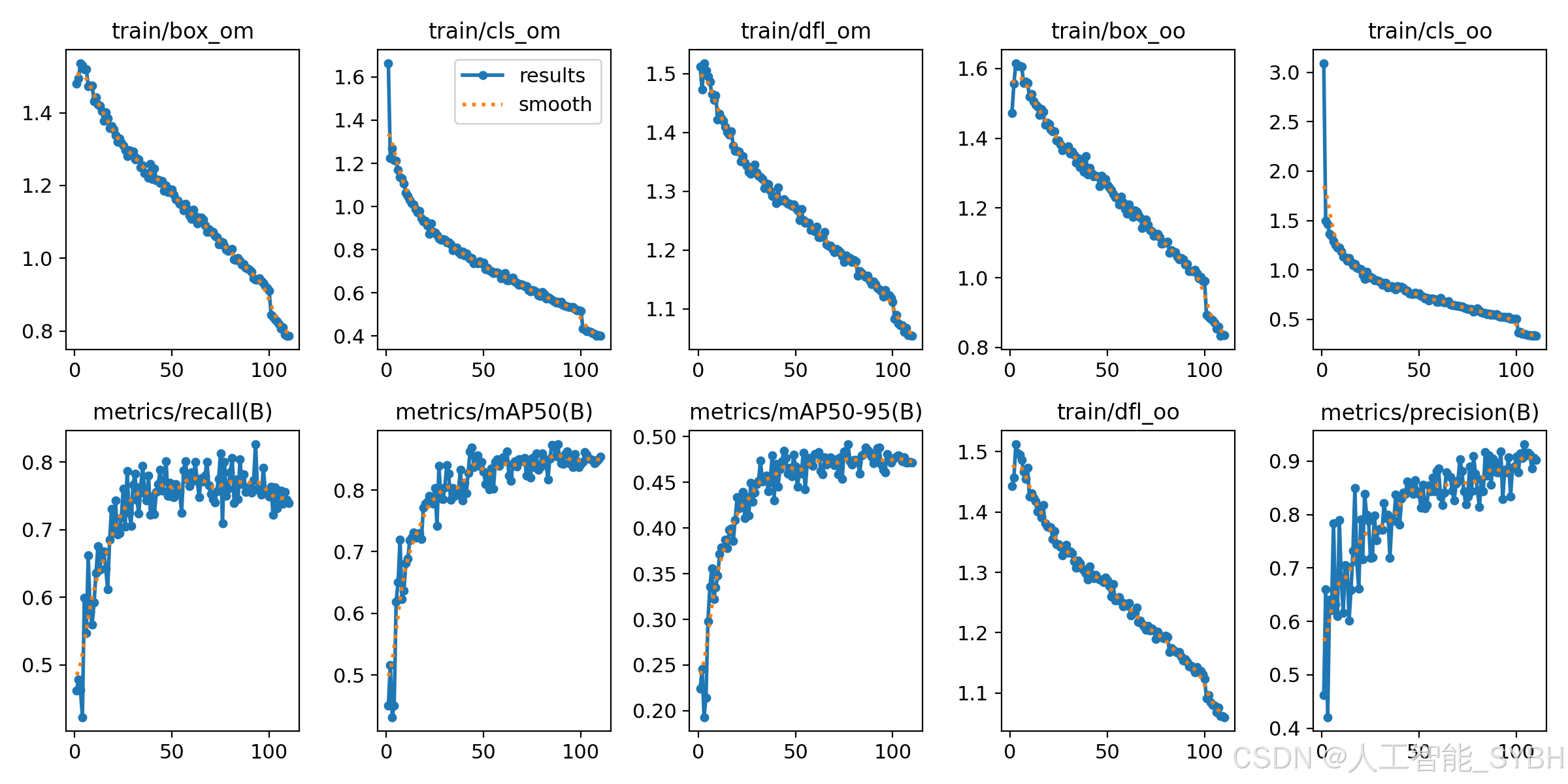

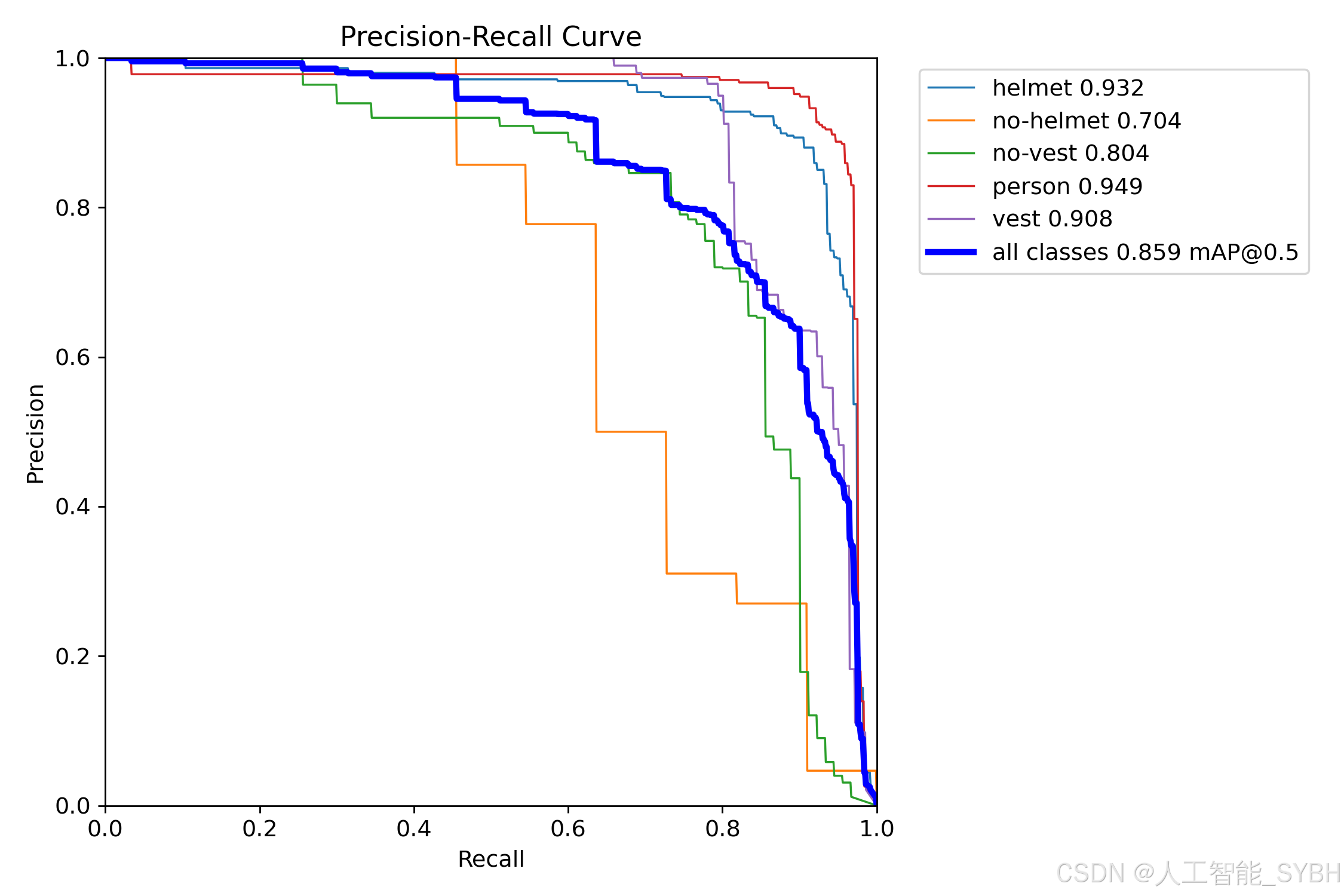

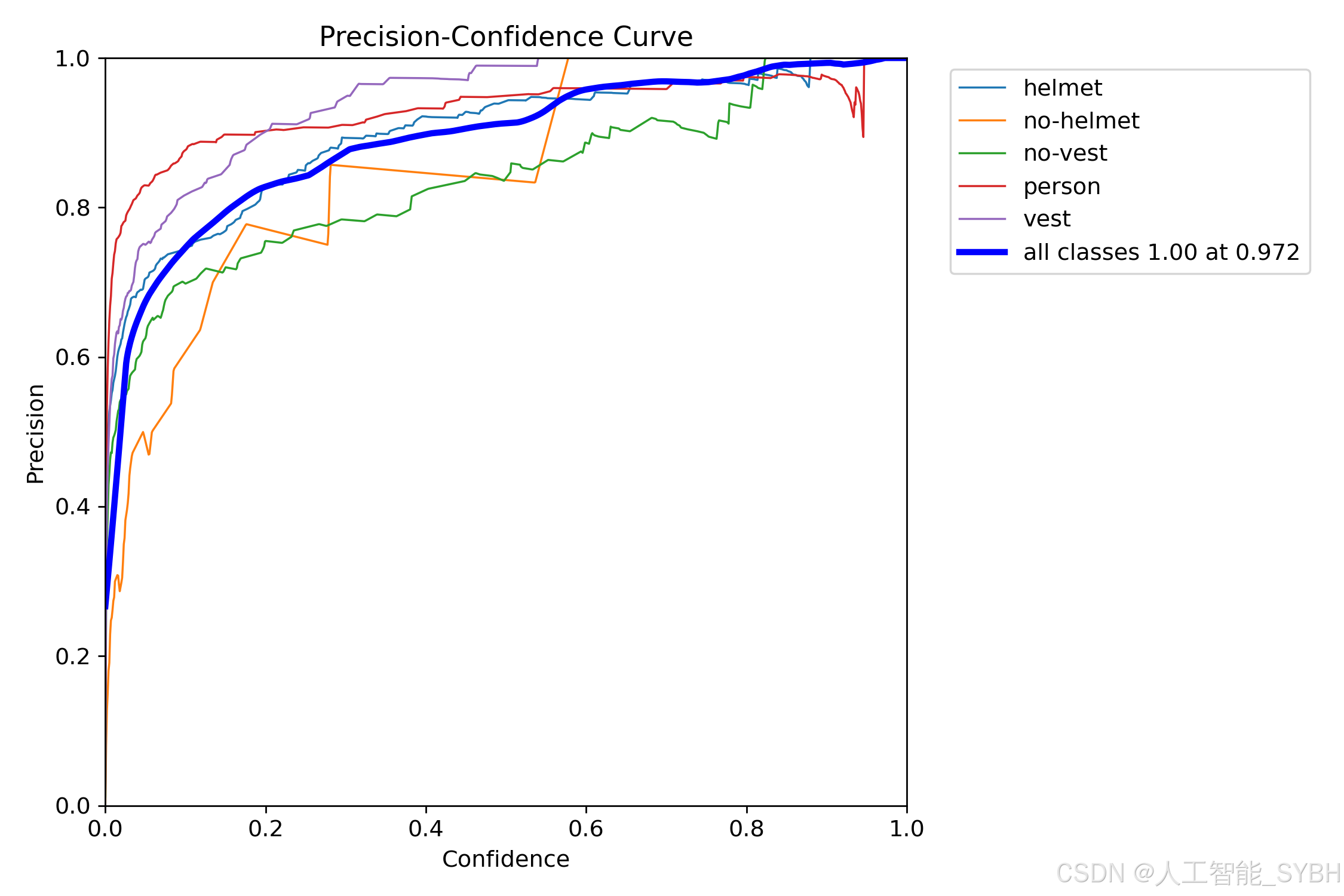

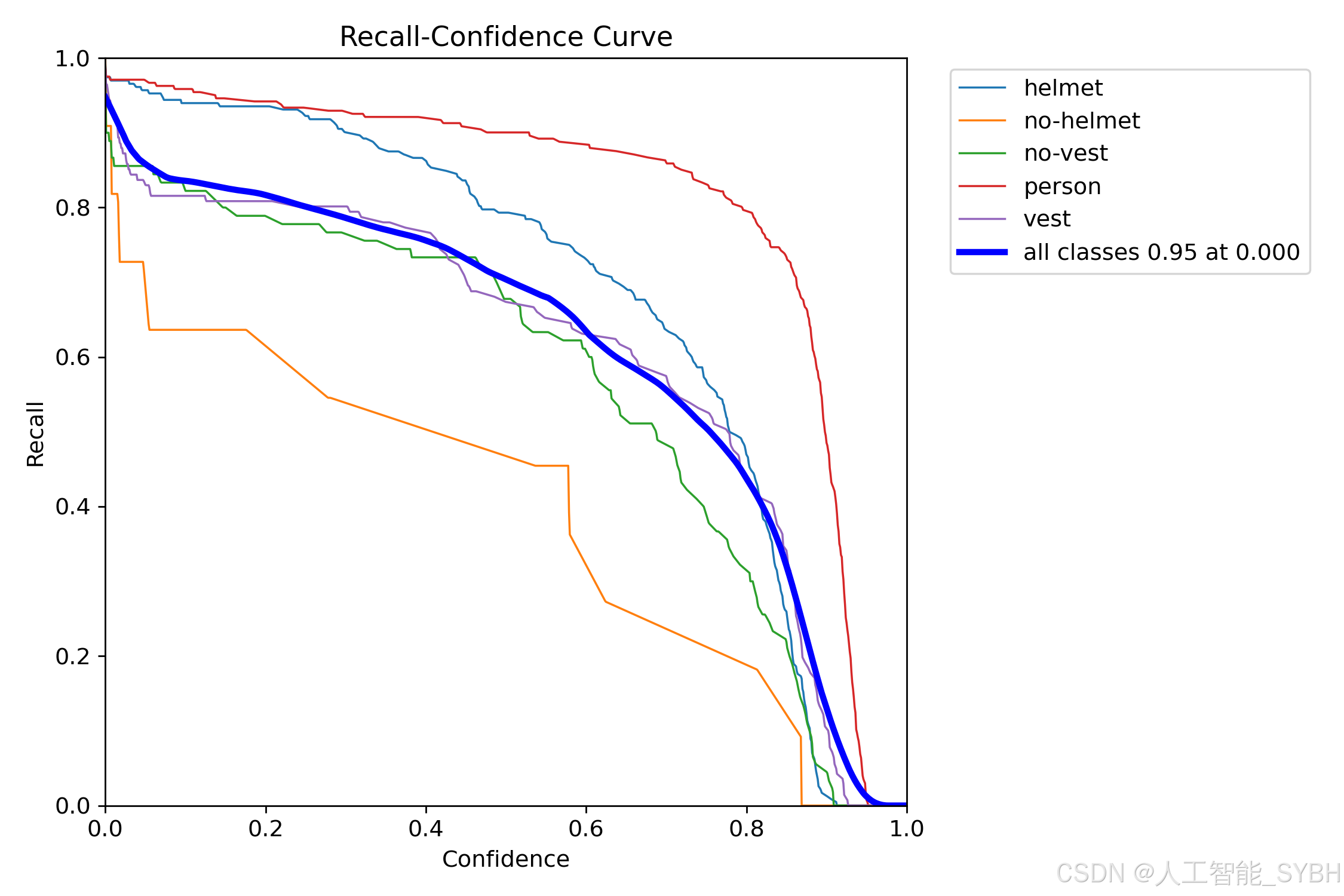

训练结果

六、核心代码

import sys

import cv2

import numpy as np

from PyQt5.QtWidgets import QApplication, QMessageBox, QFileDialog

from PyQt5.QtCore import QThread, pyqtSignal

from ultralytics import YOLOv10

from UiMain import UiMainWindow

import time

import os

class DetectionThread(QThread):

frame_received = pyqtSignal(np.ndarray, np.ndarray, list) # 原始帧, 检测帧, 检测结果

finished_signal = pyqtSignal() # 线程完成信号

def __init__(self, model, source, conf, iou, parent=None):

super().__init__(parent)

self.model = model

self.source = source

self.conf = conf

self.iou = iou

self.running = True

def run(self):

try:

if isinstance(self.source, int) or self.source.endswith(('.mp4', '.avi', '.mov')): # 视频或摄像头

cap = cv2.VideoCapture(self.source)

while self.running and cap.isOpened():

ret, frame = cap.read()

if not ret:

break

# 保存原始帧

original_frame = frame.copy()

# 检测

results = self.model(frame, conf=self.conf, iou=self.iou)

annotated_frame = results[0].plot()

# 提取检测结果

detections = []

for result in results:

for box in result.boxes:

class_id = int(box.cls)

class_name = self.model.names[class_id]

confidence = float(box.conf)

x, y, w, h = box.xywh[0].tolist()

detections.append((class_name, confidence, x, y))

# 发送信号

self.frame_received.emit(

cv2.cvtColor(original_frame, cv2.COLOR_BGR2RGB),

cv2.cvtColor(annotated_frame, cv2.COLOR_BGR2RGB),

detections

)

# 控制帧率

time.sleep(0.03) # 约30fps

cap.release()

else: # 图片

frame = cv2.imread(self.source)

if frame is not None:

original_frame = frame.copy()

results = self.model(frame, conf=self.conf, iou=self.iou)

annotated_frame = results[0].plot()

# 提取检测结果

detections = []

for result in results:

for box in result.boxes:

class_id = int(box.cls)

class_name = self.model.names[class_id]

confidence = float(box.conf)

x, y, w, h = box.xywh[0].tolist()

detections.append((class_name, confidence, x, y))

self.frame_received.emit(

cv2.cvtColor(original_frame, cv2.COLOR_BGR2RGB),

cv2.cvtColor(annotated_frame, cv2.COLOR_BGR2RGB),

detections

)

except Exception as e:

print(f"Detection error: {e}")

finally:

self.finished_signal.emit()

def stop(self):

self.running = False

class MainWindow(UiMainWindow):

def __init__(self):

super().__init__()

# 初始化模型

self.model = None

self.detection_thread = None

self.current_image = None

self.current_result = None

self.video_writer = None

self.is_camera_running = False

self.is_video_running = False

self.last_detection_result = None # 新增:保存最后一次检测结果

# 连接按钮信号

self.image_btn.clicked.connect(self.detect_image)

self.video_btn.clicked.connect(self.detect_video)

self.camera_btn.clicked.connect(self.detect_camera)

self.stop_btn.clicked.connect(self.stop_detection)

self.save_btn.clicked.connect(self.save_result)

# 初始化模型

self.load_model()

def load_model(self):

try:

model_name = self.model_combo.currentText()

self.model = YOLOv10(f"{model_name}.pt") # 自动下载或加载本地模型

self.update_status(f"模型 {model_name} 加载成功")

except Exception as e:

QMessageBox.critical(self, "错误", f"模型加载失败: {str(e)}")

self.update_status("模型加载失败")

def detect_image(self):

if self.detection_thread and self.detection_thread.isRunning():

QMessageBox.warning(self, "警告", "请先停止当前检测任务")

return

file_path, _ = QFileDialog.getOpenFileName(

self, "选择图片", "", "图片文件 (*.jpg *.jpeg *.png *.bmp)")

if file_path:

self.clear_results()

self.current_image = cv2.imread(file_path)

self.current_image = cv2.cvtColor(self.current_image, cv2.COLOR_BGR2RGB)

self.display_image(self.original_image_label, self.current_image)

# 创建检测线程

conf = self.confidence_spinbox.value()

iou = self.iou_spinbox.value()

self.detection_thread = DetectionThread(self.model, file_path, conf, iou)

self.detection_thread.frame_received.connect(self.on_frame_received)

self.detection_thread.finished_signal.connect(self.on_detection_finished)

self.detection_thread.start()

self.update_status(f"正在检测图片: {os.path.basename(file_path)}")

def detect_video(self):

if self.detection_thread and self.detection_thread.isRunning():

QMessageBox.warning(self, "警告", "请先停止当前检测任务")

return

file_path, _ = QFileDialog.getOpenFileName(

self, "选择视频", "", "视频文件 (*.mp4 *.avi *.mov)")

if file_path:

self.clear_results()

self.is_video_running = True

# 初始化视频写入器

cap = cv2.VideoCapture(file_path)

frame_width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH))

frame_height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT))

fps = cap.get(cv2.CAP_PROP_FPS)

cap.release()

# 创建保存路径

save_dir = "results"

os.makedirs(save_dir, exist_ok=True)

timestamp = time.strftime("%Y%m%d_%H%M%S")

save_path = os.path.join(save_dir, f"result_{timestamp}.mp4")

fourcc = cv2.VideoWriter_fourcc(*'mp4v')

self.video_writer = cv2.VideoWriter(save_path, fourcc, fps, (frame_width, frame_height))

# 创建检测线程

conf = self.confidence_spinbox.value()

iou = self.iou_spinbox.value()

self.detection_thread = DetectionThread(self.model, file_path, conf, iou)

self.detection_thread.frame_received.connect(self.on_frame_received)

self.detection_thread.finished_signal.connect(self.on_detection_finished)

self.detection_thread.start()

self.update_status(f"正在检测视频: {os.path.basename(file_path)}")

def detect_camera(self):

if self.detection_thread and self.detection_thread.isRunning():

QMessageBox.warning(self, "警告", "请先停止当前检测任务")

return

self.clear_results()

self.is_camera_running = True

# 创建检测线程 (默认使用摄像头0)

conf = self.confidence_spinbox.value()

iou = self.iou_spinbox.value()

self.detection_thread = DetectionThread(self.model, 0, conf, iou)

self.detection_thread.frame_received.connect(self.on_frame_received)

self.detection_thread.finished_signal.connect(self.on_detection_finished)

self.detection_thread.start()

self.update_status("正在从摄像头检测...")

def stop_detection(self):

if self.detection_thread and self.detection_thread.isRunning():

self.detection_thread.stop()

self.detection_thread.quit()

self.detection_thread.wait()

if self.video_writer:

self.video_writer.release()

self.video_writer = None

self.is_camera_running = False

self.is_video_running = False

self.update_status("检测已停止")

def on_frame_received(self, original_frame, result_frame, detections):

# 更新原始图像和结果图像

self.display_image(self.original_image_label, original_frame)

self.display_image(self.result_image_label, result_frame)

# 保存当前结果帧用于后续保存

self.last_detection_result = result_frame # 新增:保存检测结果

# 更新表格

self.clear_results()

for class_name, confidence, x, y in detections:

self.add_detection_result(class_name, confidence, x, y)

# 保存视频帧

if self.video_writer:

self.video_writer.write(cv2.cvtColor(result_frame, cv2.COLOR_RGB2BGR))

def on_detection_finished(self):

if self.video_writer:

self.video_writer.release()

self.video_writer = None

self.update_status("视频检测完成,结果已保存")

elif self.is_camera_running:

self.update_status("摄像头检测已停止")

else:

self.update_status("图片检测完成")

def save_result(self):

if not hasattr(self, 'last_detection_result') or self.last_detection_result is None:

QMessageBox.warning(self, "警告", "没有可保存的检测结果")

return

save_dir = "results"

os.makedirs(save_dir, exist_ok=True)

timestamp = time.strftime("%Y%m%d_%H%M%S")

if self.is_camera_running or self.is_video_running:

# 保存当前帧为图片

save_path = os.path.join(save_dir, f"snapshot_{timestamp}.jpg")

cv2.imwrite(save_path, cv2.cvtColor(self.last_detection_result, cv2.COLOR_RGB2BGR))

self.update_status(f"截图已保存: {save_path}")

else:

# 保存图片检测结果

save_path = os.path.join(save_dir, f"result_{timestamp}.jpg")

cv2.imwrite(save_path, cv2.cvtColor(self.last_detection_result, cv2.COLOR_RGB2BGR))

self.update_status(f"检测结果已保存: {save_path}")

def closeEvent(self, event):

self.stop_detection()

event.accept()

if __name__ == "__main__":

app = QApplication(sys.argv)

# 设置应用程序样式

app.setStyle("Fusion")

# 创建并显示主窗口

window = MainWindow()

window.show()

sys.exit(app.exec_())七、项目源码(视频下方简介内)

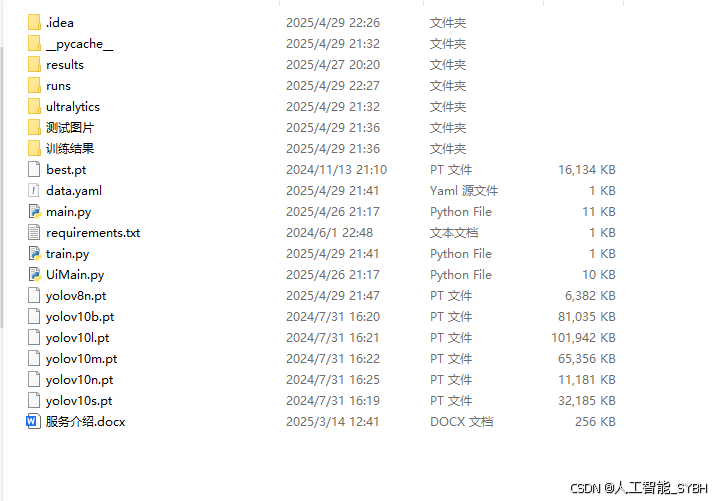

完整全部资源文件(包括测试图片、视频,py文件,训练数据集、训练代码、界面代码等),这里已打包上传至博主的面包多平台,见可参考博客与视频,已将所有涉及的文件同时打包到里面,点击即可运行,完整文件截图如下:

基于深度学习YOLOv10的工地安全帽防护衣检测系统(YOLOv10+YOLO数据集+UI界面+Python项目源码+模型)_哔哩哔哩_bilibili

基于深度学习YOLOv10的工地安全帽防护衣检测系统(YOLOv10+YOLO数据集+UI界面+Python项目源码+模型)

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献45条内容

已为社区贡献45条内容

所有评论(0)