[大模型] LLaMA系列大模型调研与整理-llama-alpaca-lora(部分)

最近尝试在领域数据进行生成式大模型的再训练和微调,在调研和实验中整理了一些项目&论文的基本信息,后续会持续完善和补充。

文章目录

- LLaMA大模型及其衍生模型

-

* 1\. LLaMA- 2. stanford_alpaca

- 3. ChatDoctor

- 4. alpaca-lora

- 5. Chinese-LLaMA-Alpaca

- 6. BELLE

- 大模型综述 A Survey of Large Language Models

关键词:大模型,LLaMA,Alpaca,Lora,Belle,模型训练,模型微调,指令微调

最近尝试在领域数据进行生成式大模型的再训练和微调,在调研和实验中整理了一些项目&论文的基本信息,后续会持续完善和补充。

LLaMA大模型及其衍生模型

1. LLaMA

项目地址 : https://github.com/facebookresearch/llama

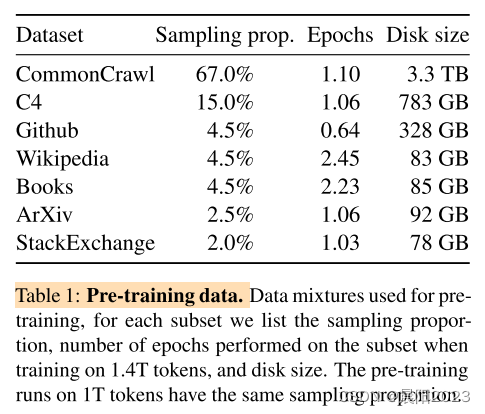

LLaMa语料数据如下,对各类语料又做了「去重、筛选」等,每种数据的处理方式有差别,具体见论文。语料中不包含中文数据。

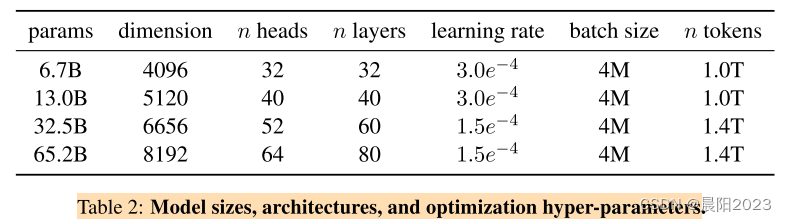

模型参数 :1.4T tokens, 2 epochs, 训练耗时65B模型: 2048 * 80G A100 * 21day,其他参数见下表:

相对于之前的大模型,LLaMa做了三点改进:

- GPT3在每层transformer之后做正则化,调整为在每层transformer之前做正则化,正则化采用RMSNorm;

- 相比PaLM,在激活函数上,使用SwiGLU替换ReLU非线性激活函数;

- 相比GPTNeo,在位置编码上,使用RoPE替代绝对位置编码;

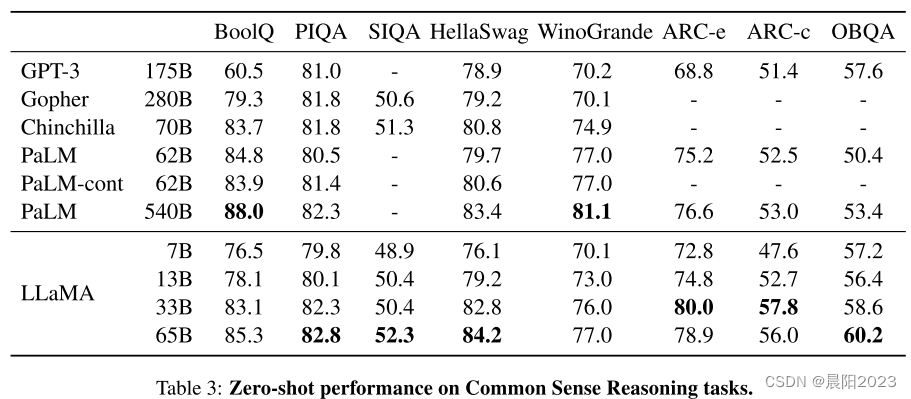

LLaMA相对其他大模型在零样本常识推理任务上的性能对比:

结论

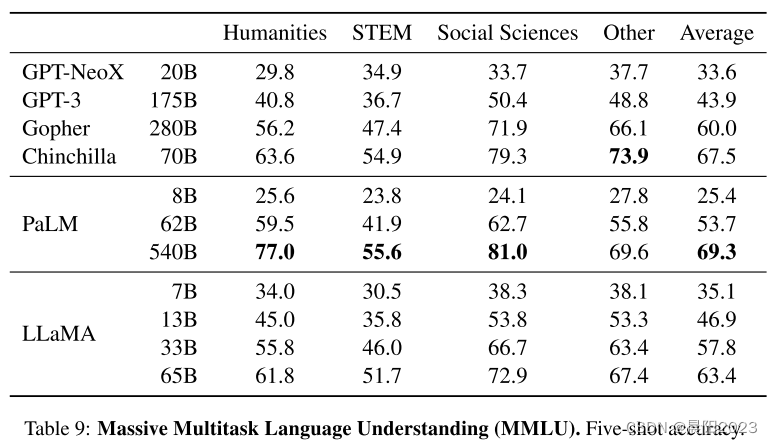

:在其他零样本、小样本任务上与各大模型进行性能对比,结果显示,LLaMA-13B在大多数任务上能够赶上GPT3,但模型大小不足GPT3的十分之一。LLaMA-65B与Chinchilla-70B/PaLM-540B在多个任务也具有一定的竞争力。

更重要的是LLaMA是chatGPT之后首个被广泛用作底座模型的开源大模型,为后续基于llama的衍生模型做出了极大的贡献

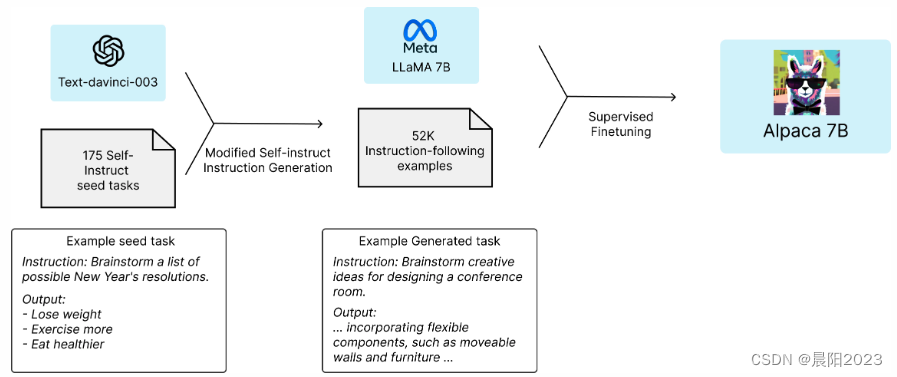

2. stanford_alpaca

项目地址 :https://github.com/tatsu-lab/stanford_alpaca

以llama做为底座模型,引入新的数据进行指令微调ISF,新数据采用self-instruct的方式有Text-

davinci-003进行生成,得到52k新数据进行微调训练。

本项目的贡献在于,提供了用于指令微调的数据生成方式,同时证明了ISF后模型效果的提升 ,其之后的很多项目均是基于这个思路。

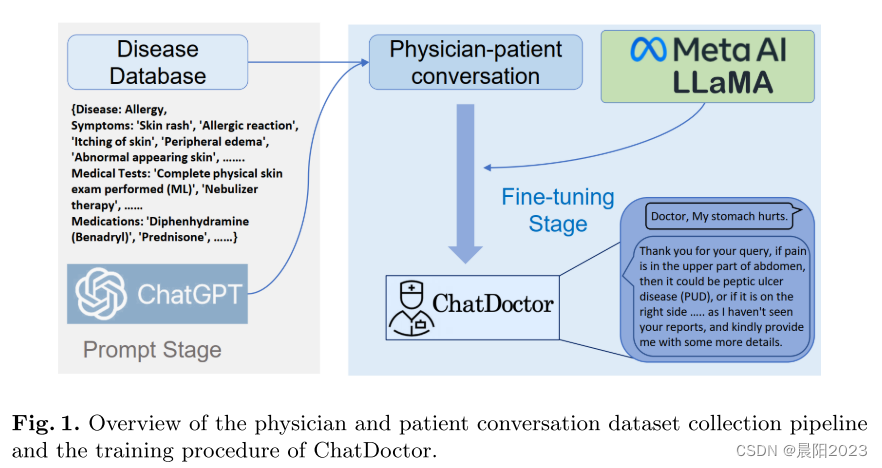

3. ChatDoctor

本项目可以看着是standford-aplaca方法在医疗领域的衍生,其借助chatGPT对结构化知识库生成ISF数据集的方法在后续项目的多被借鉴。

项目地址 : https://github.com/Kent0n-Li/ChatDoctor

基础模型 :llama-7b

指令样本构造 :Standford Alpaca 52k数据,700类疾病知识库借助ChatGPT生成的5k数据

指令样本量 :52k + 5k

任务评测 :对比ChatGPT在医学内容上进行提问,评估内容输出的准确性,ChatGPT 87%,ChatDocter 91%

模型发布 :ChatDocktor,模型在stanford alpaca的基础上进行再训练

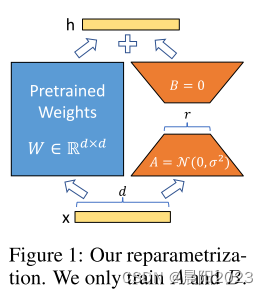

4. alpaca-lora

项目地址 : https://github.com/tloen/alpaca-lora

Alpaca-Lora (羊驼-Lora),在stanford-alpaca的基础上,使用 Lora (Low-rank Adaptation)

技术对模型进行指令微调,相当于是对模型进行轻量化训练,使得对显存的占用和训练时长都大幅度降低。在大模型训练高资源高成本的情况下,使用lora技术,牺牲少部分性能却使得大模型训练变得可行,在之后的项目中被广泛用到。

LoRa结构:在模型的Linear层的旁边,增加一个「旁支」,训练更新旁支参数替代模型参数。

5. Chinese-LLaMA-Alpaca

项目地址 : https://github.com/ymcui/Chinese-LLaMA-Alpaca

该项目值得被重点推荐和学习,ymcui在Bert时代[Chinese-BERT-wwm](https://github.com/ymcui/Chinese-

BERT-wwm)亦是杰出之作。

该项目在LLaMA的基础上扩充了中文词表并使用了中文数据进行二次预训练,同时中文Alpaca模型进一步使用了中文指令数据进行精调。保姆级说明文档及量化版本可轻松部署本地PC。

预训练数据 :通用中文语料(bert-wwm,macbert,lert,pert等语料)13.6M行

指令微调样本数据 :200w数据,中英文翻译500k + pCLUE 300k + Alpaca 100k(中/英)

6. BELLE

项目地址 :https://github.com/LianjiaTech/BELLE

基础模型 :bloom-7b, llama-7b

指令样本构造 :Standford Alpaca方法,chatGPT self-instruct

指令样本量 :20万、60万、100万和200万样本

任务评测 :在Extract, Classification, Closed QA,

和Summarization任务上,增加数据能持续带来效果的提升,还未达到瓶颈。在Translation, Rewrite,

和Brainstorming任务上,几十万的数据量就能获得较好的效果。在Math, Code,

和COT任务上,模型效果较差,而且增加数据量已经无法带来效果的提升。 https://github.com/ZrrSkywalker/LLaMA-

Adapter

模型发布 :BLOOMZ-7B1-xx,LLAMA-7B-xx,xx表示不同的指令样本量

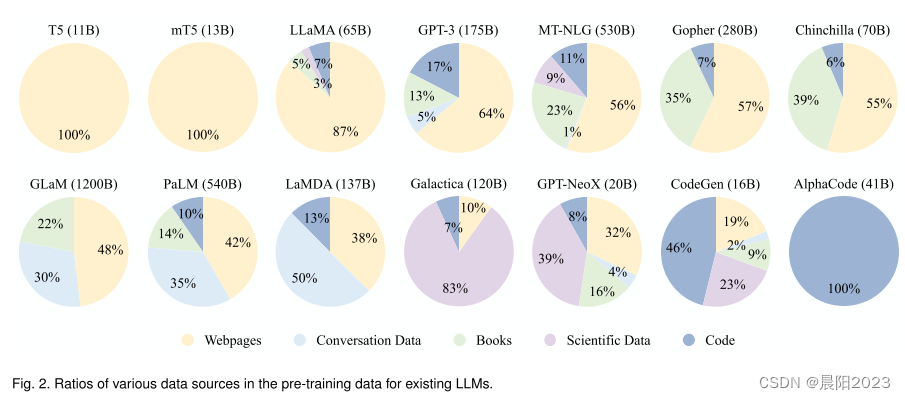

大模型综述 A Survey of Large Language Models

论文地址 :A Survey of Large Language

Models

4月份发表在arXiv上的大模型综述,包括了大模型的发展历程、各大模型的关键参数、训练语料的处理方法及数据类型,以及大模型训练的流程等,对于全面了解认识大模型很有帮助。

-

大模型发展历程:

- 各大模型关键信息 :

-

LLM语料从内容类型上可以分为六大类 :Books, CommonCrawl, Reddit links, Wikipedia, Code, and others.

语料数据包括了通用数据和专业数据,通用数据的多样性能提高模型的泛化性和语言理解能力,专业数据能够赋予LLM特定的任务解决能力。

高质量数据可能在很大程度上影响LLM的性能,因此需要对原始语料进行过滤,包括去除有噪声、冗余、不相关和潜在毒性的数据。

LLM训练前的数据处理流程:

AI时代的职场新潮流

听说AI要来抢工作了?别担心,新岗位可比旧岗位有趣多了!想象一下,你从搬砖工升级成了机器人操作员,从算盘小能手变成了大数据分析师,这不是美滋滋吗?所以,社会生产效率提升了,我们也能更轻松地工作。不过,想成为AI界的佼佼者?那就得赶紧学起来,不然就会被同行们甩得连AI的尾巴都摸不着了!

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献50条内容

已为社区贡献50条内容

所有评论(0)