开源文生语音扩散模型:PlayDiffusion

PlayDiffusion是一种基于扩散模型的语音编辑新方法,克服了传统自回归模型在音频修改中的局限性。该方法首先将音频编码为离散标记,掩码目标区域后利用扩散模型进行上下文感知的去噪处理,并通过BigVGAN解码器还原波形。模型采用非因果注意力机制和定制分词器提高效率,并整合说话人特征确保音色一致。训练中随机掩码音频标记,通过迭代解码逐步优化预测,最终实现高质量、连贯的语音编辑效果。该方法为动态语

PlayDiffusion 模型速览

一、引言

PlayDiffusion 论文开头指出,自回归变换器模型在从文本合成语音方面表现出色,但在修改生成音频的一部分(称为修复)或删除部分而不留下不连续伪影方面存在显著局限性。传统方法要么重新生成整个句子导致计算成本高且韵律变化,要么仅替换单词导致边界伪影,要么从中间点重新生成可能改变未编辑部分的韵律。因此,需要不同的方法来构建更通用的语音编辑工具。论文以修改句子 “The answer is out there, Neo. Go grab it!” 中的 “Neo” 为 “Trinity” 为例,说明传统自回归模型在处理这类语音编辑任务时的不足,从而引出非自回归方法的优势。

二、PlayDiffusion 模型

PlayDiffusion 是一种新颖的基于扩散模型的音频语音编辑方法,工作流程如下:

-

将音频序列编码到离散空间,把波形转换为更紧凑的表示形式,每个单位称为一个标记(token),该过程适用于真实语音和语音合成模型生成的音频。

-

当需要修改音频片段时,掩码(mask)目标部分。

-

使用基于更新文本的扩散模型对掩码区域进行去噪,在此过程中,保留周围上下文,确保平滑过渡和一致的说话人特征。

-

最终输出标记序列通过 BigVGAN 解码器模型转换回语音波形,且解码器基于从原始片段提取的说话人嵌入进行条件约束。

PlayDiffusion 模型利用非自回归扩散模型,在编辑边界更好地保持上下文,从而实现高质量、连贯的音频编辑,是音频编辑能力的重要进步,为动态、细粒度的语音修改铺平了道路。

三、训练

PlayDiffusion 的训练基于预训练的只解码器文本变换器架构,并进行了针对音频生成的关键修改:

-

非因果掩码:与标准只解码器 LLM(如 GPT)使用因果注意力不同,修改后的 Llama 实现采用非因果注意力头,使模型能同时利用过去、现在和未来的标记。

-

自定义分词器和嵌入压缩:为提高效率,尤其是对于英语语音合成,使用仅包含 10,000 个文本标记的自定义字节对编码(BPE)分词器,大幅减小嵌入表尺寸,提升计算速度且不降低音频质量。

-

说话人条件:模型整合来自预训练嵌入模型的说话人条件,该模型可将不同长度的波形映射到固定大小的向量,捕捉关键说话人特征,确保合成或编辑的音频片段保持一致的语音身份。

在训练过程中,类似 MaskGCT,随机掩码一定比例的音频标记。模型基于说话人嵌入、文本输入和剩余未掩码音频标记提供的上下文,学习准确预测这些掩码标记。给定不同时步的文本样本 x_t 和文本条件 C,模型损失定义为特定公式,掩码 m_{t,i} 也有明确的定义。在推理阶段,解码从完全掩码的标记序列开始,通过多个步骤(指定为 T)进行,具体步骤如下:

-

初步预测:在每次迭代中,模型基于当前掩码音频和文本输入生成初步预测 X̂₀。

-

置信度评分:标记根据模型预测获得置信度评分,新预测的(之前掩码的)标记置信度等同于其预测概率,而先前确定的标记置信度评分保持为 1。

-

自适应重新掩码:利用逐渐递减的时间表 γ,选择特定数量的最低置信度标记在后续迭代中重新掩码,随着迭代进行,重新掩码的标记数量逐渐减少,使模型的优化工作集中于不确定性最高的区域。

这一迭代解码过程持续到所有步骤完成,逐步完善标记预测,生成连贯、高质量的音频输出。

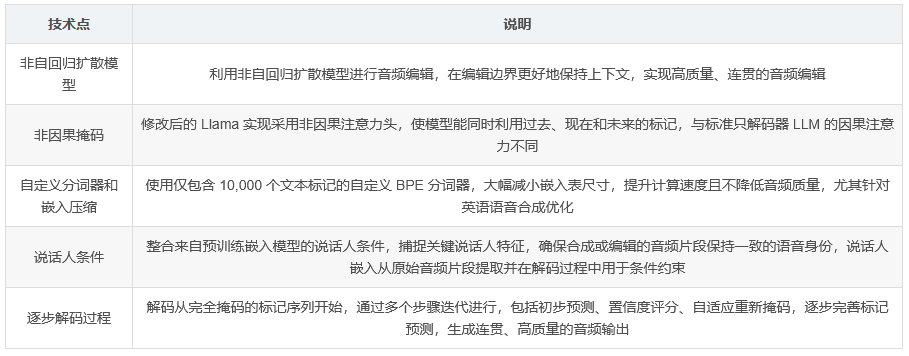

四、核心技术汇总

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)