凭借这项HMI设计黑科技,轻松实现高效人机协作

你有没有想过,为什么有些设备一上手就“秒懂”,而有些明明功能强大,却总让人一头雾水?其实这背后,藏着一个关键的“幕后推手”——HMI(人机界面)设计。随着人工智能、语音识别、手势交互等技术的飞速发展,HMI正在从“能用”向“好用”、“聪明”进化。一种被称为“情境感知型HMI”的设计理念正悄然兴起,它能让设备像懂你一样,提前预判你的需求,主动提供帮助。什么是“情境感知型HMI”?它是如何让机器变得更

凭借这项HMI设计黑科技,轻松实现高效人机协作

【内容摘要】

你有没有想过,为什么有些设备一上手就“秒懂”,而有些明明功能强大,却总让人一头雾水?

其实这背后,藏着一个关键的“幕后推手”——HMI(人机界面)设计。

随着人工智能、语音识别、手势交互等技术的飞速发展,HMI正在从“能用”向“好用”、“聪明”进化。一种被称为“情境感知型HMI”的设计理念正悄然兴起,它能让设备像懂你一样,提前预判你的需求,主动提供帮助。

这篇文章将为你揭开:

- 什么是“情境感知型HMI”?

- 它是如何让机器变得更“聪明”的?

- 这种设计理念在哪些领域已经落地应用?

- 普通人也能参与HMI设计吗?

如果你也好奇未来的智能设备会有多“贴心”,那就别错过这场关于未来人机协作的深度解析!

一、什么是情境感知型HMI?它为何是未来人机交互的新趋势?

很多人以为HMI就是“把按钮画在屏幕上”,其实不然。真正高级的HMI,不仅要能“看懂”用户操作,还要能“读懂”用户意图。

情境感知型HMI = 感知环境 + 理解行为 + 主动响应

简单来说,就是系统不仅能被动接受指令,还能根据当前场景、用户习惯和上下文信息,做出更智能的判断和反馈。

✅ 它的核心能力:

|

能力 |

描述 |

|

感知环境 |

利用传感器获取时间、地点、光线、声音等外部信息 |

|

理解行为 |

分析用户的操作习惯、语音语义、眼动轨迹等行为数据 |

|

预测意图 |

基于历史数据与当前状态预测下一步可能需要什么 |

|

主动响应 |

在用户还没开口前,自动调整设置或提供提示 |

📌 小贴士:就像一位经验丰富的助手,不仅听你说话,还能猜你想做什么。

✅ 它的应用场景有哪些?

|

场景 |

应用示例 |

|

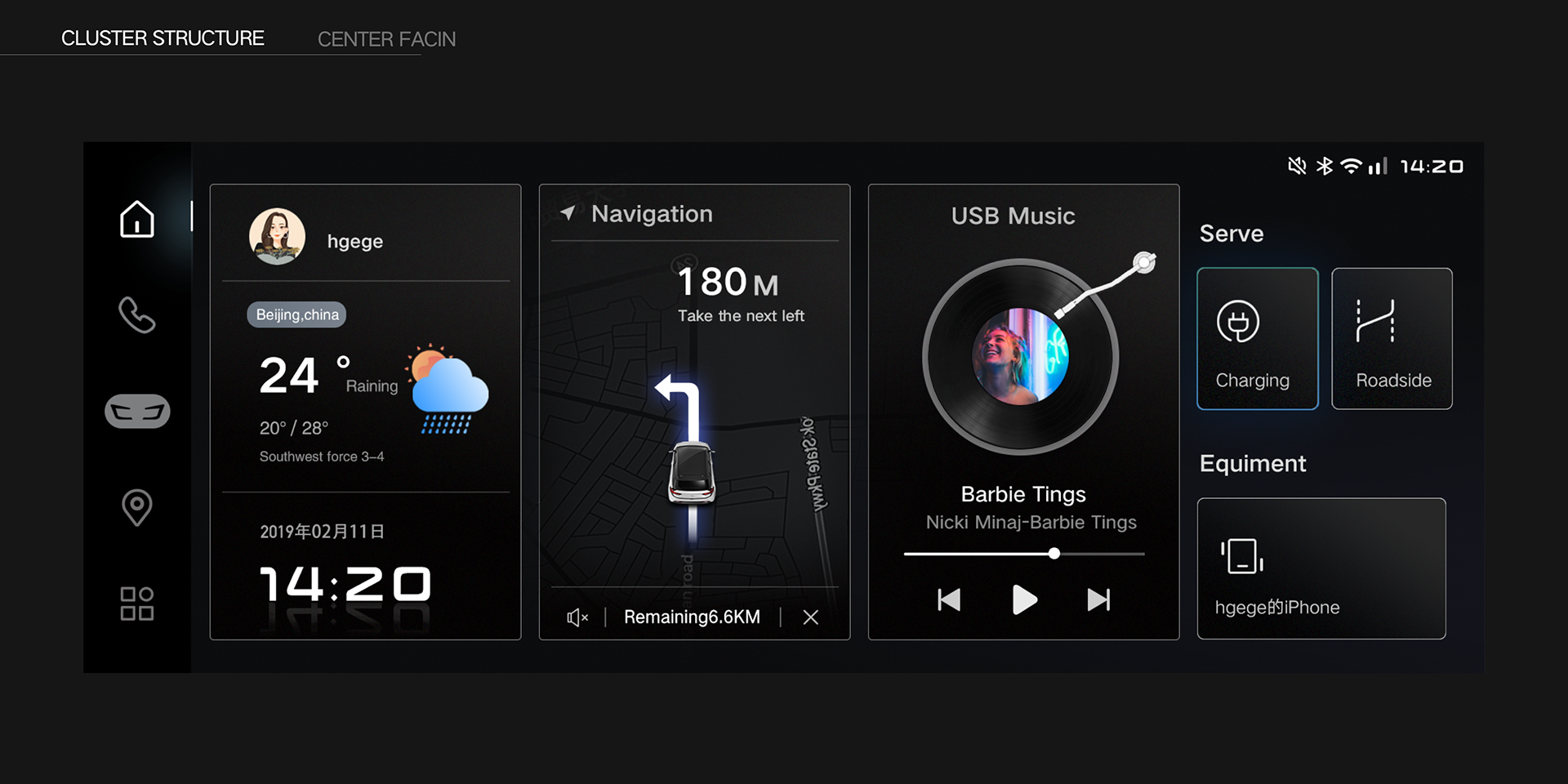

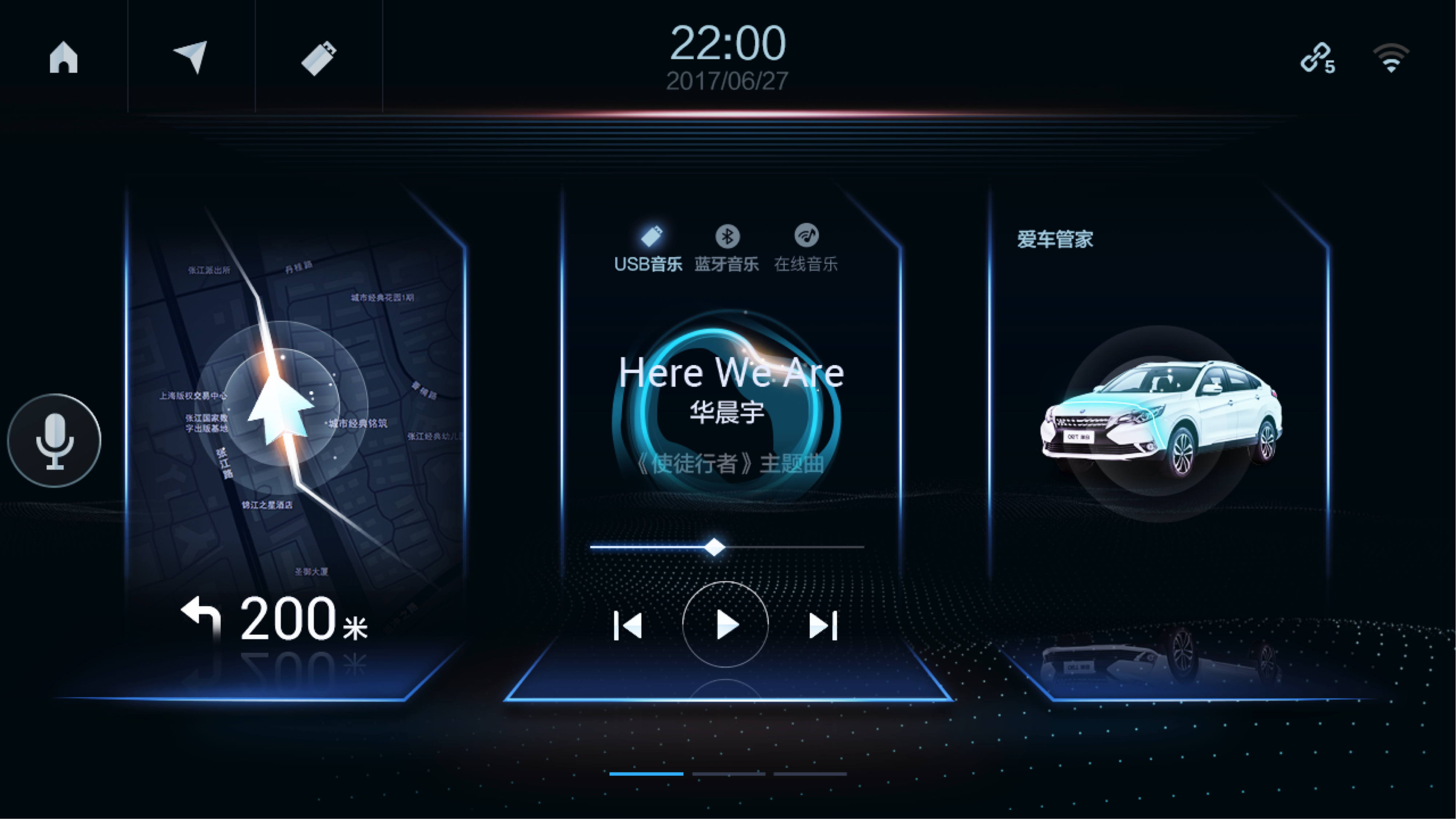

智能汽车 |

根据驾驶路线自动打开导航、调节空调温度 |

|

智能家居 |

回家时自动开灯、播放音乐、调节窗帘 |

|

工业设备 |

根据操作员动作提醒安全风险、提供辅助指导 |

|

医疗设备 |

根据病人状态自动调整参数并报警异常情况 |

📌 实战建议:真正的智能不是炫技,而是让用户感觉不到复杂。

二、传统HMI的局限性 VS 情境感知型HMI的优势

虽然很多产品都号称“智能”,但大多数HMI仍然停留在“你点我动”的阶段,缺乏主动性和个性化服务。

🧨 传统HMI的常见痛点:

|

问题 |

表现 |

|

被动响应 |

用户不说不做,说不清楚也做错 |

|

缺乏记忆 |

每次都要重新设置,不记得上次怎么用的 |

|

不懂场景 |

明明是晚上,还显示白天模式;明明下雨天,还在推荐户外活动 |

|

操作繁琐 |

功能藏得太深,调个设置要进三级菜单 |

📌 结果:用户体验差、学习成本高、使用频率低。

✅ 情境感知型HMI的显著优势:

|

对比维度 |

传统HMI |

情境感知型HMI |

|

交互方式 |

被动响应 |

主动引导 |

|

个性化程度 |

单一模板 |

自适应用户习惯 |

|

使用门槛 |

较高 |

极低 |

|

学习曲线 |

需要培训 |

自然上手 |

|

安全性 |

易误操作 |

提前预警、辅助判断 |

📌 总结一句话:它不是让你去适应机器,而是让机器来理解你。

三、情境感知型HMI是如何实现的?核心技术揭秘

听起来很“黑科技”,但其实它背后的原理并不难理解。以下是几个关键技术支撑:

🔑 技术1:多模态输入融合

✅ 是什么:

通过摄像头、麦克风、传感器等多种渠道收集用户信息。

✅ 应用示例:

- 手势控制:挥手切歌、比划调音量

- 语音识别:说“我要回家了”自动规划路线

- 眼动追踪:识别注意力焦点,优先展示关键信息

📌 实战建议:多种感官输入协同工作,比单一方式更准确。

🔑 技术2:AI行为建模

✅ 是什么:

利用人工智能分析用户行为,建立个性化模型。

✅ 应用示例:

- 自动学习用户的常用操作路径

- 推荐最可能使用的功能组合

- 预测用户情绪状态并调整交互语气

📌 工具推荐:TensorFlow Lite、PyTorch Mobile、阿里云NLP

🔑 技术3:上下文感知计算

✅ 是什么:

结合时间、地点、天气、日程等信息进行综合判断。

✅ 应用示例:

- 上班高峰期自动避开拥堵路线

- 下雨天提醒带伞、切换室内运动计划

- 夜间自动调暗屏幕亮度、降低音量

📌 实战建议:信息越多,判断越准,体验越自然。

🔑 技术4:边缘计算与实时反馈

✅ 是什么:

不再依赖云端处理,本地快速响应,提升交互流畅度。

✅ 应用示例:

- 车载系统在0.1秒内识别手势并执行

- 医疗设备实时监测生命体征并预警

- 家电根据用电高峰自动节能运行

📌 小贴士:延迟越低,体验越真实。

四、情境感知型HMI如何落地?四步教你打造“懂你”的智能系统

如果你想尝试开发或优化一款具备情境感知能力的HMI系统,可以按照以下四个步骤推进:

🛠️ 第一步:定义核心场景 —— 先搞清楚你要解决什么问题

✅ 推荐做法:

- 画出用户在不同时间、地点、状态下的典型行为流程

- 找出其中最容易出错、最麻烦、最常被忽略的环节

📌 实战建议:不要试图满足所有人,先聚焦高频场景。

🛠️ 第二步:构建感知能力 —— 让系统“看得见、听得懂”

✅ 推荐做法:

- 引入必要的传感器、摄像头、语音模块

- 选择合适的AI算法进行行为识别与预测

📌 工具推荐:OpenCV、Google MediaPipe、科大讯飞SDK

🛠️ 第三步:设计智能反馈机制 —— 让系统“会说话、会思考”

✅ 推荐做法:

- 设置触发条件(如“连续三次未完成某操作→弹出引导”)

- 设计自然的反馈方式(如语音提示、震动、灯光变化)

📌 实战建议:反馈要有节奏感,不能打扰也不能太迟钝。

🛠️ 第四步:持续迭代优化 —— 让系统越来越“懂你”

✅ 推荐做法:

- 收集用户行为数据(注意隐私合规)

- 分析使用路径与错误率

- 定期更新模型与界面逻辑

📌 实战建议:好的HMI从来不是一次做完的,而是不断成长的。

总结

情境感知型HMI不是科幻电影里的幻想,而是正在改变我们与设备互动方式的一项实用技术。它通过感知环境、理解行为、预测意图、主动响应,让机器变得更“聪明”、更“贴心”。

总结一下本文的核心观点:

|

对比维度 |

传统HMI |

情境感知型HMI |

|

交互方式 |

被动响应 |

主动引导 |

|

用户体验 |

复杂、需学习 |

自然、易上手 |

|

个性化程度 |

固定不变 |

自适应用户习惯 |

|

技术基础 |

单一输入 |

多模态融合+AI建模 |

|

发展趋势 |

静态固化 |

持续进化、个性学习 |

总结:未来的智能设备,不再是冷冰冰的机器,而是越来越像一位“懂你、帮你、陪伴你”的生活伙伴。而这一切,都离不开HMI设计的进步。希望这篇文章能让你看到技术背后的温度,也激发你对未来人机协作的无限想象。记住一句话:“真正的智能,不是替你做决定,而是帮你更好地做决定。”

本人是10年经验的前端开发和UI设计资深“双料”老司机,1500+项目交付经历,带您了解最新的观点、技术、干货,下方微信我可以和我进一步沟通。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)