dify的简单使用

dify的模型下载以及配置

目录

上一篇我们讲述了dify的安装,接下来我们讲一下dify的简单使用,也是对所学的一次巩固。

一、模型配置

1.ollama的安装

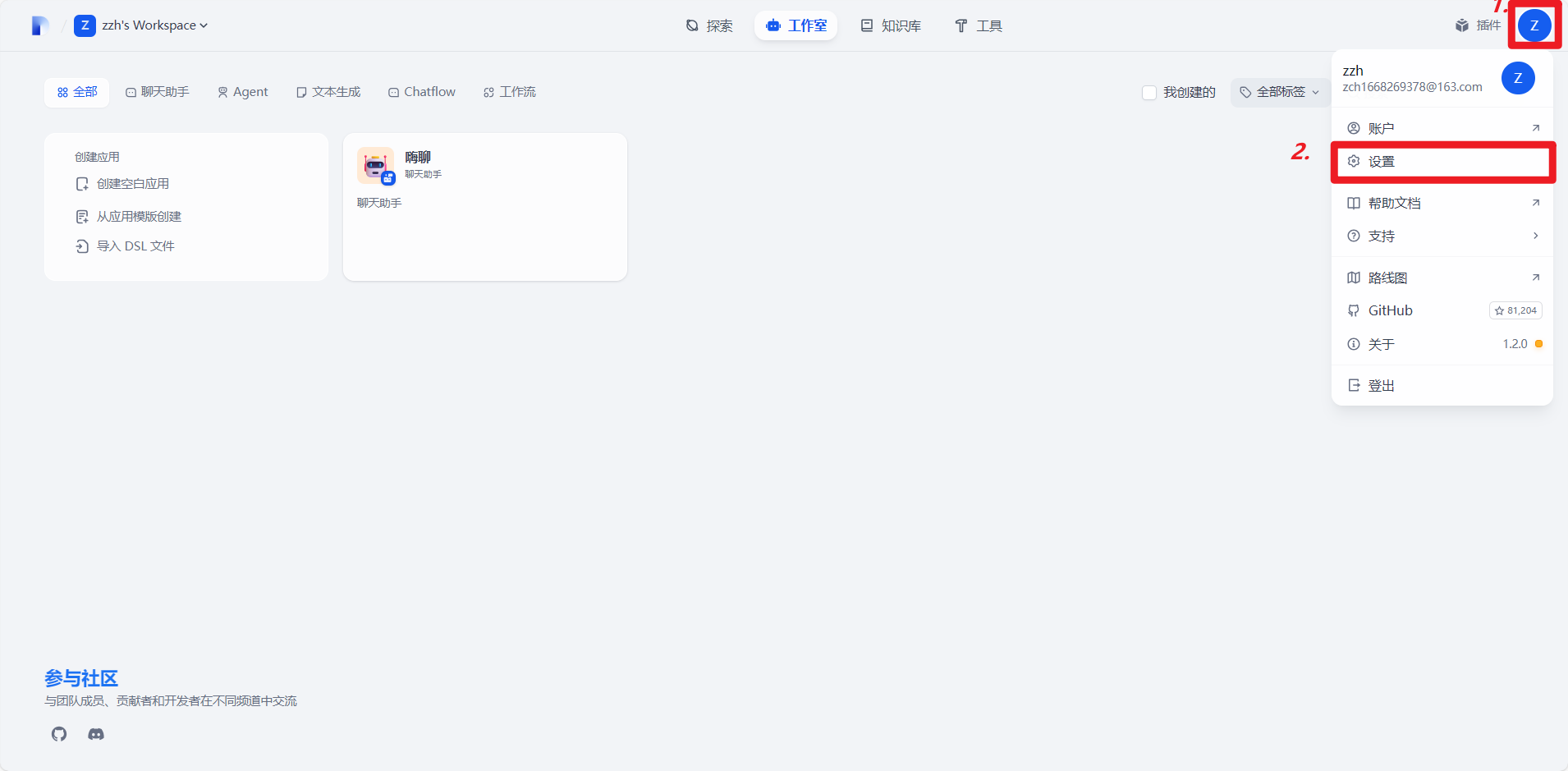

打开dify后点击右上角的个人主页,然后点击设置。

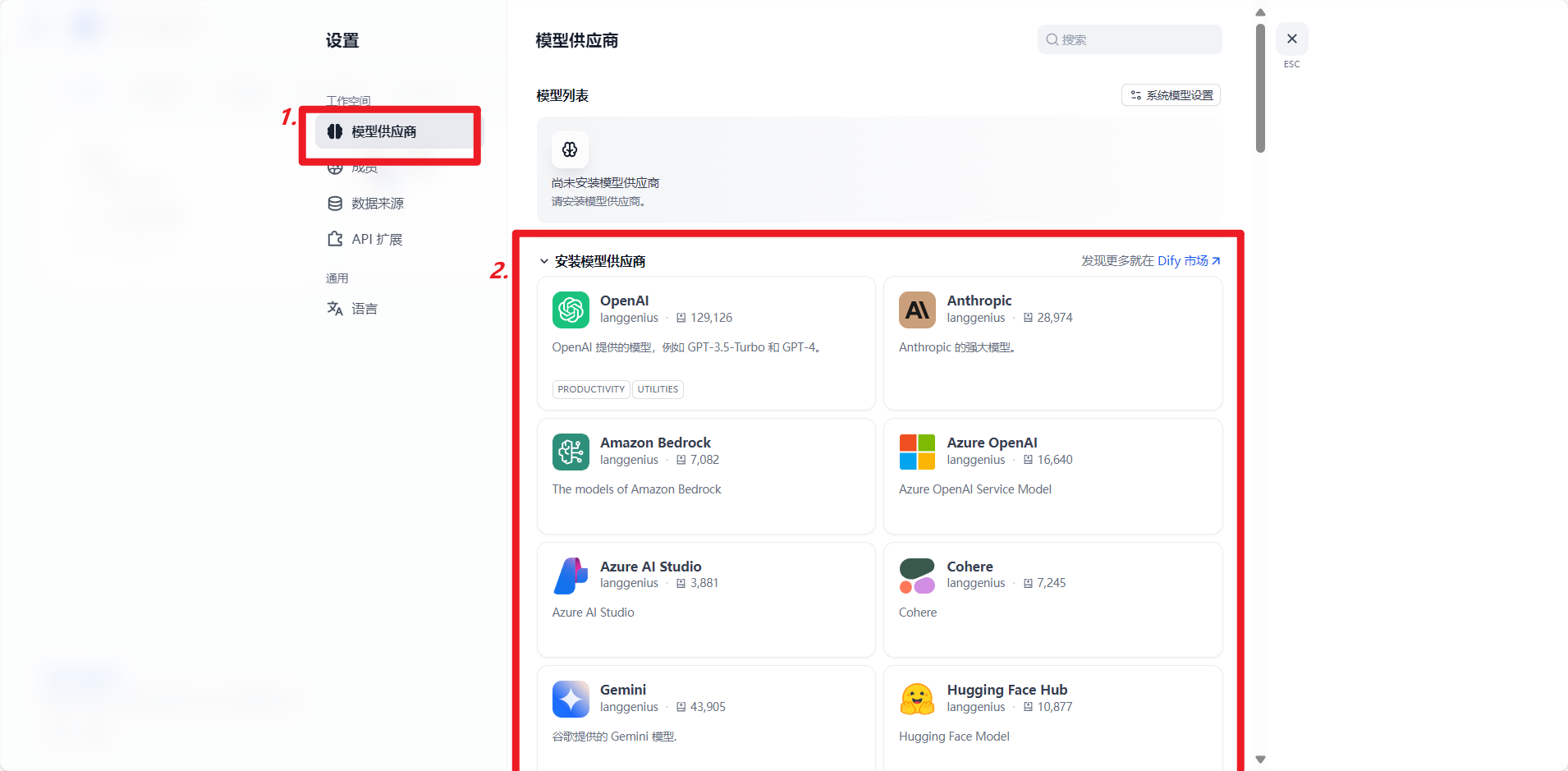

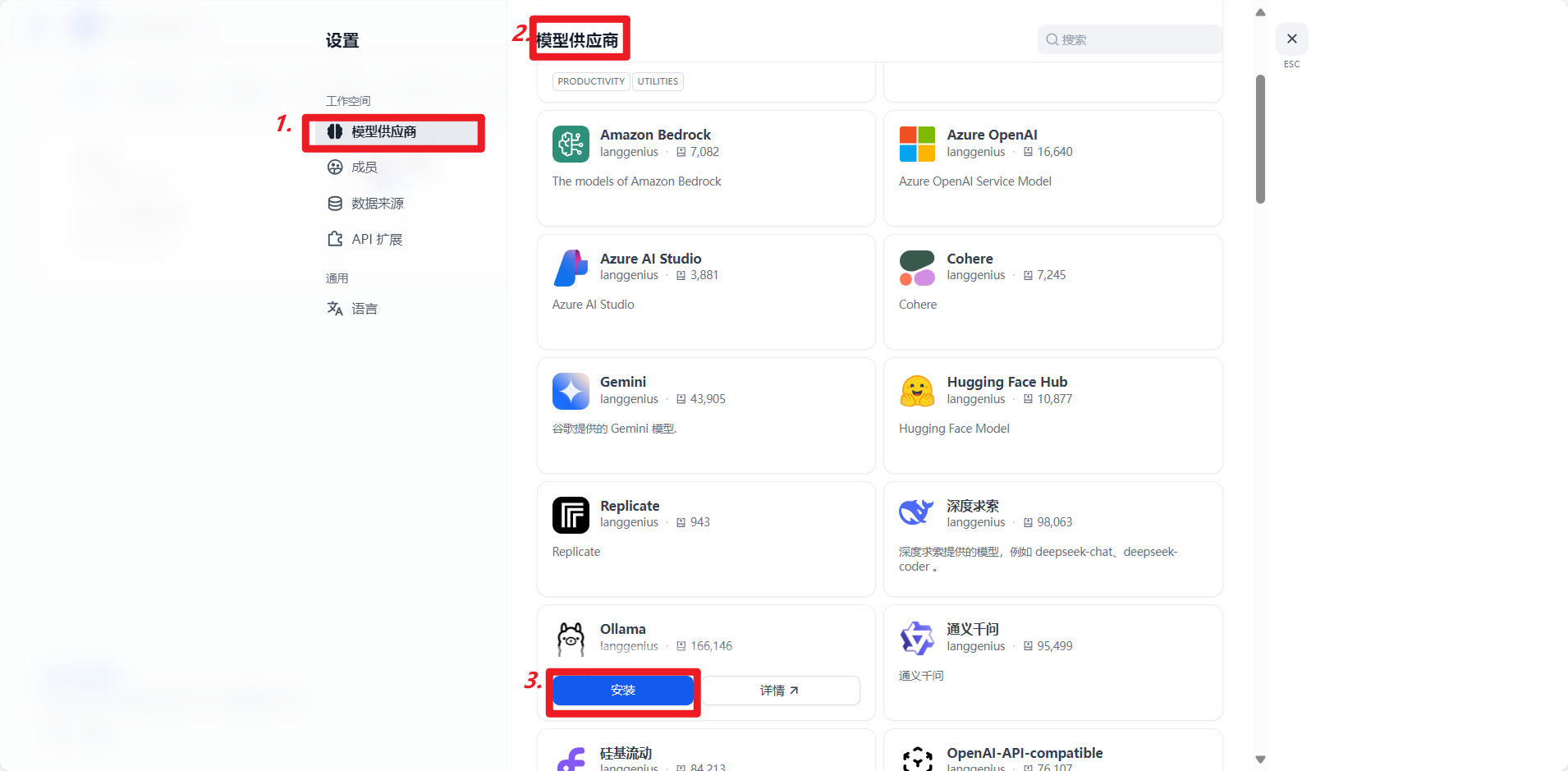

然后在跳转页面点击模型供应商,在安装模型供应商里选择自己想安装的模型就好,我目前使用的ollama,在下面找到ollama点击安装即可。傻瓜式安装。

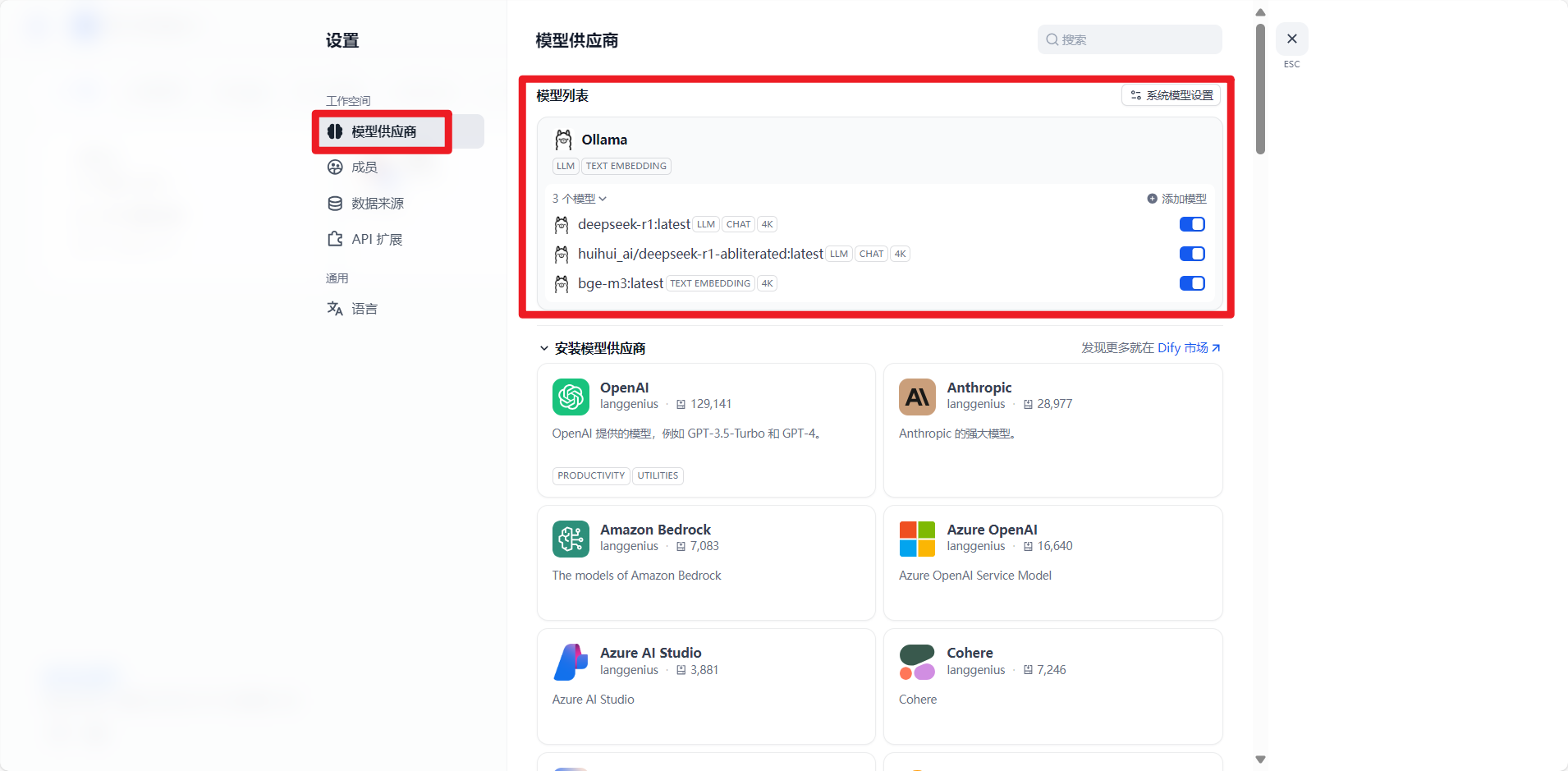

安装好后会出现在模型列表中,如果没有就多刷新几下多安装几次。下面三个是我已经安装好的,你们没有,只要出现ollama就好。

这里需要注意一下,我每次打开dify发现我安装的哪里就没东西,这个时候下面模型供应商在点一下ollama的安装就会重新出现(以我的ollama为例)他只是没显示,但之前的配置还在,就像我下面那三个接入的模型。

安装好后就是模型的下载了。

2.相关模型的下载

打开ollama的网址:Ollama

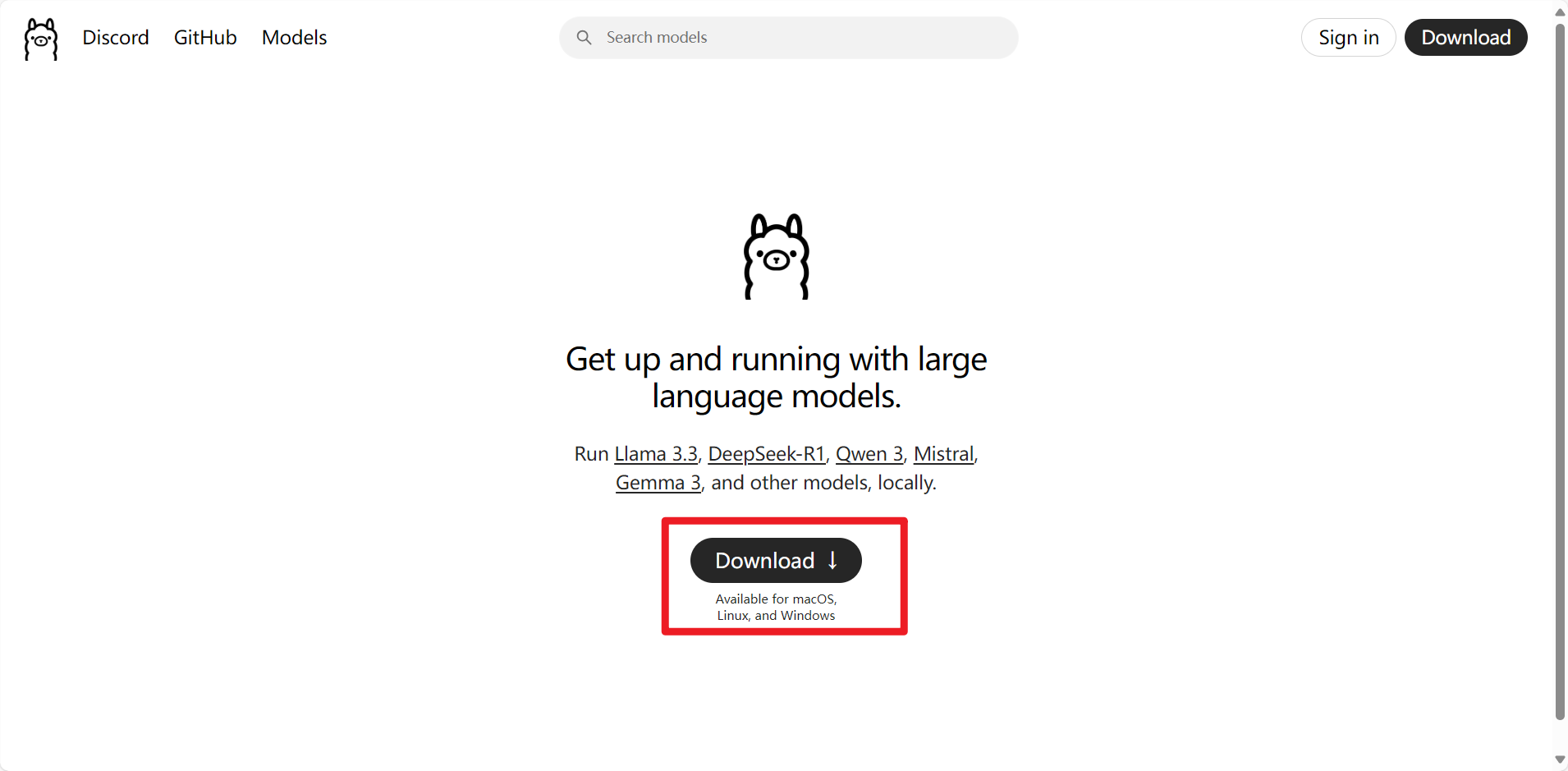

首先下载安装ollama:

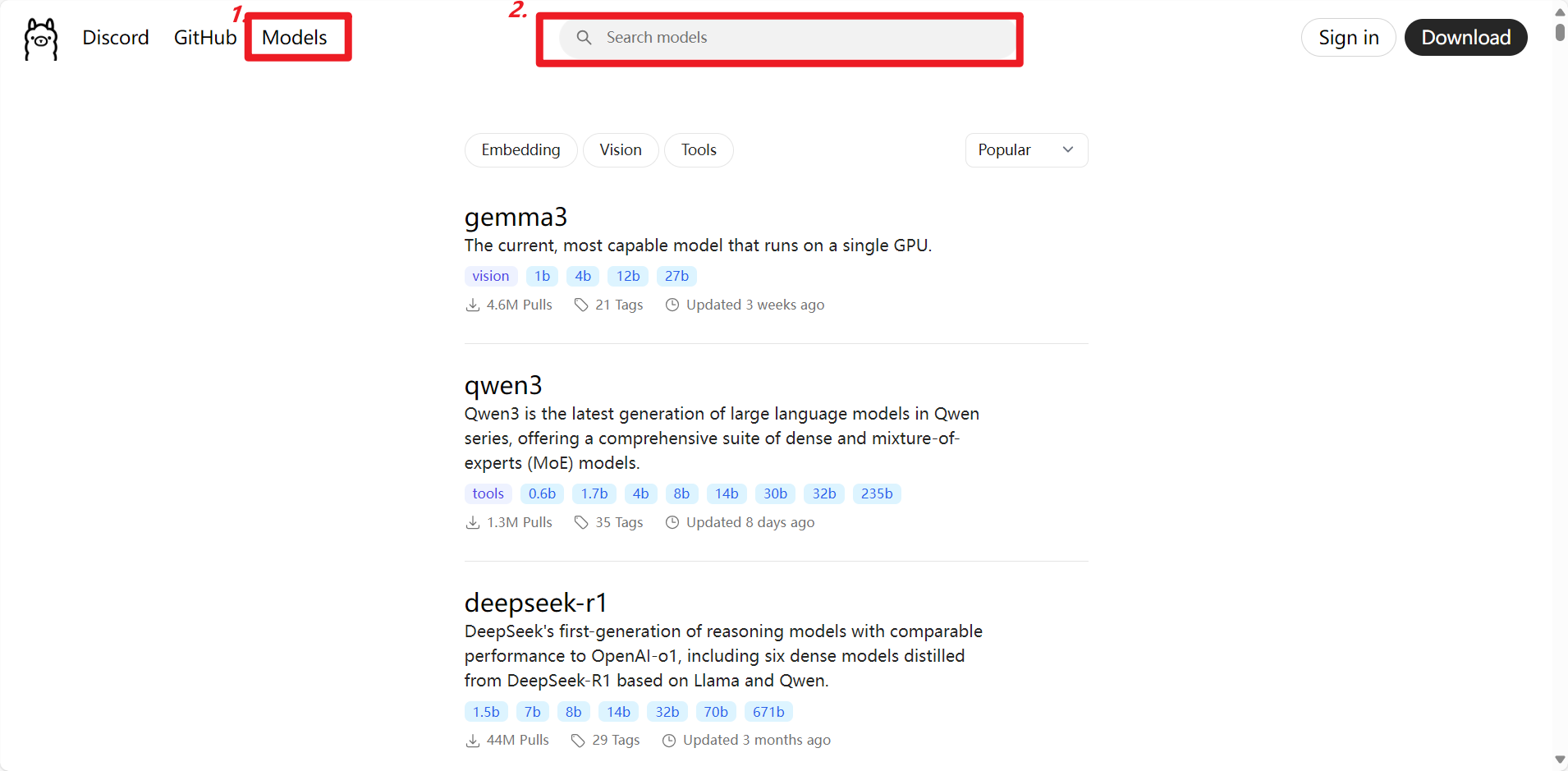

然后点击右上角的模型,因为模型太多所有一般需要我们直接手动搜索。

搜索下面三个模型安装即可,注意这里只是简单使用,而且我们电脑可能也不支持太大的模型,所以我安装的都是比较小的,具体的我也不太懂,你们可以直接看。

在搜索框搜索下列模型:

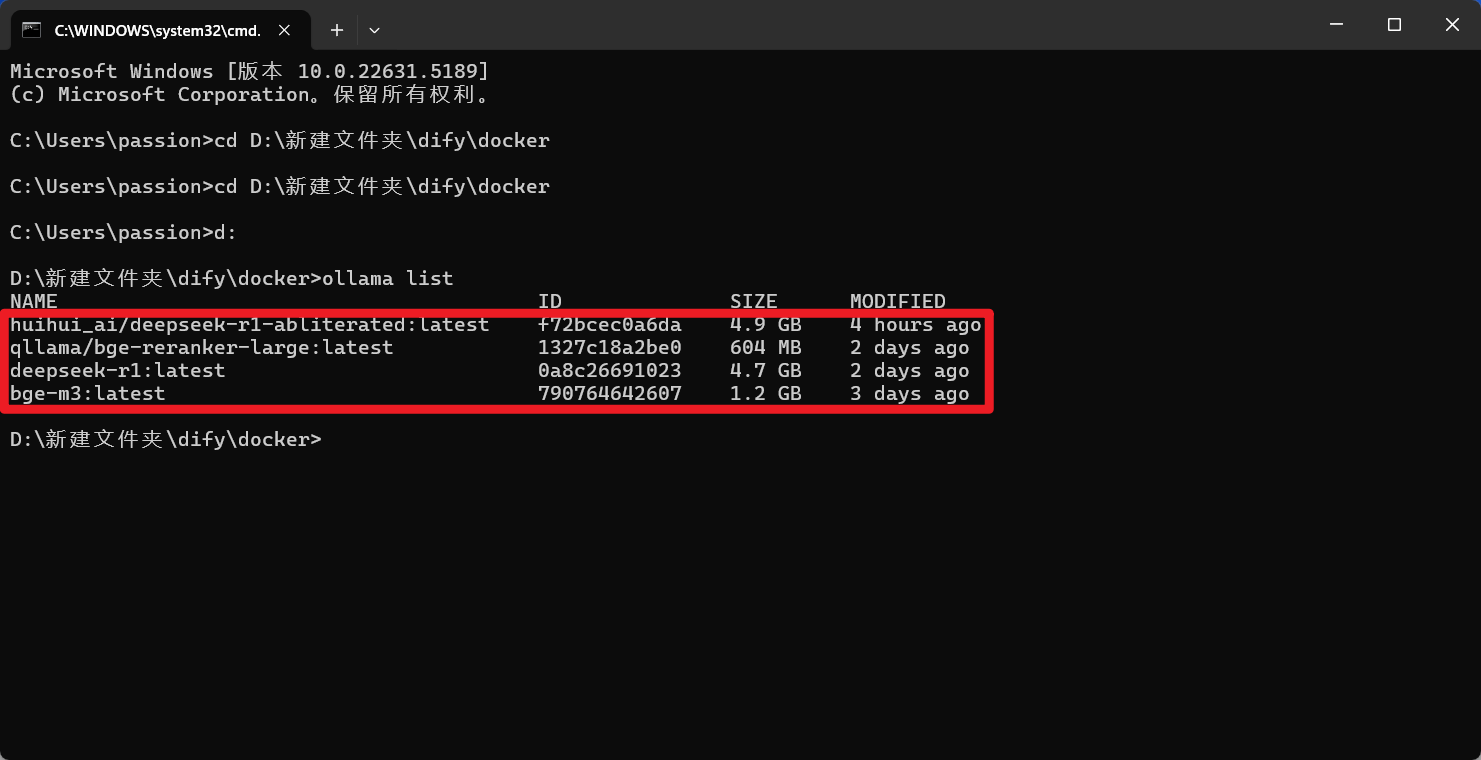

第一个:huihui_ai/deepseek-r1-abliterated:latest

推理模型(越狱版) 可以设置一个情感助手什么的 好像就是相对开放,就是你理解的那个开放,具体我没有测试过。

第二个:qllama/bge-reranker-large:latest (这个我没有主动安装,可以先不管吧)

我记得我没有安装这个,不知道为什么会出现,但他应该是一个向量化模型

第三个:deepseek-r1:latest 非推理模型

第四个:bge-m3:latest 向量化模型

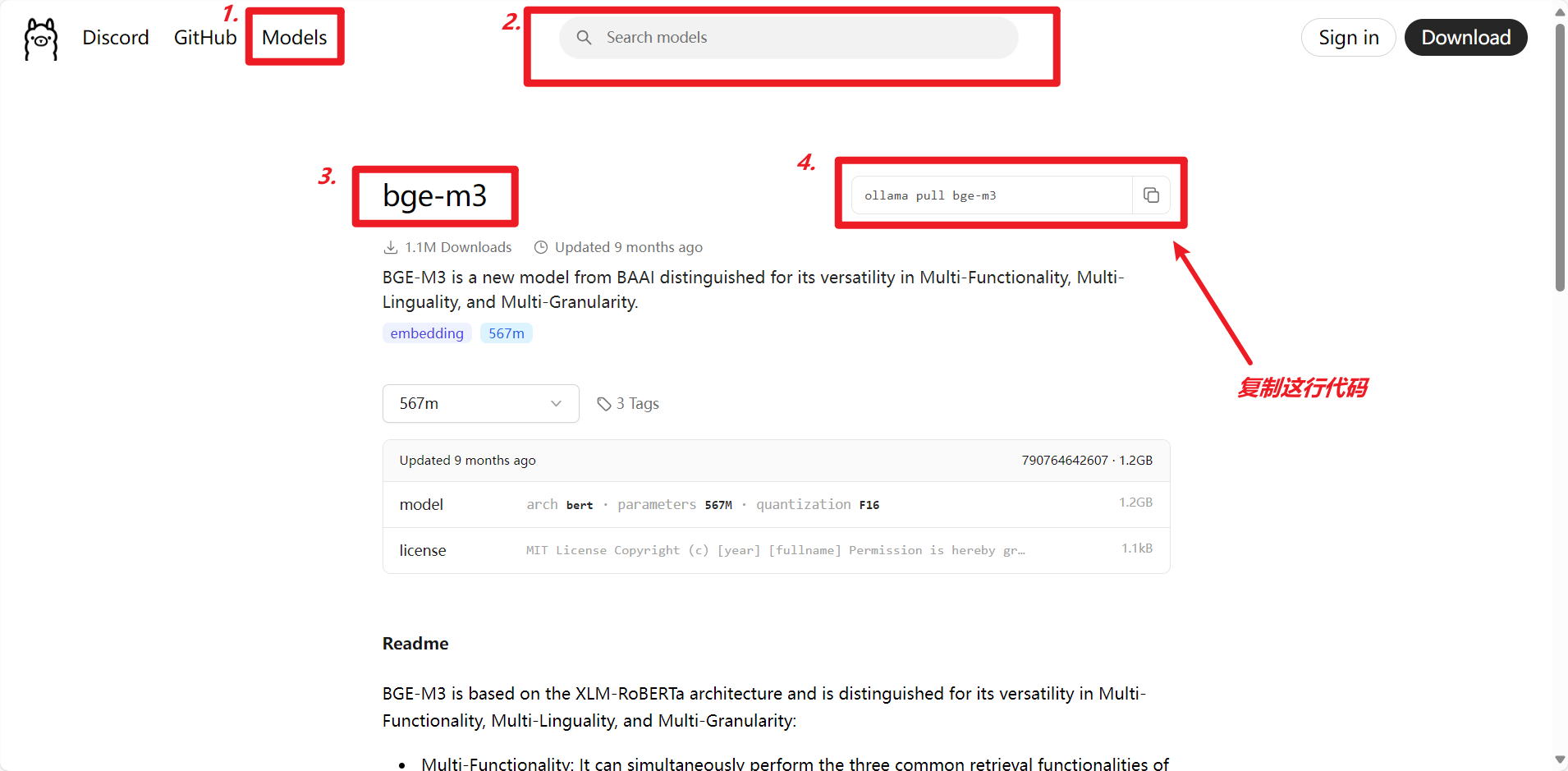

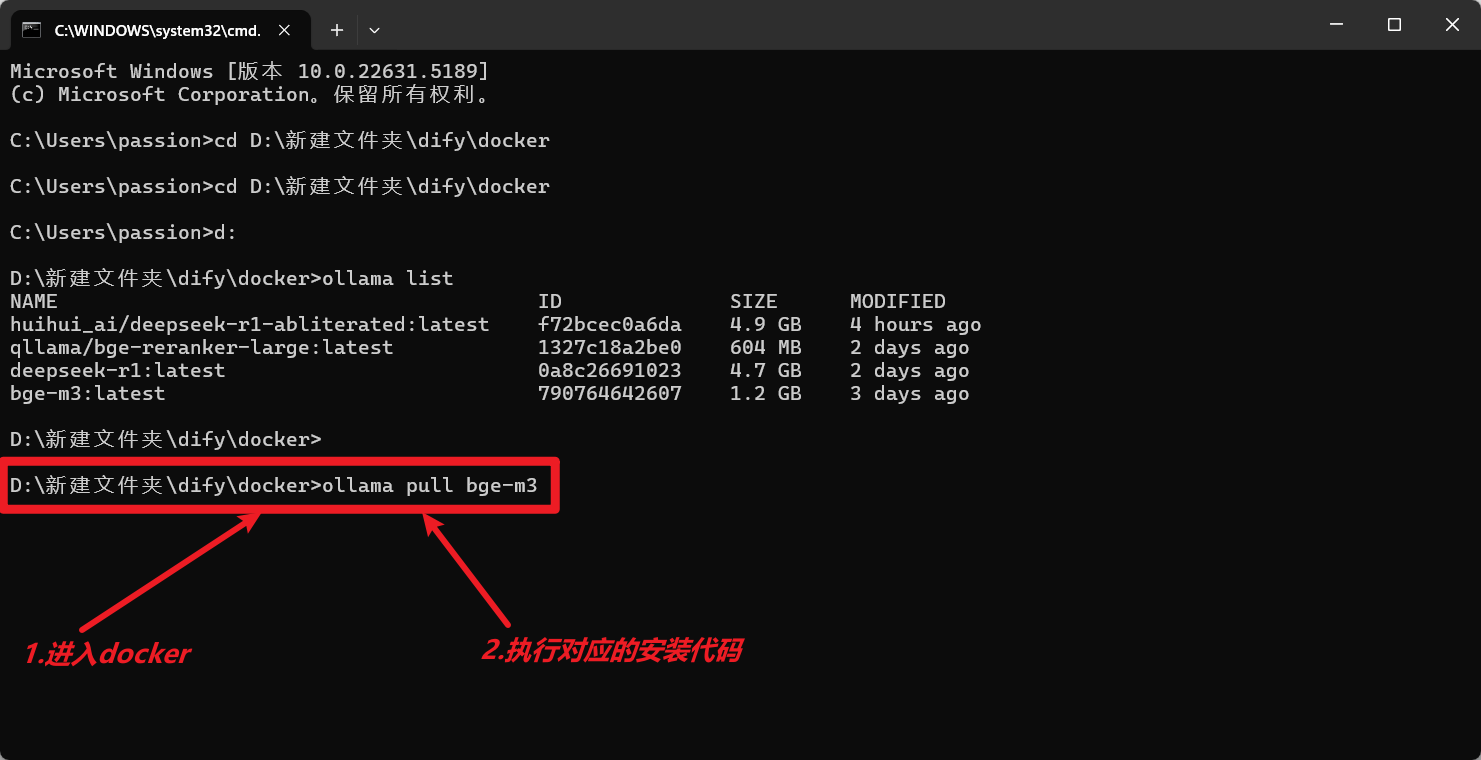

在ollama搜索框搜索上述模型,以bge-m3:latest 为例:

复制上述代码直接在命令行docker里执行上述代码就行。(进入docker在dify的安装里有提到)

重复安装完上述模型即可。

安装完后可以在docker里输入ollama list查看自己已安装的模型有哪些。上图里有示例。

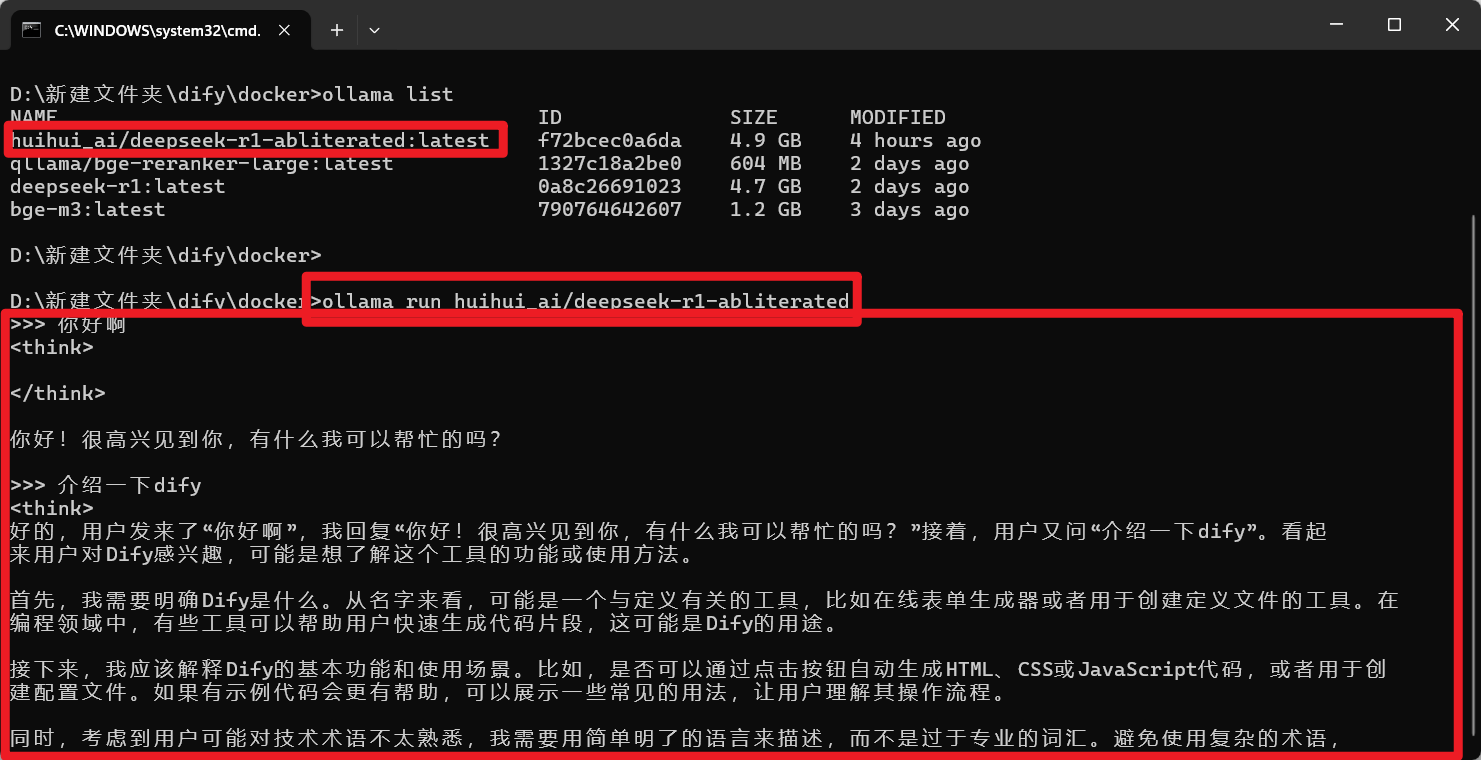

安装好后重复ollama拉取代码也可以直接在端口进行对话:虽然回答好像有点笨。

3.,模型的配置

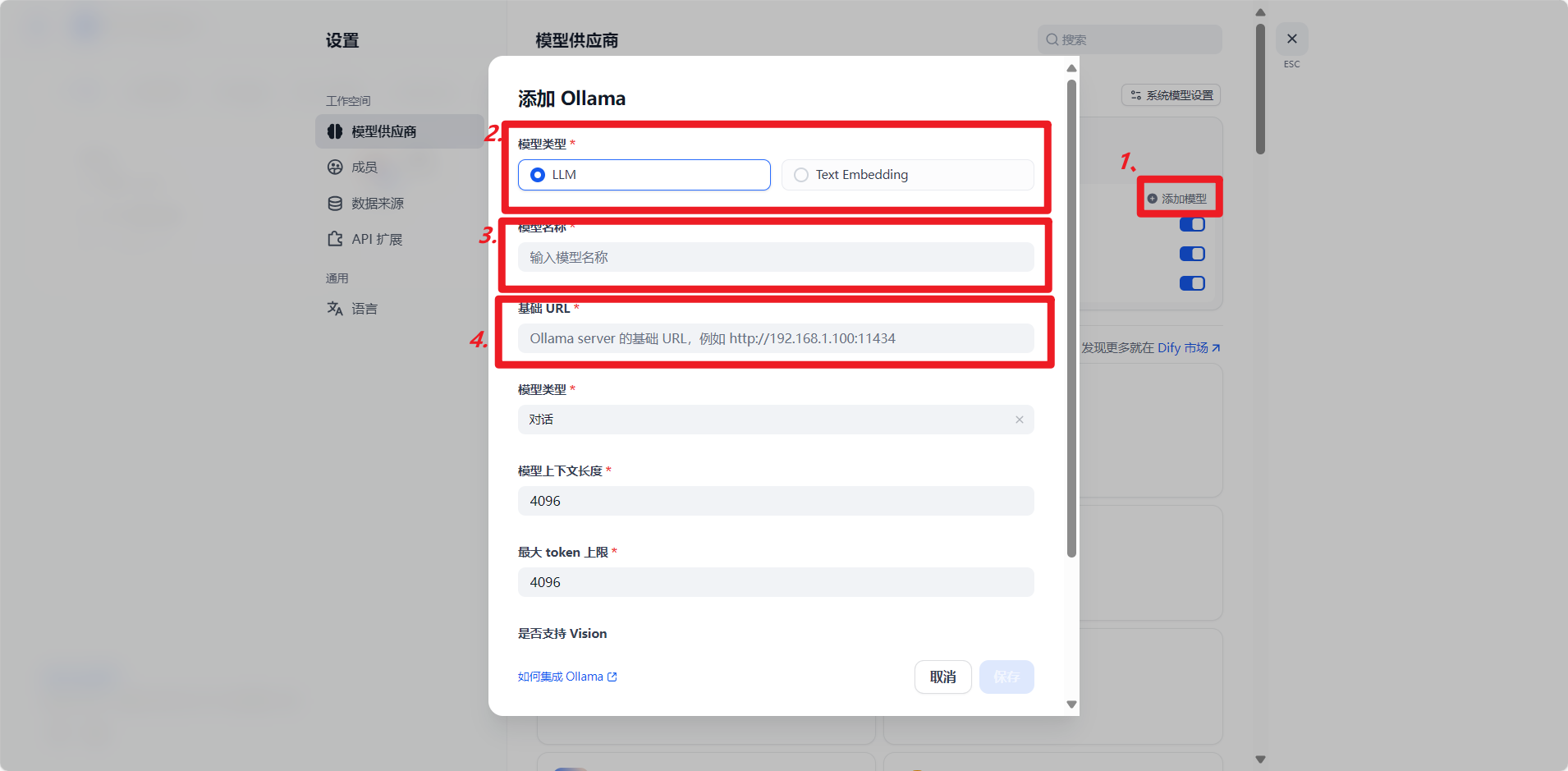

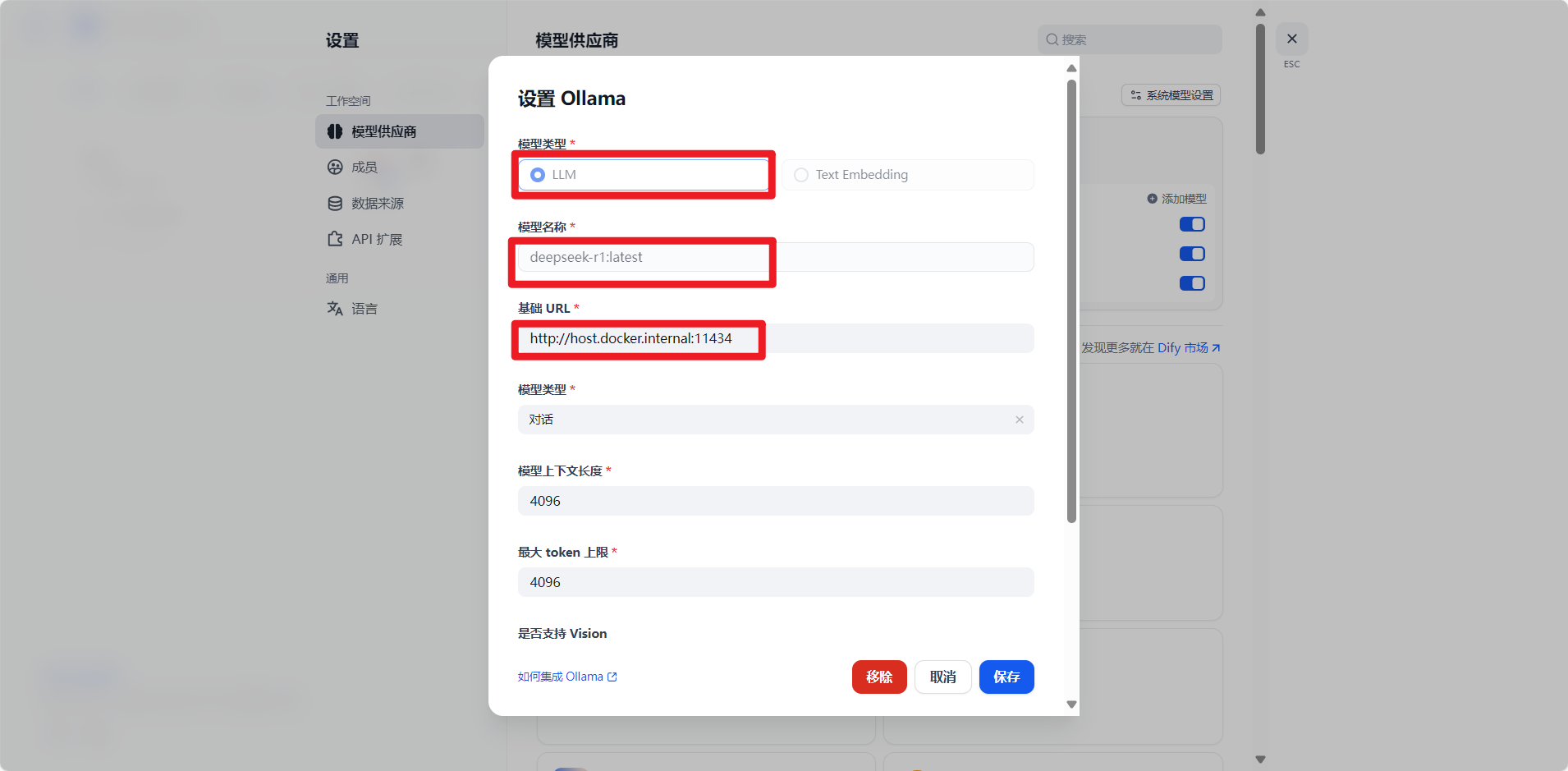

点击ollama右下角的添加模型,然后根据配置信息依次进行配置。

1.模型类型

1.模型类型

除了bge那个向量化模型是Text Embedding,其他两个都是LLM

2.模型名称

自己要配置那个模型就把哪个模型的名字写进去,可以自己ollama list然后从里面复制粘贴进去

3.基础url

照着我的写进去就好,后面11434是ollama的端口号

基础url:

然后后面的暂时不需要修改。点击保存即可,将三个模型都配置好即可。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)