在线智能AI文章伪原创网站源码 - 自媒体和站长的新福利

随着人工智能技术的不断进步,AI在内容创作领域的应用越来越广泛。特别是在伪原创文章生成方面,借助先进的自然语言处理(NLP)技术和机器学习算法,AI能够高效地创造出符合特定语境和风格的原创内容,这对于内容创作者和媒体平台来说,无疑是一种革命性的改变。智能AI伪原创文章生成不是简单的文字替换或重组,而是要深入理解原文的语义,并在此基础上进行内容的重新创作。这不仅要求AI具备对自然语言的精确解析能力,

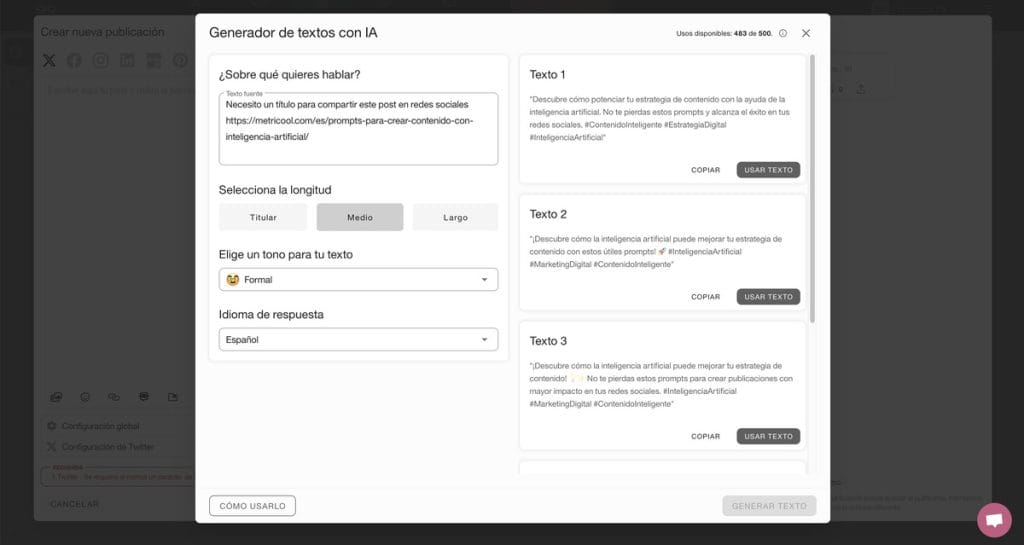

简介:本文介绍了一款基于人工智能的在线文章伪原创工具,主要功能是通过自然语言处理和机器学习算法分析和改写现有文本,以创建出看似原创的内容。该工具适合自媒体和网站站长,用于快速内容生成和搜索引擎优化。源码为PHP编写,无需后台管理界面,简化了部署和使用流程。源码安装和运行灵活,但要注意资源文件路径调整。系统包括AI算法处理、PHP后端逻辑、HTML用户界面、CSS样式定义和JavaScript实现动态交互功能。用户应考虑版权问题和内容质量。

1. 智能AI伪原创文章生成概述

随着人工智能技术的不断进步,AI在内容创作领域的应用越来越广泛。特别是在伪原创文章生成方面,借助先进的自然语言处理(NLP)技术和机器学习算法,AI能够高效地创造出符合特定语境和风格的原创内容,这对于内容创作者和媒体平台来说,无疑是一种革命性的改变。

智能AI伪原创文章生成不是简单的文字替换或重组,而是要深入理解原文的语义,并在此基础上进行内容的重新创作。这不仅要求AI具备对自然语言的精确解析能力,还要求其能生成语义连贯、逻辑清晰的文本。本章将简要介绍智能AI伪原创文章生成的背景、定义以及其在当代IT行业中的重要性。接下来,我们将深入探讨其背后的关键技术——自然语言处理(NLP)和机器学习算法,从而为读者建立起一个全面的理解框架。

2. 自然语言处理技术的深度应用

2.1 自然语言处理基础

2.1.1 语言模型简介

语言模型是自然语言处理(NLP)的基础,它旨在通过统计学方法预测下一个词出现的概率。通过构建这样的模型,计算机能够理解自然语言的结构,从而为后续的分析工作打下基础。

语言模型通常分为基于n-gram的统计语言模型和基于神经网络的深度学习语言模型。统计语言模型依赖大量文本数据来统计词序列的出现频率,例如bigram、trigram模型。神经网络模型则通过多层神经网络来学习语言的深层次特征,如循环神经网络(RNN)、长短时记忆网络(LSTM)和变换器(Transformer)模型等。

构建一个语言模型需要关注其训练集的选择、模型的复杂性以及如何有效处理数据稀疏性问题。随着计算能力的提升和大数据的普及,深度学习语言模型逐渐成为主流,它们能够捕捉更丰富的语言特征,对于长距离依赖问题的处理也更为出色。

2.1.2 词法分析与句法分析

词法分析和句法分析是NLP中的重要环节。词法分析旨在将输入的句子分解为一系列的词或标记(tokens),而句法分析则关注于确定这些标记之间的结构关系,构建出句子的语法树。

在词法分析阶段,主要任务是通过空格、标点等分隔符将句子切分为最小的语义单位,即词汇单元。后续,还会进行词性标注(Part-of-Speech Tagging),为每个单词确定其语法角色,比如名词、动词等。

句法分析则涉及到构建句子的依存结构或短语结构树。依存语法分析关注词与词之间的依存关系,而短语结构语法分析则关注于将句子分解为短语,从而形成一个层次化的结构。通过句法分析,我们可以更准确地理解句子的内在结构,这对于后续的语义理解至关重要。

2.2 自然语言处理技术的实践运用

2.2.1 文本分类与聚类

文本分类和聚类是信息检索、内容推荐系统、垃圾邮件过滤等众多应用的基础。文本分类主要是将文本数据根据其内容分配到预定义的类别中,常见的算法有支持向量机(SVM)、朴素贝叶斯(Naive Bayes)和深度学习中的卷积神经网络(CNN)等。

文本聚类与分类相似,不同的是聚类是在未标记数据上进行的。这意味着在聚类过程中,算法会自动发现文本数据中的内在结构,并根据文本之间的相似度将它们分组。K-means和层次聚类是两种常见的聚类算法。

2.2.2 实体识别与命名实体识别

实体识别(Named Entity Recognition, NER)是将文本中的特定实体,如人名、地名、组织名等识别出来的过程。这项技术广泛应用于信息抽取、知识图谱构建和问答系统等场景。

命名实体识别通常依赖于规则匹配和机器学习方法。传统方法多使用隐马尔可夫模型(HMM)、条件随机场(CRF)等统计方法,而最新的技术则倾向于使用基于深度学习的模型,如双向LSTM与CRF的结合,这些模型在处理复杂的语言结构和长距离依赖问题上表现出色。

2.2.3 情感分析与主题模型

情感分析是判断文本所表达的情绪倾向的过程,通常包括正面、中性和负面三种基本情绪。该技术在社交媒体分析、产品评价分析等领域有着广泛的应用。

主题模型,如隐狄利克雷分布(LDA),是一种统计模型,用于发现文档集中隐藏的“主题”。每个文档可以看作是这些主题的混合,而每个主题又是词的分布。这种模型对于大规模文档集合的结构化非常有效,可以用于内容推荐、文档分类等任务。

通过以上这些技术的实践运用,自然语言处理在许多领域已经取得了实质性的进展,它不仅让机器能够更“智能”地理解人类的语言,也极大地推动了人工智能的发展。下一章,我们将讨论如何将机器学习算法应用于文本分析和改写,以生成内容新颖的伪原创文章。

3. 机器学习算法在文本分析改写中的应用

在本章节中,我们将深入探讨如何使用机器学习算法对文本数据进行分析和改写。这不仅涉及到文本分析的基础理论知识,还包括了具体的实践应用和优化策略。我们首先从机器学习与深度学习的基本概念入手,逐步深入到文本分析改写的核心技术中。

3.1 机器学习与深度学习基础

3.1.1 监督学习与无监督学习

在机器学习中,根据学习任务的性质,我们可以将其分为监督学习(Supervised Learning)和无监督学习(Unsupervised Learning)两大类。监督学习是指学习过程在已知输出标签的数据集上进行,目标是学习从输入到输出的映射关系。例如,分类任务就是监督学习的一种应用,我们需要根据已知的类别标签来训练模型,使其能够对新的实例进行正确的分类。

无监督学习则不依赖于标签数据,其目的是从数据中发现隐藏的结构或模式。聚类(Clustering)是无监督学习中非常常见的任务之一,在文本分析中,无监督学习可以用来对文章进行主题聚类,从而发现文本集合中的潜在主题。

3.1.2 深度学习框架简介

深度学习是机器学习的一个子领域,它使用多层的神经网络来学习数据的复杂模式。深度学习框架提供了一系列的工具和接口,使得研究人员和开发者可以更容易地构建、训练和部署深度学习模型。

一些流行的深度学习框架包括TensorFlow、PyTorch、Keras等。这些框架通常具备以下特点:

- 提供了丰富的API来构建神经网络层、激活函数和损失函数等。

- 优化了反向传播算法和梯度下降算法,提高了训练效率。

- 支持自动微分,降低了手动计算导数的复杂性。

- 具备高度的模块化和可扩展性,方便研究人员进行实验和创新。

深度学习在文本分析改写中的应用主要包括:

- 构建文本表示模型(如Word Embeddings),将文本转换为可进行数学运算的向量形式。

- 利用神经网络自动学习文本中的语义特征,提高分类、聚类任务的准确性。

- 应用序列到序列(Seq2Seq)模型实现文本的翻译和改写。

3.2 文本分析改写的实践

3.2.1 文本表示与特征提取

文本数据是非结构化的,为了用机器学习方法处理文本,我们需要将其转化为机器可以理解的形式。文本表示(Text Representation)是将文本数据转换为数值型特征向量的过程,这是机器学习模型训练前的必要步骤。

文本表示的方法有很多种,其中最常用的是词袋模型(Bag of Words, BoW)和TF-IDF(Term Frequency-Inverse Document Frequency)。这些方法能够有效地将文本转换为特征向量,但它们忽略了单词之间的顺序和上下文信息。

为了更好地捕捉上下文,Word Embeddings被引入到文本分析中。Word Embeddings是一种将单词表示为稠密向量的技术,例如Word2Vec、GloVe等模型能够将语义相似的单词映射到相近的向量空间。通过这种方式,我们能够保留单词间的语义关系。

3.2.2 改写模型的构建与优化

文本改写模型的目的是将一个句子或段落重新表述为语义相同但表述形式不同的文本。构建改写模型通常涉及到以下几个步骤:

- 数据准备:收集大量的文本数据作为训练样本,并进行预处理,包括分词、去除停用词、标准化等。

- 模型选择:根据任务的复杂度和性能需求选择合适的模型。常见的模型有RNN(Recurrent Neural Network)、LSTM(Long Short-Term Memory)、Transformer等。

- 损失函数定义:定义模型训练过程中的损失函数,通常使用交叉熵损失(Cross-Entropy Loss)对输出的预测进行评分。

- 训练与优化:使用梯度下降算法对模型的参数进行迭代优化,直至模型在验证集上的性能不再提升。

- 评估与测试:使用测试集评估模型的泛化能力,并通过人工审核确保改写后的文本质量。

以下是一个使用PyTorch框架构建文本改写模型的简化示例代码:

import torch

import torch.nn as nn

# 定义一个简单的LSTM文本改写模型

class TextRewriter(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim):

super(TextRewriter, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim)

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, text):

embedded = self.embedding(text)

output, (hidden, cell) = self.lstm(embedded)

return self.fc(hidden.squeeze(0))

# 参数初始化

vocab_size = 10000 # 词汇表大小

embedding_dim = 256 # 嵌入向量维度

hidden_dim = 512 # LSTM层隐藏状态维度

output_dim = vocab_size # 输出层维度,通常是词汇表大小

model = TextRewriter(vocab_size, embedding_dim, hidden_dim, output_dim)

# 模型训练代码省略...

# 模型优化与评估代码省略...

在上述代码中,我们定义了一个包含嵌入层(Embedding)、LSTM层和全连接层(Linear)的序列到序列模型。这个模型可以接收文本输入,并输出改写后的文本。

需要注意的是,文本改写是一个非常复杂的问题,可能涉及到文本风格的迁移、复杂结构的重排等。为了构建一个高效的改写模型,我们可能需要结合更多的深度学习技术和策略,例如注意力机制(Attention Mechanism)、深度语义分析和对抗训练(Adversarial Training)等。

通过本章节的介绍,我们了解了机器学习算法在文本分析改写中的应用原理和实践方法。在下一章节中,我们将继续深入探讨如何利用自然语言处理技术进行文本分类、实体识别和情感分析等任务。

4. 智能AI网站的技术实现

4.1 PHP源码结构与功能模块

4.1.1 后台逻辑的代码组织

PHP作为后端语言在智能AI网站中扮演着重要的角色。一个典型的PHP应用通常会包含多个组件,例如路由、控制器、模型、视图等。代码组织结构清晰,不仅可以提高开发效率,而且还能在后期维护和扩展中带来便利。下面,我们将深入探讨如何合理地组织PHP源码结构。

在设计后台逻辑时,代码组织往往遵循MVC(Model-View-Controller)设计模式。MVC将应用分为三个核心组件:

- 模型(Model) : 负责数据的访问、处理和持久化操作。在PHP中,这通常指的是与数据库表相对应的数据模型。

- 视图(View) : 用于展示用户界面。在PHP中,视图往往是由HTML和PHP代码混合构成,负责向用户展示数据。

- 控制器(Controller) : 用于处理用户请求,调用模型获取数据,并将这些数据传递给视图进行展示。

PHP中的MVC框架,如Laravel或Symfony,提供了一套完整的工具来简化代码的组织。这些框架通常具有路由系统来处理HTTP请求,拥有内置的模型和数据库迁移功能,还提供了模板引擎来渲染视图。

示例代码块

// 文件路径:app/Http/Controllers/ArticleController.php

namespace App\Http\Controllers;

use App\Models\Article;

use Illuminate\Http\Request;

class ArticleController extends Controller

{

public function show($id)

{

// 获取文章信息

$article = Article::find($id);

// 检查文章是否存在

if (!$article) {

abort(404); // 如果文章不存在,则返回404错误

}

// 传递文章数据到视图

return view('articles.show', ['article' => $article]);

}

}

在上述代码中, ArticleController 类中的 show 方法负责处理请求,通过模型 Article 获取指定ID的文章数据,并将这些数据传递给 articles.show 视图。

参数说明

namespace:指定控制器所在的命名空间。use:引入相关的类,如Request和Article模型。ArticleController:自定义的控制器类继承自Controller基类。show方法:处理获取文章详情的请求逻辑。

代码逻辑分析

- 当用户访问文章详情页时,Web服务器会触发

ArticleController的show方法。 - 方法内部首先通过

Article模型的find方法获取文章数据。 - 如果文章不存在,则通过

abort函数返回404错误,表示所请求的资源未找到。 - 如果文章存在,则将文章数据作为数组传递给视图文件

articles.show。 - 视图文件会渲染文章内容,将其展示给用户。

通过上述代码组织方式,我们可以清晰地看出控制器如何与模型和视图协作,以实现请求处理和数据展示的功能。这种方式不仅有助于维护和扩展,还可以通过路由分发实现更复杂的业务逻辑。

4.1.2 数据库交互设计

数据库是智能AI网站中的核心部分,它负责存储和管理网站所需的各种数据。在PHP应用中,数据库交互主要通过ORM(Object-Relational Mapping)框架来实现。ORM允许开发者以面向对象的方式操作数据库,从而减少直接编写SQL查询语句的需要,提高开发效率和安全性。

示例代码块

// 文件路径:app/Models/Article.php

namespace App\Models;

use Illuminate\Database\Eloquent\Model;

class Article extends Model

{

protected $fillable = ['title', 'content', 'author_id'];

public function author()

{

return $this->belongsTo('App\Models\User', 'author_id');

}

}

在上述代码中, Article 类继承自Laravel的 Model 类。这是一个基本的文章模型,用于处理与文章相关的数据表。

参数说明

namespace:指定模型所在的命名空间。fillable:定义了哪些属性是可填充的,这是为了防止大规模赋值攻击。belongsTo:定义了文章与作者之间的一对一关系。

代码逻辑分析

Article类代表文章的数据模型,定义了一个文章表与数据库之间的映射关系。fillable属性列出所有可以通过批量赋值操作更新的字段。author方法定义了文章和作者之间的关系。在数据库中,文章数据表可能有一个author_id字段指向用户数据表的主键。

通过这种方式,我们可以利用Laravel提供的ORM功能,更加便捷地对文章数据进行增删改查操作。例如,获取某作者的全部文章可以简单地使用 $user->articles 进行查询。

设计数据库时,应考虑到未来可能的需求变更,合理地进行数据库的规范化设计,以减少数据冗余。同时,利用ORM框架提供的数据库迁移(migration)功能,可以方便地在开发和生产环境中同步数据结构的变更。

接下来,我们将详细探讨前端交互界面设计细节,这部分对于用户最终体验至关重要。

5. 系统部署与版权问题处理

在构建一个智能AI伪原创文章生成系统时,系统部署是实现从开发环境到生产环境的最后一步,而版权问题处理则是确保内容合规和知识产权安全的重要环节。在本章中,我们将探讨系统部署的详细步骤和版权管理的策略,以确保系统的稳定运行和内容的合法使用。

5.1 系统部署和源码安装步骤

5.1.1 环境配置与依赖安装

智能AI伪原创文章生成系统通常依赖于一系列的开发环境和库。以下是部署该系统的基本环境配置和依赖安装步骤:

- 操作系统选择 :选择稳定的Linux发行版,如Ubuntu 18.04或CentOS 7。

- 服务器配置 :确保服务器具备足够的硬件资源,如内存、CPU和存储空间。

- 安装必要的软件包 :

- 使用包管理器安装Python、pip以及相关开发工具。bash sudo apt-get update sudo apt-get install python3 python3-pip - 环境变量设置 :设置必要的环境变量,如

PYTHONPATH,以便系统能正确找到库文件。 - 依赖库安装 :通过requirements.txt文件安装所需的Python依赖库。

bash pip3 install -r requirements.txt - 数据库安装与配置 :安装并配置数据库系统,例如MySQL或PostgreSQL,并创建所需的数据库和用户。

sql CREATE DATABASE ai_writing; CREATE USER 'ai_user'@'localhost' IDENTIFIED BY 'password'; GRANT ALL PRIVILEGES ON ai_writing.* TO 'ai_user'@'localhost'; FLUSH PRIVILEGES; - 前端资源准备 :编译前端资源,如JavaScript和CSS,确保它们在服务器上可用。

5.1.2 源码安装与测试

在完成环境配置和依赖安装后,接下来进行源码安装和测试:

- 源码下载 :从版本控制系统(如Git)克隆或下载项目的源码。

- 数据库迁移 :运行数据库迁移脚本,创建必要的表和索引。

bash python3 manage.py migrate - 静态文件收集 :收集前端静态文件到指定目录。

bash python3 manage.py collectstatic - 服务启动 :启动后端服务,进行配置检查和功能性测试。

bash gunicorn -w 4 -b 127.0.0.1:8000 myproject.wsgi:application - 前端访问测试 :通过浏览器访问前端界面,检查是否能够正常加载并响应。

- 压力测试 :利用工具如JMeter进行压力测试,确保系统性能符合预期。

- 日志监控 :设置日志监控系统,以监控实时运行状态和发现潜在问题。

5.2 版权与内容质量的管理

5.2.1 版权法规与合规性检查

在处理版权问题时,需要遵循相关的法律法规和最佳实践:

- 版权法规了解 :熟悉国内外关于版权的法规,包括作者权、著作邻接权、公共领域等。

- 内容合规性检查 :确保所有生成的内容不侵犯第三方版权,特别是文本和图片资源。

- 版权声明 :在系统生成的文章中添加版权声明,明确标明内容来源和所有权。

- 授权协议 :在用户协议中明确内容的使用权限和限制。

- 版权培训 :对内容创作和审核团队进行版权法规培训,提高版权意识。

5.2.2 内容质量提升与监控机制

为了提升内容质量,需要建立一套监控和反馈机制:

- 质量评估标准 :制定一套评估内容质量的标准,包括准确性、原创性、可读性等。

- 内容审核流程 :设置内容审核流程,确保通过系统生成的内容符合标准。

- 用户反馈收集 :通过用户反馈系统收集内容质量的反馈,不断优化系统。

- 持续改进 :定期分析使用数据,根据分析结果调整模型和算法,提高生成内容的质量。

- 内容监控系统 :建立内容监控系统,实时跟踪内容状态,及时发现并处理版权和质量问题。

通过上述章节内容的细致探讨,我们已经了解到智能AI伪原创文章生成系统部署的详细步骤以及版权和内容质量管理的重要性和实现方法。系统部署和版权管理是确保智能AI系统顺利运行的关键部分,而通过严格的监控和管理,我们能够确保输出的内容既合规又有高质量。

简介:本文介绍了一款基于人工智能的在线文章伪原创工具,主要功能是通过自然语言处理和机器学习算法分析和改写现有文本,以创建出看似原创的内容。该工具适合自媒体和网站站长,用于快速内容生成和搜索引擎优化。源码为PHP编写,无需后台管理界面,简化了部署和使用流程。源码安装和运行灵活,但要注意资源文件路径调整。系统包括AI算法处理、PHP后端逻辑、HTML用户界面、CSS样式定义和JavaScript实现动态交互功能。用户应考虑版权问题和内容质量。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)