动手学深度学习 - 机器视觉 - 14.9 语义分割与数据集(VOC2012)

..语义分割关注像素级别的图像内容解析;VOC2012 是经典入门数据集;标签使用颜色编码,训练前需转换为索引;图像与标签裁剪应同步处理;可通过 Dataset 封装 + DataLoader 组织训练流程。语义分割是众多应用(自动驾驶、医学、视觉智能剪辑)的核心技术;数据组织、增强、标签映射规范化,是大厂模型可复用的关键;主流工业系统都采用标准数据结构(如 VOC、COCO 格式)作为底层训练格

深度学习视觉项目:语义分割与数据集(VOC2012)

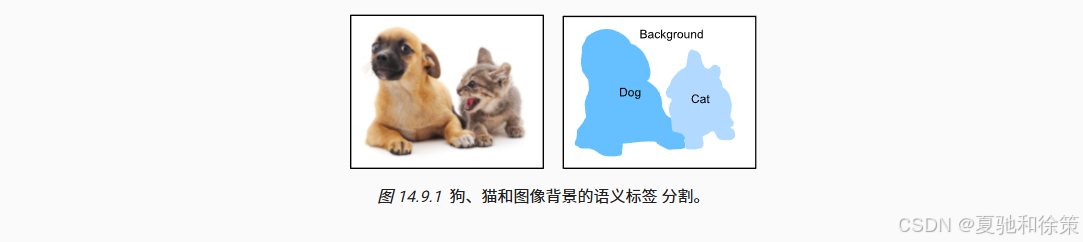

在目标检测任务中,我们以矩形框为单位预测物体的位置与类别。而语义分割则更进一步,它关注图像中每一个像素所属于的语义类别。每一张图像被划分成多个区域,每个区域对应一个语义标签。下图展示了对狗、猫与背景的像素级语义分割结果:

📌 14.9.1 图像分割、语义分割与实例分割的关系

-

图像分割:不带语义标签,仅按颜色/纹理等划分区域。

-

语义分割:对图像中所有像素进行分类,预测其语义类别。

-

实例分割:不仅要分辨语义,还要区分每个独立的对象实例。

📘 理论理解:

-

图像分割:不依赖标签,仅按纹理/颜色划分区域,常用于聚类、图像增强前处理;

-

语义分割:关注“类别级”分割,每类区域只标记一次,不关心有多少实例;

-

实例分割:既要知道每个像素的类别,又要知道它属于哪个“对象实例”。

🏢 企业实战理解:

-

百度 Apollo 自动驾驶系统:使用语义分割识别道路结构(车道线、马路边界),使用实例分割识别动态物体(如每一辆车)。

-

字节跳动视频人像分割系统:短视频背景抠图使用语义分割,结合人脸/人体关键点定位。

-

NVIDIA Clara 平台:医学影像分割中,肿瘤检测采用语义分割,肿瘤复发追踪采用实例分割(同一类别的不同病灶)。

-

Google Pixel:相册中的人像美颜、人景分离、抠图动画都需要精细分割。

📦 14.9.2 Pascal VOC2012 数据集使用流程

🧾 数据下载与解压

voc_dir = d2l.download_extract('voc2012', 'VOCdevkit/VOC2012')

📂 读取图像与标签

train_features, train_labels = read_voc_images(voc_dir, True)

每张标签图像使用独特颜色编码表示不同语义类别,与输入图像大小一致。

🎨 标签可视化

n = 5

imgs = train_features[:n] + train_labels[:n]

imgs = [img.permute(1,2,0) for img in imgs]

d2l.show_images(imgs, 2, n)

📘 理论理解:

-

数据集包含 21 类(20 前景 + 背景),图像与标签一一对应;

-

标签为

.png格式,像素颜色代表语义类别; -

每个类别在 RGB 空间中用唯一颜色编码,需通过颜色 → 类别索引映射表处理。

🏢 企业实战理解:

-

阿里巴巴视觉平台:在训练多类商品图像识别时,参考 VOC 结构设计统一标签体系,便于模型迁移;

-

DeepSeek 医学图像实验室:仿照 VOC 构建病灶分割集,用色彩图提高医生阅读友好性,同时训练神经网络;

-

OpenAI DALL·E 模块:图像生成后对生成图做语义分割验证,确保输出图像符合提示词的结构布局。

🧭 标签颜色映射处理

定义颜色映射表和对应类别:

VOC_CLASSES = ['background', 'aeroplane', ..., 'tv/monitor']

VOC_COLORMAP = [[0, 0, 0], [128, 0, 0], ..., [0, 64, 128]]

构建 RGB → 类别索引映射:

colormap2label = voc_colormap2label()

label_indices = voc_label_indices(label_img, colormap2label)

📘 理论理解:

由于神经网络训练只能处理整型类别索引,需将 VOC 标签图中 RGB 值映射为索引值矩阵([H, W])。

colormap2label[r * 256^2 + g * 256 + b] = class_index

🏢 企业实战理解:

-

腾讯优图数据平台:统一采用“颜色转标签索引”机制,便于团队共享数据集与标签;

-

NVIDIA AI City Challenge:训练城市级交通模型时采用类似机制,将 COCO、Cityscapes 等不同格式统一映射。

✂️ 随机裁剪(数据增强)

为避免缩放导致标签偏移,采用随机裁剪:

feature_crop, label_crop = voc_rand_crop(feature, label, 200, 300)

📘 理论理解:

不能像图像分类那样随意缩放,因为语义分割需要像素级对齐,常用随机裁剪(同时裁剪图像与标签)。

🏢 企业实战理解:

-

快手视频 AI 团队:抠图模型训练时使用 crop + color jitter + horizontal flip 提高模型鲁棒性;

-

百度 AI Studio:在 PaddleSeg 中集成多种像素级 data augmentation,如 RandomCrop、CutMix 等;

-

Google TensorFlow Datasets:针对 segmentation 任务使用 identical crop pipeline 保证标签同步处理。

🧱 自定义数据集类 VOCSegDataset

封装 VOC 数据集的读取、裁剪、颜色索引转换流程:

class VOCSegDataset(torch.utils.data.Dataset):

...

def __getitem__(self, idx):

feature, label = voc_rand_crop(...)

return (feature, voc_label_indices(label, self.colormap2label))

📘 理论理解:

通过继承 PyTorch Dataset,将图像加载、标签映射、随机裁剪等封装进 __getitem__ 方法,便于配合 DataLoader 使用。

🏢 企业实战理解:

-

字节跳动机器视觉平台:所有分割任务使用统一 Dataset 接口适配 VOC、COCO、Cityscapes 等不同格式;

-

DeepSeek 城市感知系统:Dataset 支持多路径加载(多镜头图像、多源标签),并在

__getitem__中使用动态策略增强罕见类。

🧮 数据加载器构建

指定裁剪尺寸和 batch size:

crop_size = (320, 480)

batch_size = 64

train_iter, test_iter = load_data_voc(batch_size, crop_size)

检查 batch 维度:

for X, Y in train_iter:

print(X.shape) # [64, 3, 320, 480]

print(Y.shape) # [64, 320, 480]

break

📘 理论理解:

设置合理 batch_size 和 drop_last,加载 [batch, 3, H, W] 的图像张量与 [batch, H, W] 的标签张量。

🏢 企业实战理解:

-

NVIDIA:在 TensorRT 加速推理中,分割标签作为二值掩码直接参与计算,减少后处理;

-

OpenAI:将图像、标签加载模块高度并行化,结合 dataloader_prefetcher 提升训练速度。

📌 14.9.3 小结

-

语义分割是像素级图像理解的重要任务。

-

Pascal VOC2012 是经典的多类分割数据集。

-

标签由颜色编码表示,需转换为类别索引。

-

输入图像和标签应同步裁剪,避免失配。

-

可通过自定义数据集类和加载器模块化流程。

📘 理论总结:

-

语义分割关注像素级别的图像内容解析;

-

VOC2012 是经典入门数据集;

-

标签使用颜色编码,训练前需转换为索引;

-

图像与标签裁剪应同步处理;

-

可通过 Dataset 封装 + DataLoader 组织训练流程。

🏢 企业总结:

-

语义分割是众多应用(自动驾驶、医学、视觉智能剪辑)的核心技术;

-

数据组织、增强、标签映射规范化,是大厂模型可复用的关键;

-

主流工业系统都采用标准数据结构(如 VOC、COCO 格式)作为底层训练格式;

-

分割任务的训练、部署、推理、后处理均有专用优化策略。

🧠 14.9.4 练习建议

-

探索语义分割在自动驾驶与医学图像中的应用场景。

-

思考图像增强中哪些方法不适合语义分割任务。

-

尝试将 VOC2012 替换为 Cityscapes 或 ADE20K,训练更复杂模型(如 FCN、DeepLabV3)。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)