华为云Flexus+DeepSeek征文 | 基于Dify构建具备联网搜索能力的知识库问答助手

知识库问答助手是基于人工智能技术(如自然语言处理、大语言模型和知识图谱)构建的智能系统,能够快速理解用户问题,并从结构化或非结构化知识库中检索精准答案。

华为云Flexus+DeepSeek征文 | 基于Dify构建具备联网搜索能力的知识库问答助手

一、构建知识库问答助手引言

知识库问答助手是融合人工智能技术与结构化知识管理的智能系统,通过自然语言处理(NLP)和检索增强生成(RAG)技术,实现高效精准的问答服务。它能解析用户自然语言提问,从企业文档、产品手册等知识源中快速定位信息,并结合大模型生成简明易懂的答案。

DeepSeek-R1作为一款性能卓越的开源大语言模型,在数学推理(MATH 500第一)和代码生成(LiveCodeBench第一)等场景表现突出,特别适合处理复杂的多轮对话场景。而Dify作为同样开源的生成式AI应用开发平台,提供了可视化编排界面和丰富的功能模块,使开发者无需编写复杂代码即可快速构建AI应用。

DeepSeek-R1与Dify的结合为企业提供了零代码开发、高性能推理、知识增强和显著成本优势的自由编排知识库问答助手工作流方案:通过Dify可视化界面3分钟即可搭建应用,DeepSeek-R1在多步骤逻辑问题处理上比传统方案快5-10倍,结合RAG技术可关联企业私有文档提升回答准确性,同时华为云FlexusX + 华为云ModelArts Studio 为项目的稳定高效的运行提供可靠的基础,还让用户更省钱!

二、构建知识库问答助手环境

2.1 基于FlexusX实例的Dify平台

华为云FlexusX实例提供高性价比的云服务器,按需选择资源规格、支持自动扩展,减少资源闲置,优化成本投入,并且首创大模型QoS保障,智能全域调度,算力分配长稳态运行,一直加速一直快,用于搭建Dify-LLM应用开发平台。

Dify是一个能力丰富的开源AI应用开发平台,为大型语言模型(LLM)应用的开发而设计。它巧妙地结合了后端即服务(Backend as Service)和LLMOps的理念,提供了一套易用的界面和API,加速了开发者构建可扩展的生成式AI应用的过程。

参考:华为云Flexus+DeepSeek征文 | 基于FlexusX单机一键部署社区版Dify-LLM应用开发平台教程

2.2 基于MaaS的模型API商用服务

MaaS预置服务的商用服务为企业用户提供高性能、高可用的推理API服务,支持按Token用量计费的模式。该服务适用于需要商用级稳定性、更高调用频次和专业支持的场景。

参考:华为云Flexus+DeepSeek征文 | 基于ModelArts Studio开通和使用DeepSeek-V3/R1商用服务教程

三、构建知识库问答助手实战

3.1 配置Dify环境

输入管理员的邮箱和密码,登录基于FlexusX部署好的Dify网站

将MaaS平台的模型服务接入Dify,这里我们选择的是DeepSeek R1商用服务,需要记住调用说明中的接口信息和 API Key 管理中API Key,若没有可以重新创建即可

配置Dify模型供应商:设置 - 模型供应商 - 找到OpenAI-API-compatible供应商并单击添加模型,在添加 OpenAI-API-compatible对话框,配置相关参数,然后单击保存

| 参数 | 说明 |

|---|---|

| 模型类型 | 选择LLM。 |

| 模型名称 | 填入模型名称。 |

| API Key | 填入创建的API Key。 |

| API Endpoint URL | 填入获取的MaaS服务的基础API地址,需要去掉地址尾部的“/chat/completions”后填入 |

3.2 创建知识库问答助手

参考:https://bbs.huaweicloud.com/blogs/446508

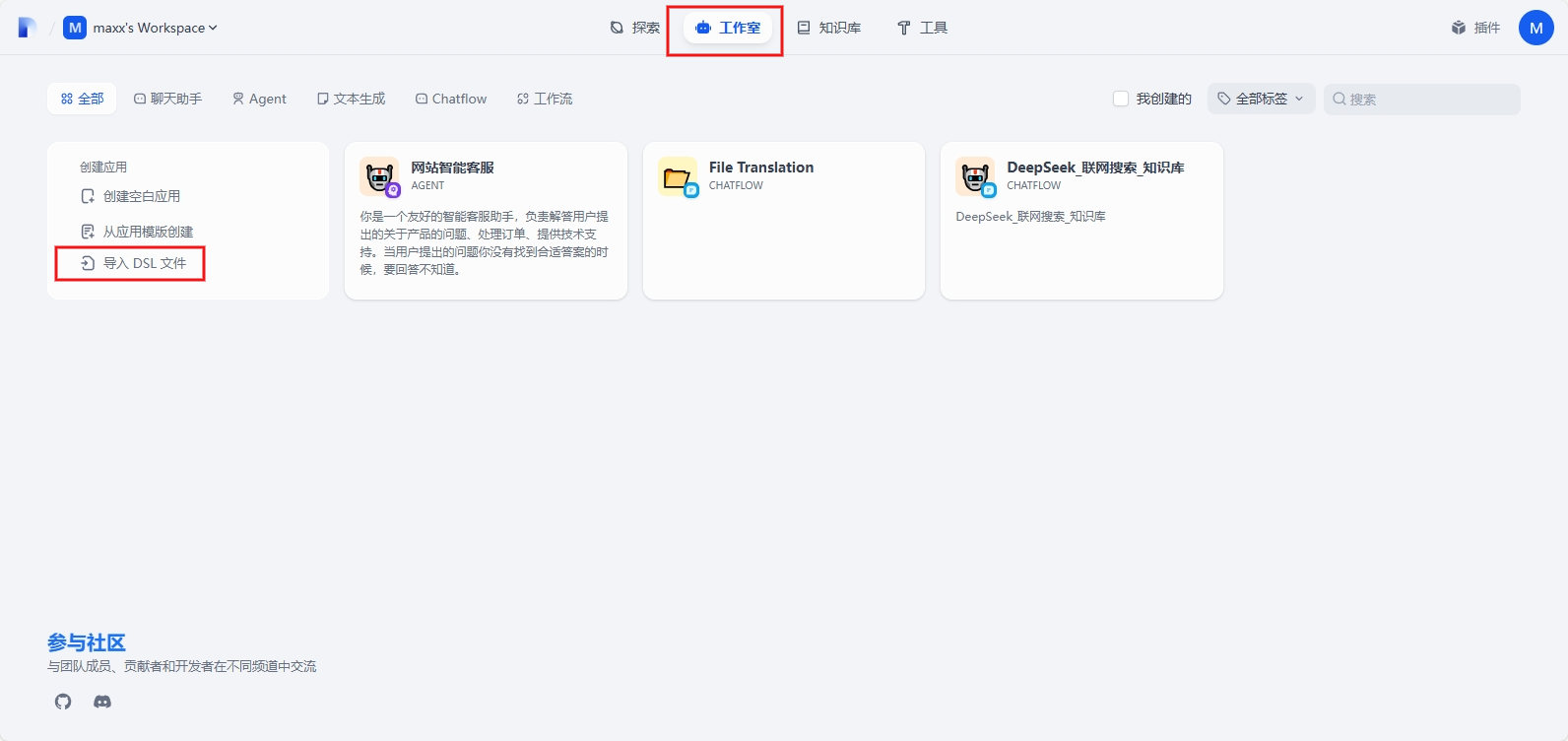

登录基于FlexusX部署好的Dify网站,在工作室页面,选择导入DSL文件

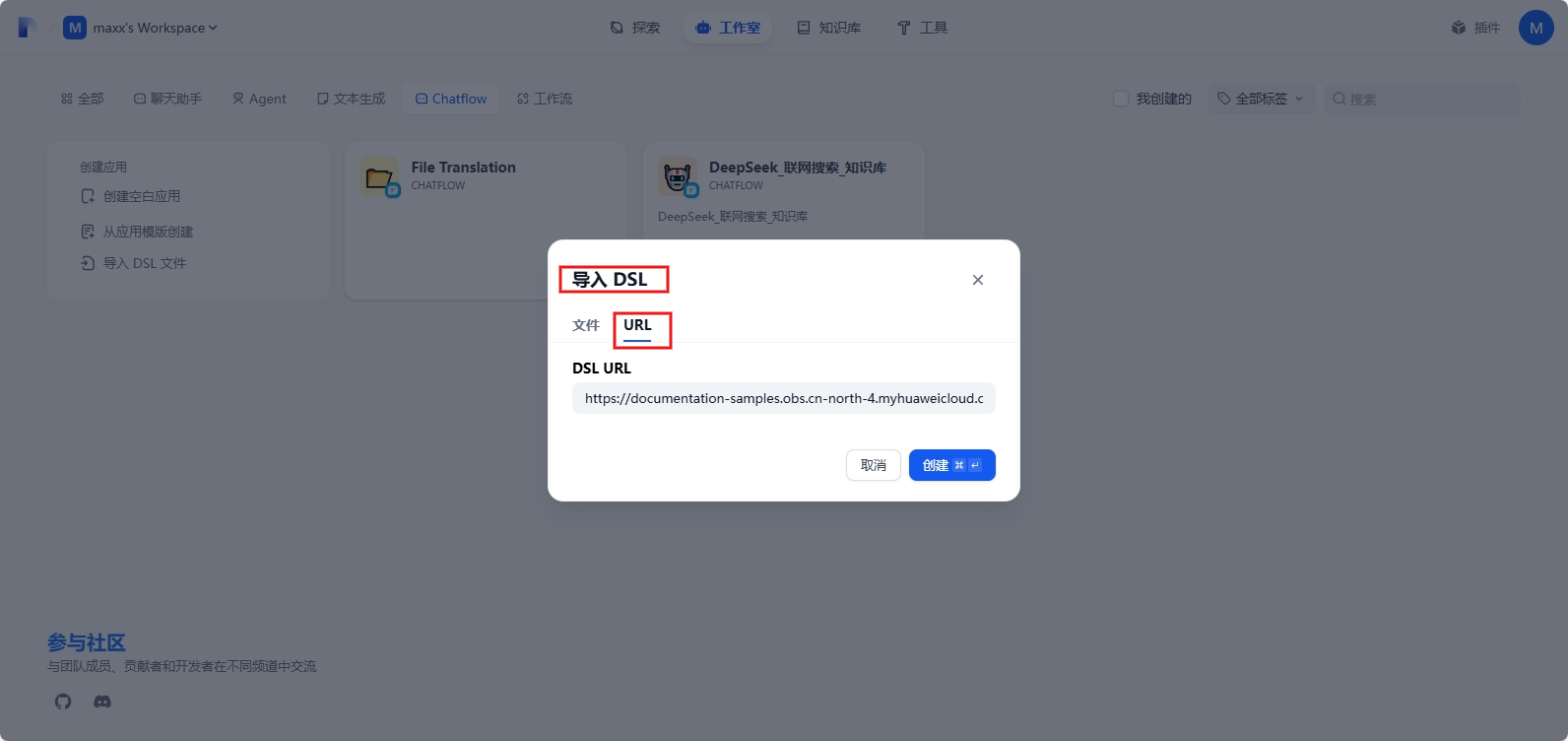

选择URL方式创建,DSL URL路径如下:

https://documentation-samples.obs.cn-north-4.myhuaweicloud.com/solution-as-code-publicbucket/solution-as-code-moudle/building-a-dify-llm-application-development-platform/workflow/DeepSeek_%E8%81%94%E7%BD%91%E6%90%9C%E7%B4%A2_%E7%9F%A5%E8%AF%86%E5%BA%93.yml

提示安装插件,勾选 OpenAI-API-compatible 和 OpenAI-API-compatible 安装完成后关闭窗口

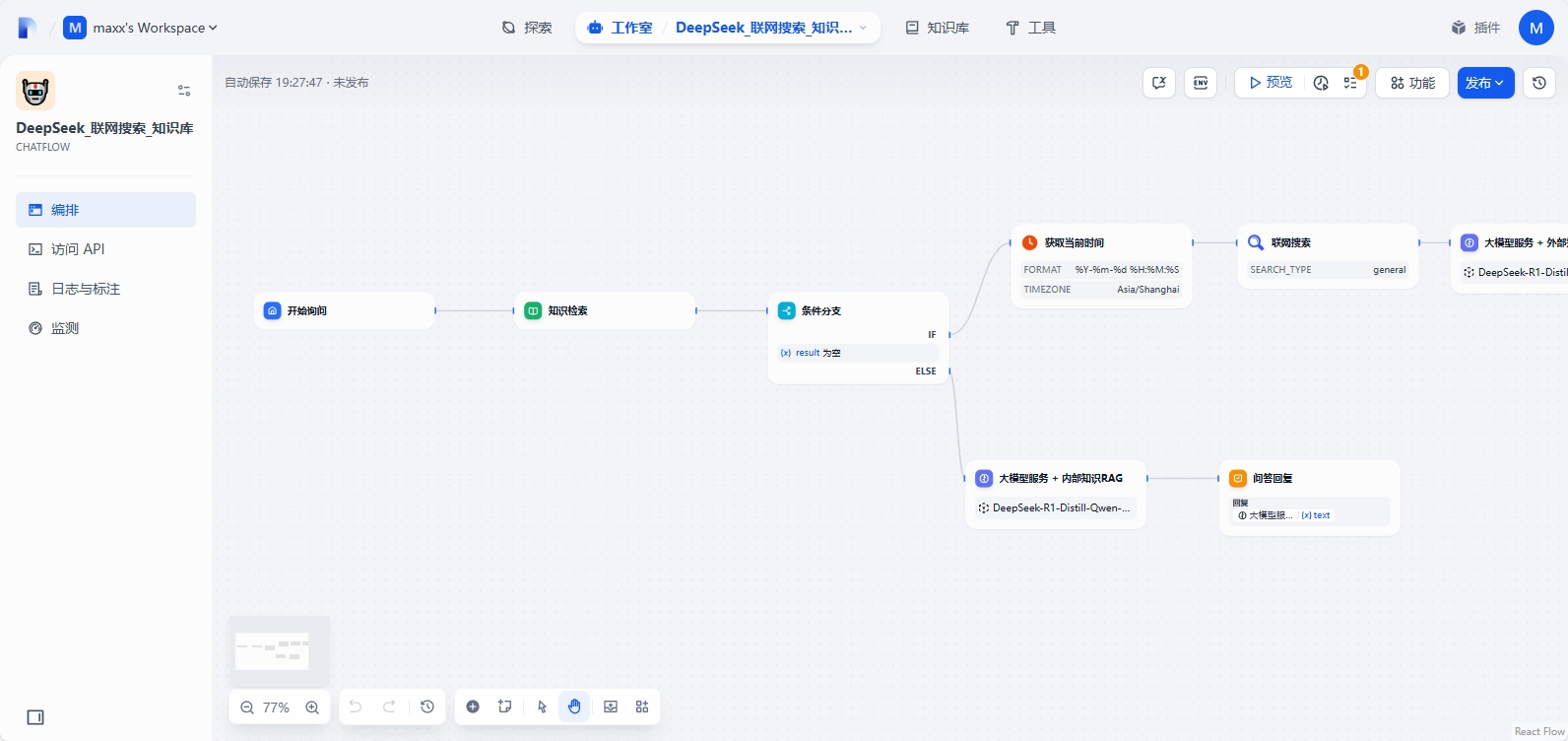

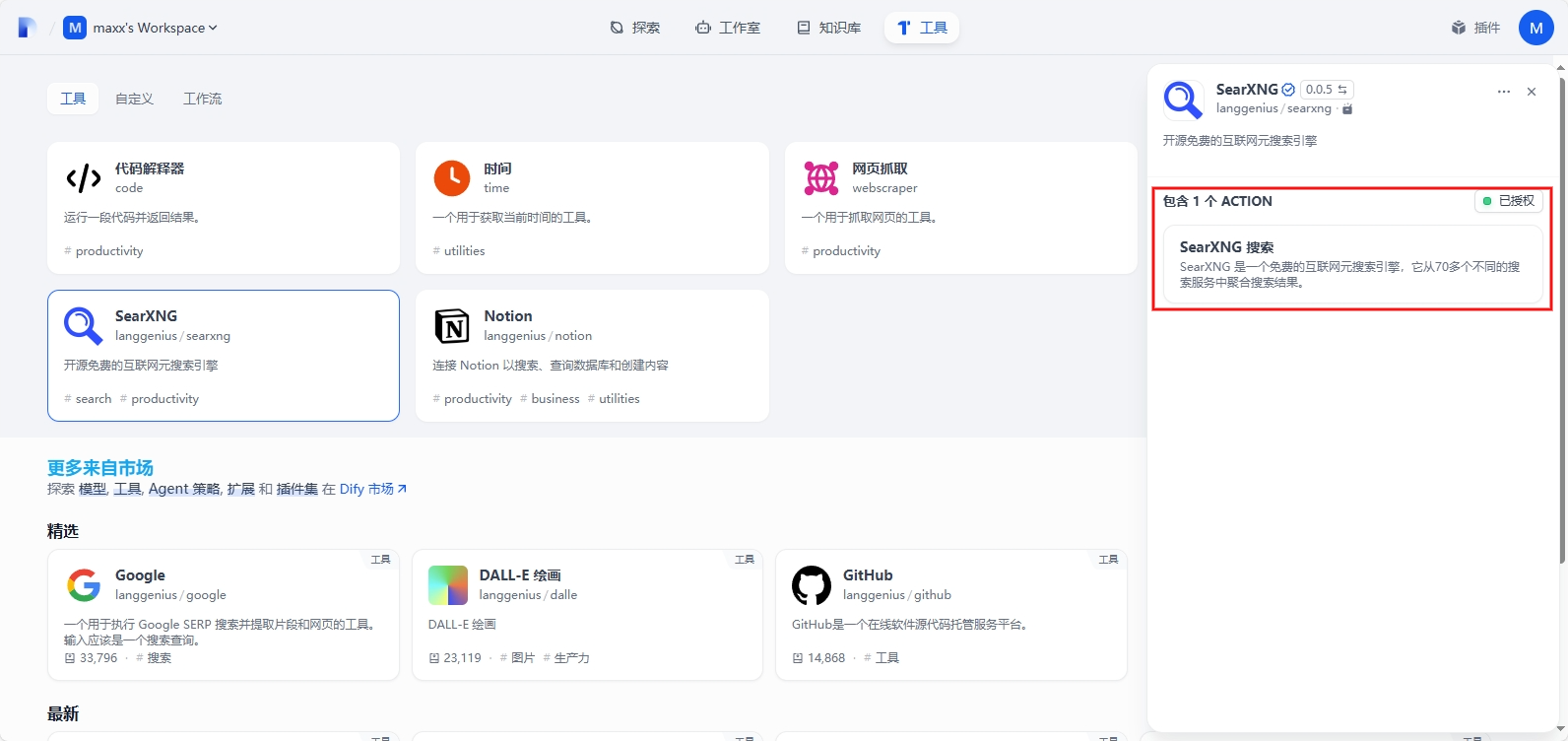

这样就进入了编排界面,这里我们需要配置联网搜索SearXNG和替换大模型服务

首先我们需要在FlexusX云服务器上部署 searxng 服务,这里我们使用Docker部署更方便

本地部署searxng:https://docs.dify.ai/zh-hans/guides/tools/tool-configuration/searxng

# Create and navigate to instance directory

mkdir my-searxng-instance && cd my-searxng-instance

# Set environment variables

export PORT=8081 # Using 8081 to avoid conflicts with other services

export INSTANCE_NAME="dify-searxng"

# Pull and run SearXNG container

docker pull searxng/searxng:latest

docker run --rm \

-d \

-p ${PORT}:8080 \

-v "${PWD}/searxng:/etc/searxng" \

-e "BASE_URL=http://localhost:${PORT}/" \

-e "INSTANCE_NAME=${INSTANCE_NAME}" \

--name searxng-dify \

searxng/searxng:latest

需要自行部署SearXNG服务,若出现

403 Forbidden报错,则在/etc/searxng/settings.yml的search.formats,添加json

formats:

- html

- json

选择联网搜索插件,点击授权按钮,并添加SearXNG base URL:http://{内网ip}:8081,保存授权即可

创建知识库:导入已有文本

18种食用油的常识及其功效.docx 文件地址 :https://bbs.huaweicloud.com/blogs/attachment?id=a42ac97c5ffa440cbe7a6183d7f50be7

文本分段与清洗本示例保持默认配置不变,分段设置:通用,索引方式:经济,检索设置:Top 3

等待文件索引完成,知识库已创建

导入的知识库文档为可用状态

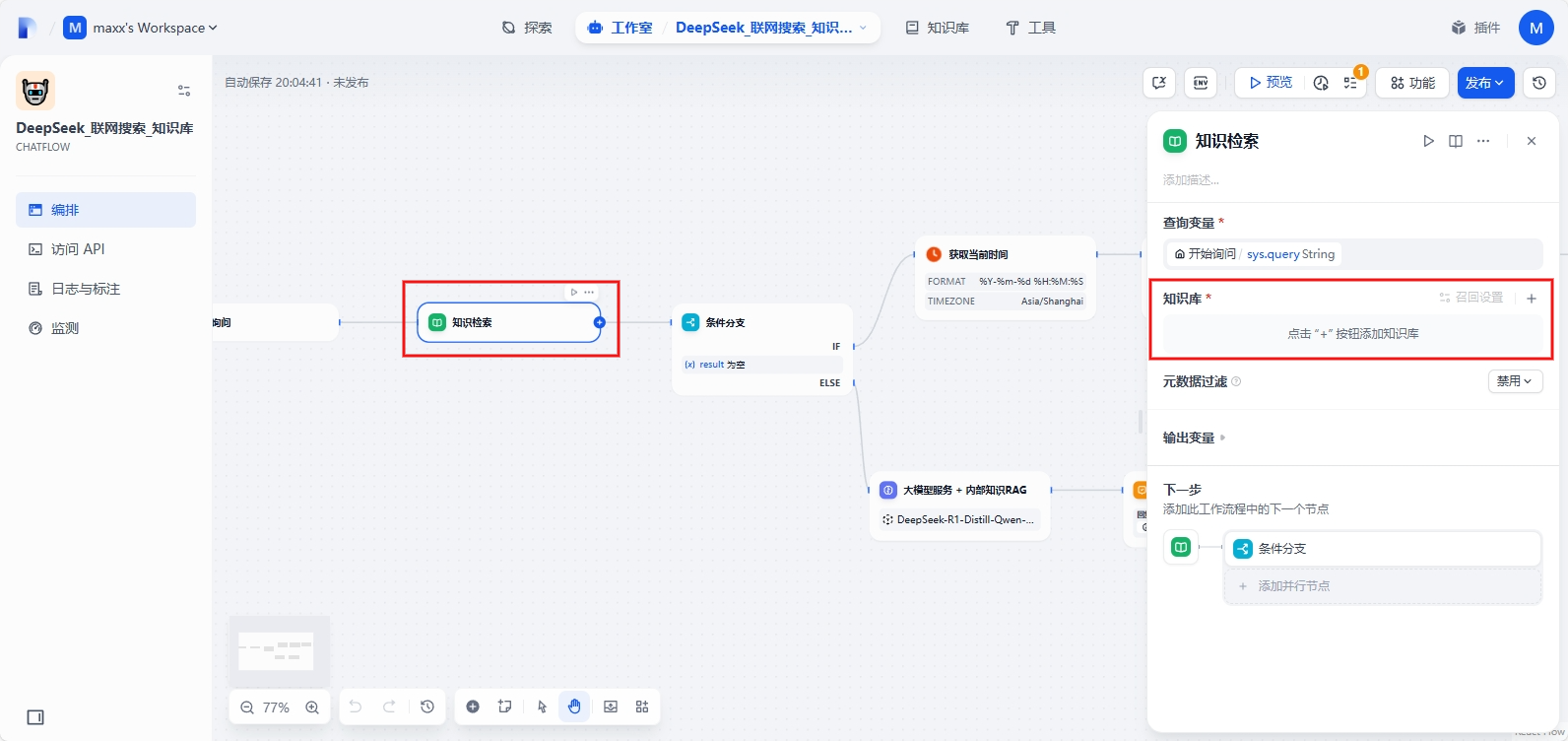

重新编排修改工作流,点击知识检索节点,点击“+”按钮添加知识库,选择刚刚创建的知识库,点击添加

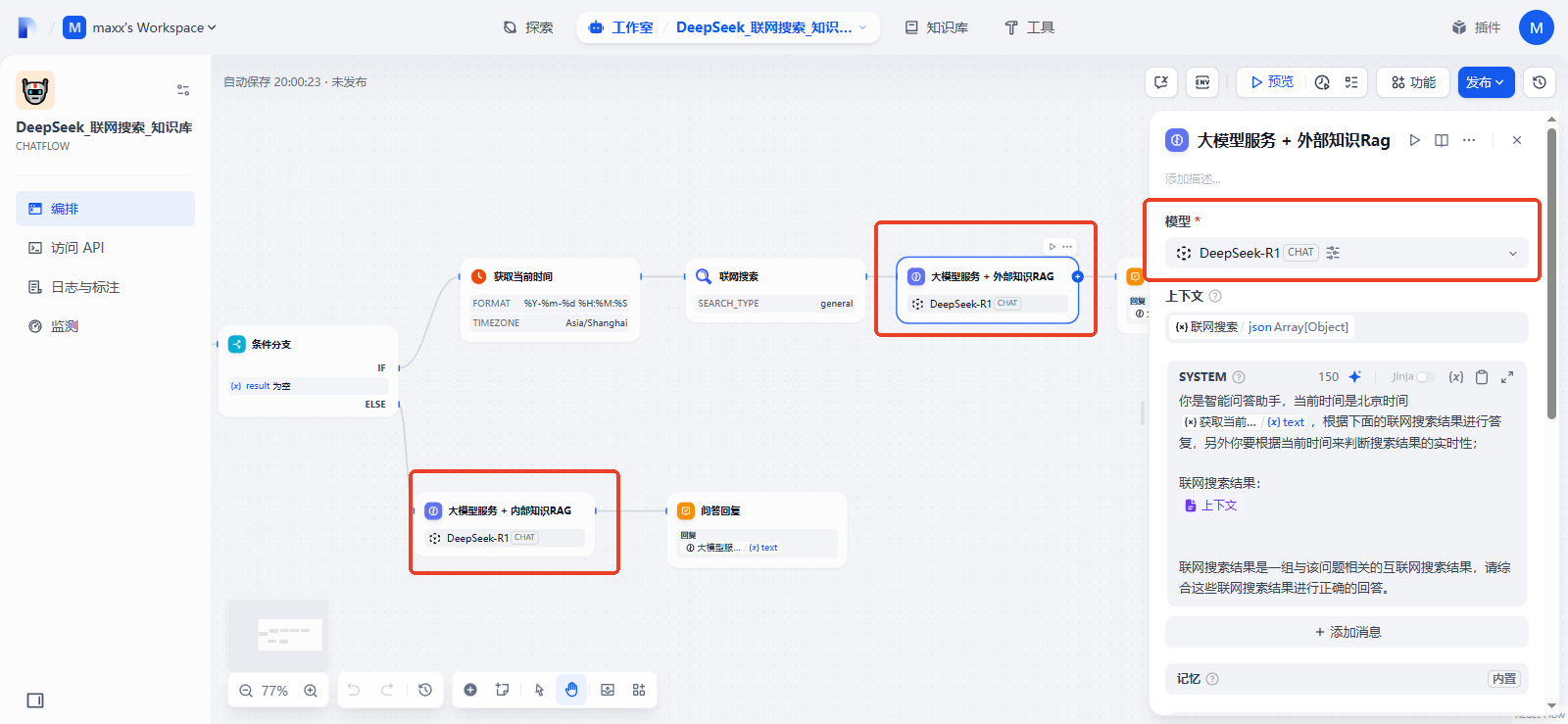

选择DeepSeek模型,此工作流配置的两个大模型服务节点,都需要调整为您在ModelArts Studio中部署的DeepSeek模型(此处本工作流默认模型为DeepSeek-R1-Distill-Qwen-32B),选中节点后,在右侧配置页面进行模型选择

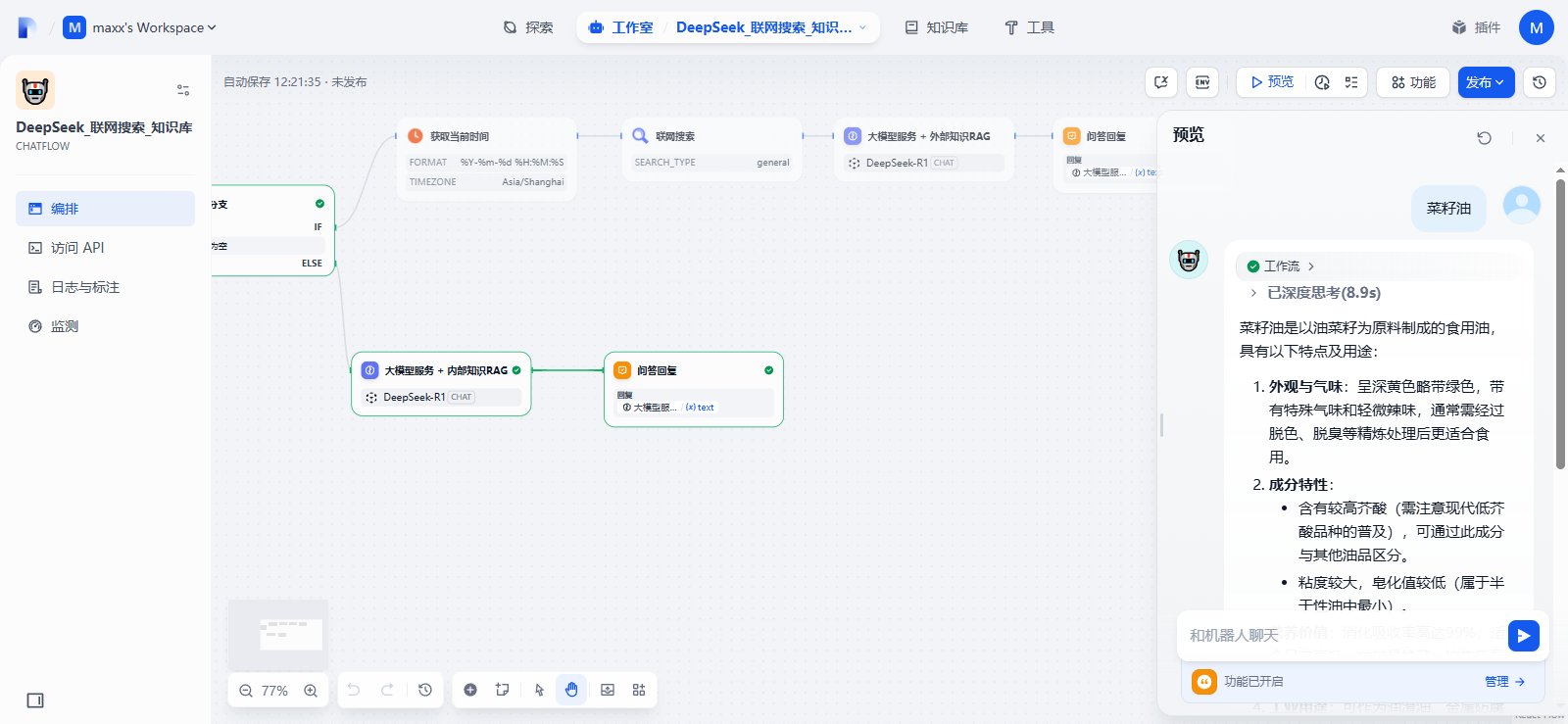

测试工作流:在工作流页面,点击“预览”按钮,在弹出的聊天框输入问题进行测试,当输入提示词命中知识库内容时,走的是下面的分支

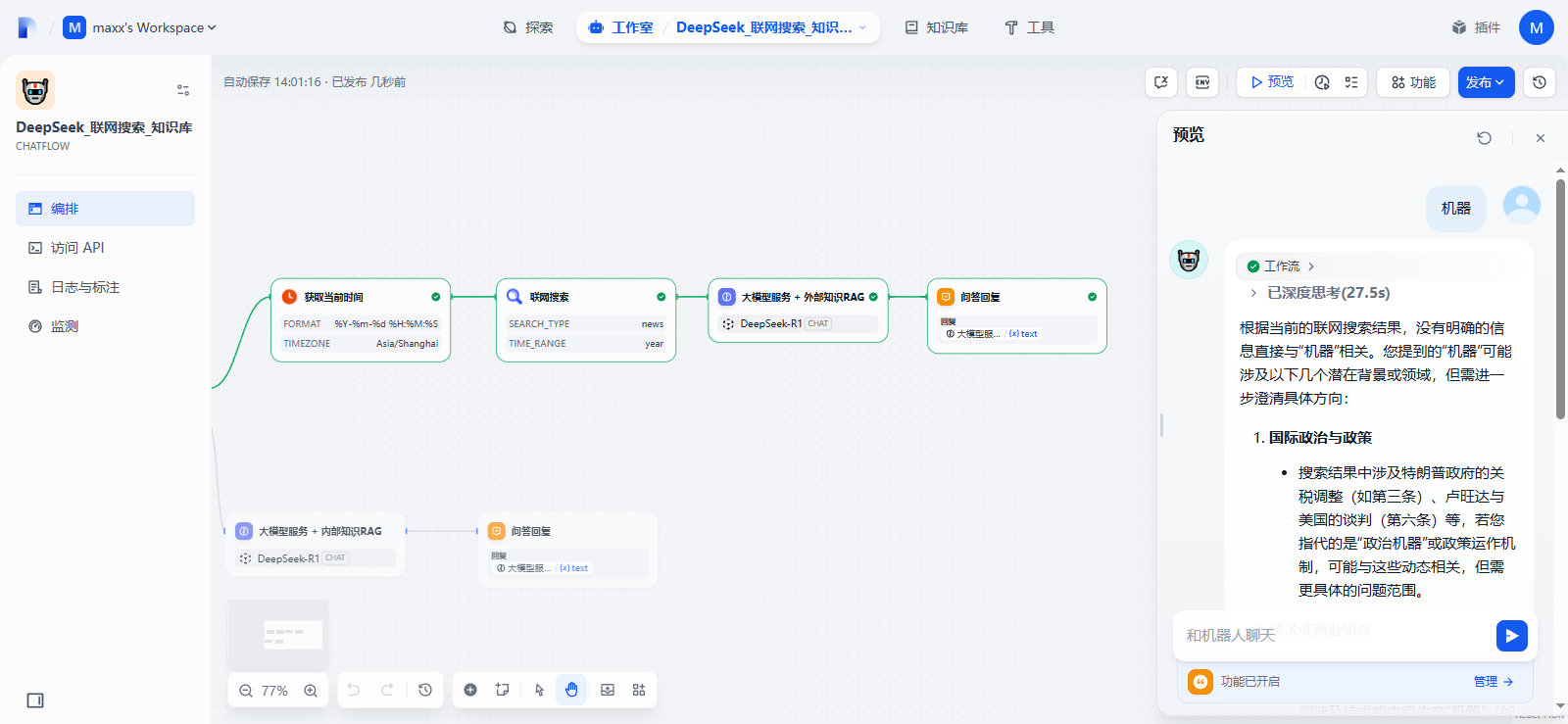

当输入提示词未命中知识库内容时,走的是上面的分支,进行联网搜索再回答

联网搜索出现 SearXNG 出现报错:

Run failed: Failed to transform tool message: PluginInvokeError: {“args”:{},“error_type”:“ValidationError”,“message”:“1 validation error for SessionMessage\ndata\n Input should be a valid dictionary [type=dict_type, input_value=(‘type’, \u003cMessageType.TEXT: ‘text’\u003e), input_type=tuple]\n For further information visit https://errors.pydantic.dev/2.11/v/dict_type”}

解决方案:

暂不知原因,解决将SEARCH_TYPE修改为综合以外的分类,我这里选择为新闻news

测试完成没有问题,在工作流页面的右上角点击发布按钮,再点击发布,即可完成工作流发布。

3.3 使用知识库问答助手

我们在发布的正式环境中测试,先输入一个知识库中未包含的内容测试,结果是未命中,提供联网搜索再输出的

输出结果如下:

然后再输入一个知识库中包含的内容,结果是命中,总结知识库内容并输出

输出结果如下:

四、总结

基于Dify构建具备联网搜索能力的知识库问答助手,通过云端部署Dify平台,结合华为云MaaS提供的大模型(如DeepSeek),并配置向量数据库实现混合检索(语义+关键词)。用户上传文档后,系统自动进行文本分段、向量化处理,通过RAG技术增强生成答案的准确性。同时,集成联网搜索模块可实时获取外部信息,弥补知识库的时效性局限。该方案适用于企业知识管理、个人知识库检索等场景,兼顾数据安全与智能交互需求。

华为云Flexus X云服务器通过柔性算力技术实现CPU/内存灵活配比,结合X-Turbo加速使关键应用性能达业界6倍;MaaS平台提供高性能DeepSeek-R1等API服务,支持200万免费Token及商用级稳定调用,两者协同为企业提供高性能、高可靠的智能化云服务解决方案。

828 B2B企业节已经开幕,汇聚千余款华为云旗下热门数智产品,更带来满额赠、专属礼包、储值返券等重磅权益玩法,是中小企业和开发者上云的好时机,建议密切关注官方渠道,及时获取最新活动信息,采购最实惠的云产品和最新的大模型服务!

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)