使用 Amazon SageMaker 将基础模型推理扩展到数百个模型

该视频详细介绍了亚马逊SageMaker在高效部署大量大型基础模型以进行推理方面的最新功能。过去,每个模型都需要自己的单独端点,这导致了高昂的运营成本。如今,SageMaker通过其推理组件将多个模型集成至单一端点,从而实现计算资源的充分利用、各模型独立扩展以及智能路由以提高性能。Salesforce已采用此功能将其成本降低50%,同时保持原有的速度。此外,SageMaker还推出了一种新型的大型

关键字: [Amazon Web Services re:Invent 2023, SageMaker, Foundation Models, Sagemaker, Inference Scaling, Multi-Model Endpoints, Large Model Optimizations]

本文字数: 1400, 阅读完需: 7 分钟

视频

如视频不能正常播放,请前往bilibili观看本视频。>> https://www.bilibili.com/video/BV1Ba4y1R7Zv

导读

公司需要强大且经济高效的解决方案,大规模部署基础模型。此外,SaaS 提供商需要可扩展和经济高效的方法,为其客户提供数百个模型。本论坛探索如何使用 Amazon SageMaker 大规模经济高效地推出数百个基础模型。详细概述支持 SaaS 大规模生成式 AI 推理的部署策略,并了解如何构建最大限度地提高性能和成本扩展能力的解决方案。

演讲精华

以下是小编为您整理的本次演讲的精华,共1100字,阅读时间大约是6分钟。如果您想进一步了解演讲内容或者观看演讲全文,请观看演讲完整视频或者下面的演讲原文。

杜尔·帕特尔是亚马逊云科技机器学习专家团队的负责人,他在re:Invent上向观众发表欢迎致辞。他表示,虽然他曾开玩笑地希望整个演讲都通过AI生成,但实际上却是人工制作的。杜尔协助Salesforce等客户在亚马逊云科技平台上拓展他们的机器学习工作负载。他的同事艾伦·陈将介绍SageMaker的新推断功能。杜尔非常荣幸能邀请Salesforce的帕维特拉·多西来展示他们团队如何利用SageMaker高效地扩展基础模型的推断能力。

杜尔解释称,企业正积极地将生成性AI融入其运营中,以释放生产力和潜力。构建生成性AI应用程序的关键在于基础模型——为特定任务微调的大型预训练基于变换器的模型。他指出,大多数实际应用需要协同工作的大量基础模型,从几十到几百不等。

例如,一个生成性的聊天机器人可以依赖十几个不同的基础模型来实现各种功能:

- 毒性检测,以中和不安全内容

- PII检测,以掩盖个人身份信息

- 摘要,以压缩长对话

- QA模型,以回答用户问题

- 工作流程生成,以提供下一步建议

- 搜索模型,以查找相关信息

- 排名模型,以对响应进行排序和过滤

- 内容审核,以确保符合指导原则

- 情感分析,以衡量用户情绪

- 意图识别,以确定用户目标

- 对话管理,以根据上下文继续对话

- 文本生成,以产生回应

- 音频生成,以合成语音

此外,顾客还希望在生产部署前在自己的数据上调整这些模型以提高准确性。在处理文本、图像和视频等多模态输入时,模型的数量迅速增长到几百个。迫切需要一个可扩展且成本高效的方式来托管这些大量的基础模型。

接着,杜尔展示了将一个基础模型部署到生产过程中的流程——拥有130亿参数、53GB的LAMA-2模型。一个模型的内存占用是根据参数和数据类型数量计算出来的。仅针对LAMA-2的130亿fp32参数就需要4个字节,而这些参数本身就已经占据了52GB的空间。

此外,自回归解码过程会产生一个临时激活张量,占用额外的4至10GB内存。这会使框架开销再增加3至4GB。因此,总的来说,LAMA-2需要一个65GB的RAM来加载一个实例。

Daul选择一个配备了8个Nvidia A100 GPU的p4d实例,每个GPU都有40GB的高带宽内存。然而,由于LAMA-2超过了单个GPU的内存限制,因此采用了模型并行技术将其分散到两个GPU上。这样一来,还剩下6个空闲的GPU。通过加载额外的LAMA-2副本以充分利用资源,但在流量低时可能会风险过度供应。

SageMaker提供了多种推理选项,如实时、异步、流处理等,以在CPU、GPU或无服务器环境下规模化地托管一个或多个模型。还可以根据流量、利用率或延迟来设置自动缩放策略。Daul使用SageMaker实时推理部署了LAMA-2,这是一个专为变压器优化的大模型推理容器。

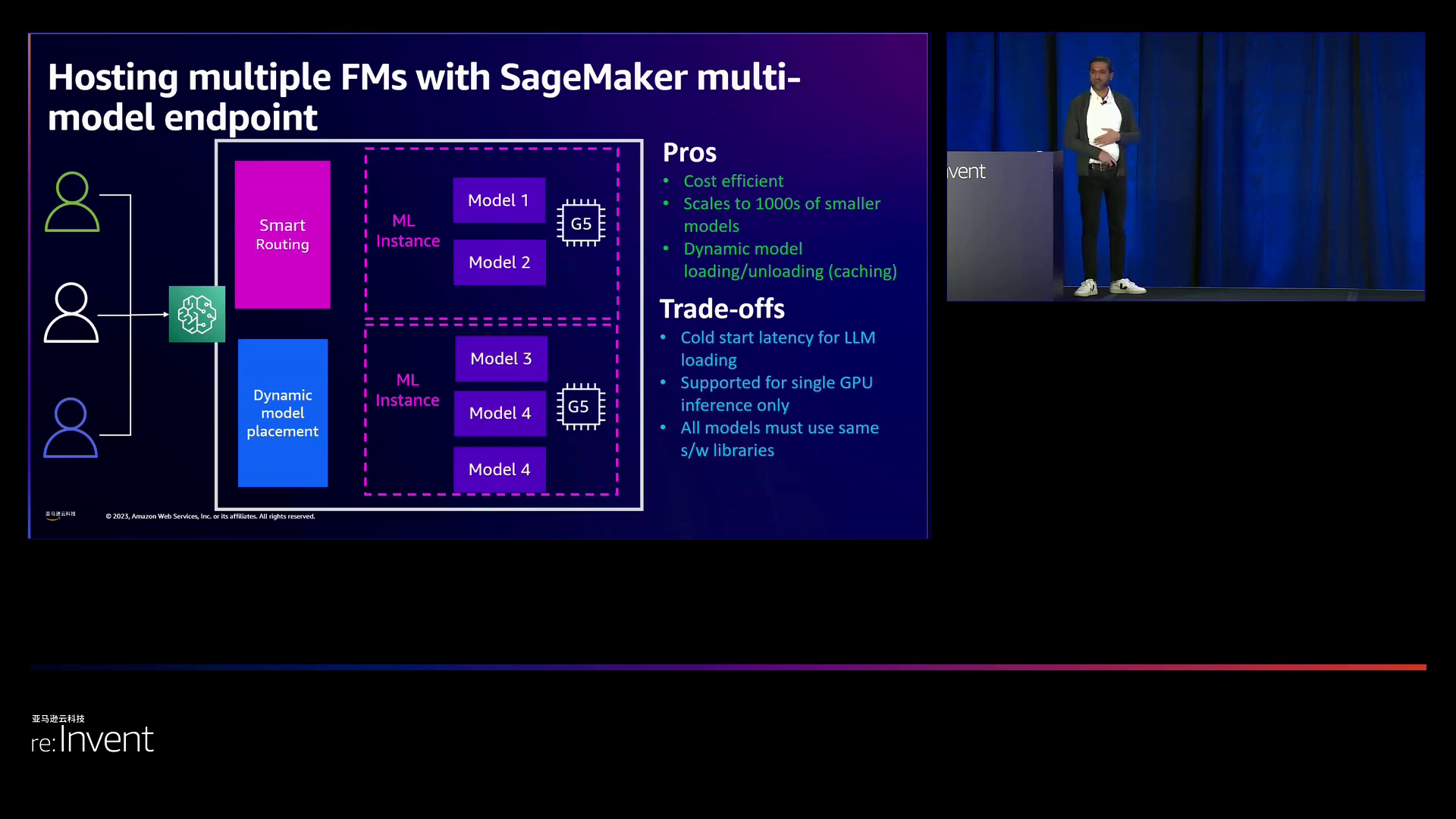

随着更多用于不同用例的模型的添加,管理所有端点的操作变得越来越具有挑战性。SageMaker的新多模型端点可以动态地在一组模型中共同托管,降低成本约50%。但是,每个模型的首次调用都具有与模型大小成比例的冷启动延迟,对于大型模型来说可能是秒到分钟。

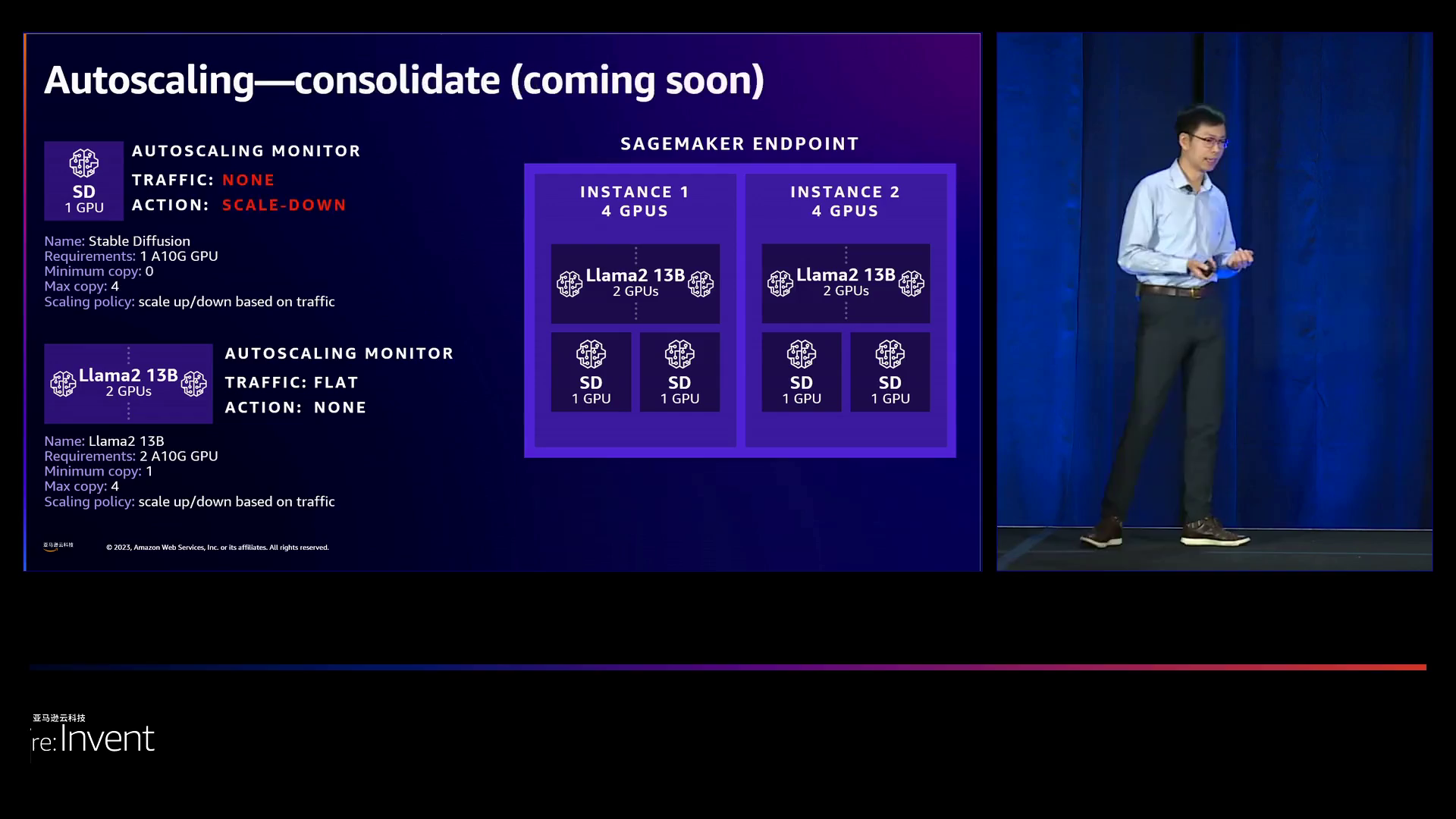

对于超低延迟应用,在请求之前需要在内存中预加载模型以避免冷启动。模型之间有防止干扰的安全护栏。基于实际流量的每模型自动缩放允许根据需求调整资源。

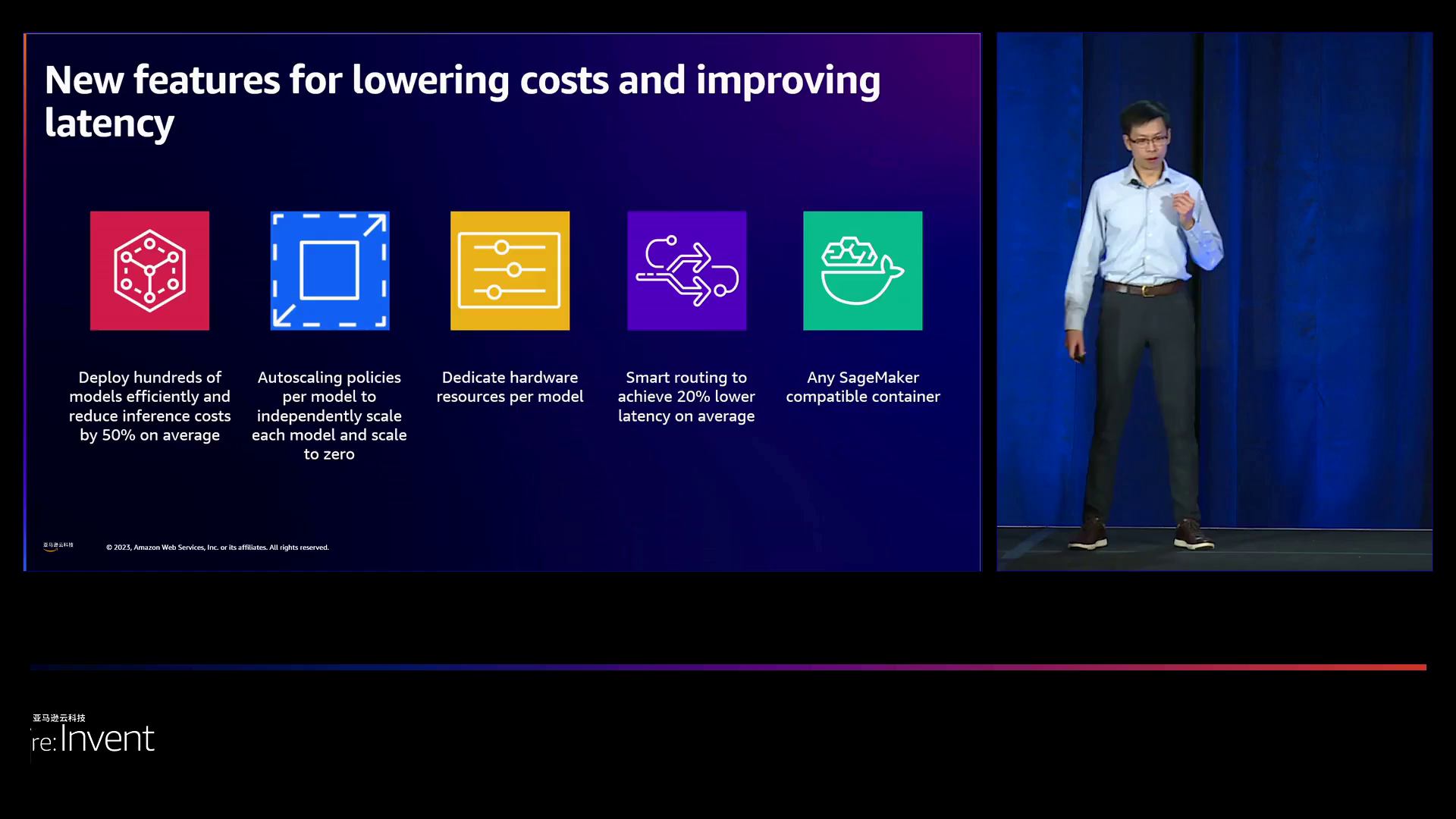

Alan Tan介绍了SageMaker推断组件以满足这些需求。一个组件封装了一个已经部署的模型及其指定的容器、艺术品和资源要求,包括:

- 容器镜像位置

- S3中的模型艺术品

- 所需的CPU内核数、GPU或Inferentia芯片

- 所需的CPU和内存

- 要开始的副本数

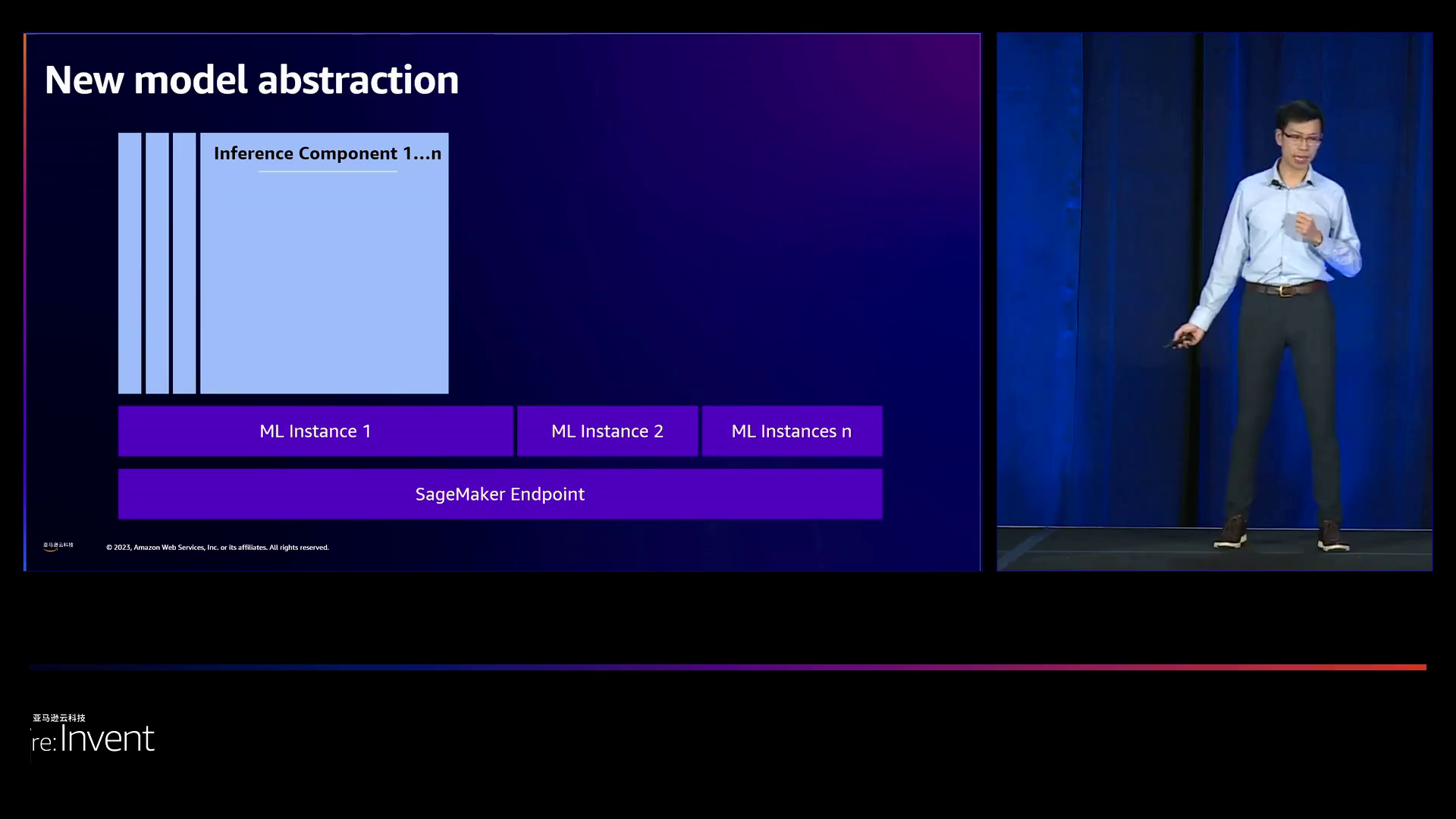

可以在一个端点上独立托管多个组件。每个组件都有自己的基于流量或指标的自动缩放策略,以调整到零。一个新的智能路由算法通过避免超载的实例将平均延迟降低20%。详细的CloudWatch指标提供模型级别的可观察性,以便进行调试和监控。

艾伦通过使用Stable Diffusion和GPT-2模型的漫画生成应用程序展示了这些功能。SageMayer Studio UI使得创建一个多模型端点变得轻松,可以将模型作为组件进行部署、测试推理并配置每个模型的自动缩放规则。在幕后,根据流量情况,模型副本会自动进行上下调整。演示显示,当流量增加时,GPT-2从1份扩展到5份,然后在流量减少时缩小回1份。这样做的目的是只有在必要时才启动新实例,以便最大限度地提高资源利用率。

接着,Salesforce的Bhavish Aggarwal介绍了他们如何在Hyperforce上构建Einstein,这是一个集成的AI平台。它连接了各种应用程序的数据,以提供全方位的客户视图,并支持构建具有护栏的可信AI应用。Einstein GPT应用程序将生成性AI嵌入到销售、服务和市场营销等工作流程中。例如,销售GPT通过自动生成潜在客户的电子邮件来帮助销售人员。服务GPT总结支持案例并生成帮助代理的知识文章。市场营销GPT创建活动和细分定义。商务GPT产生产品描述并作为购物助手。开发者GPT生成代码,提供聊天帮助并自动完成编码。

Salesforce与SageMayer合作进行了大规模推理。他们使用单个模型端点部署75GB的CodeGen和55GB的TextGen模型,需要2个利用率不足的p4d实例,每小时花费数千美元。使用SageMayer推理组件,两个模型都适合在一个p4d实例上,没有性能损失,可以预期地将成本降低50%以上。自动缩放和智能路由提供了额外的好处。关键收获是在硬件上整合模型,减小影响而不会影响性能,独立模型缩放和使用大型模型推理容器。

最后,Daul强调了SageMayer大型模型推理容器的新的优化,这平均减少了20%的延迟。该容器支持诸如GPT-3、T5和Stable Diffusion等不同的模型,以及像PyTorch和TensorFlow之类的框架。总之,该视频展示了SageMayer推理组件如何帮助客户在经济高效地扩大生产中的数百个大型基础模型的推理的同时保持性能、可观察性和易于管理。现实生活中的客户示例提供了关于益处和最佳实践的有价值的见解。

下面是一些演讲现场的精彩瞬间:

领导者表示,整个演示文稿是由人类精心制作的,而非人工智能所制作,尽管他们希望AI能达到这样的水平。

亚马逊云科技提供了超低延迟的托管服务,以实现高效资源分配,降低成本为目标。

领导者宣布推出了全新的SageMaker推理和点推理组件,旨在提高性能。

亚马逊云科技增强了灵活性,能够在单个端点上高效地部署多个模型,从而平均降低50%的推理成本。

亚马逊云科技推出的推理组件是一种抽象,用于已经准备好提供服务流量的部署模型。

领导者巧妙地向观众征求对演示文稿的反馈。

总结

该视频详细介绍了亚马逊SageMaker在高效部署大量大型基础模型以进行推理方面的最新功能。过去,每个模型都需要自己的单独端点,这导致了高昂的运营成本。如今,SageMaker通过其推理组件将多个模型集成至单一端点,从而实现计算资源的充分利用、各模型独立扩展以及智能路由以提高性能。Salesforce已采用此功能将其成本降低50%,同时保持原有的速度。

此外,SageMaker还推出了一种新型的大型模型推理容器,其中包含诸如全减少算法等优化措施,使得转换器延迟降低20%。将这些创新相结合,SageMaker能够无缝地将一个模型扩展至数百个模型。

视频中展示了全新的用户界面和指标,可用于监控和调整每个模型的性能。同时还概述了一些建议的最佳实践,例如为模型分配相同数量的硬件资源并利用自动扩展功能。针对实时应用程序,应关注优化首字节延迟。总之,SageMaker推理组件为用户提供了一种简单易行的方法来最大限度地提高基础模型的利用率。

演讲原文

https://blog.csdn.net/just2gooo/article/details/134838435

想了解更多精彩完整内容吗?立即访问re:Invent 官网中文网站!

2023亚马逊云科技re:Invent全球大会 - 官方网站

点击此处,一键获取亚马逊云科技全球最新产品/服务资讯!

点击此处,一键获取亚马逊云科技中国区最新产品/服务资讯!

即刻注册亚马逊云科技账户,开启云端之旅!

【免费】亚马逊云科技中国区“40 余种核心云服务产品免费试用”

亚马逊云科技是谁?

亚马逊云科技(Amazon Web Services)是全球云计算的开创者和引领者,自 2006 年以来一直以不断创新、技术领先、服务丰富、应用广泛而享誉业界。亚马逊云科技可以支持几乎云上任意工作负载。亚马逊云科技目前提供超过 200 项全功能的服务,涵盖计算、存储、网络、数据库、数据分析、机器人、机器学习与人工智能、物联网、移动、安全、混合云、虚拟现实与增强现实、媒体,以及应用开发、部署与管理等方面;基础设施遍及 31 个地理区域的 99 个可用区,并计划新建 4 个区域和 12 个可用区。全球数百万客户,从初创公司、中小企业,到大型企业和政府机构都信赖亚马逊云科技,通过亚马逊云科技的服务强化其基础设施,提高敏捷性,降低成本,加快创新,提升竞争力,实现业务成长和成功。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)