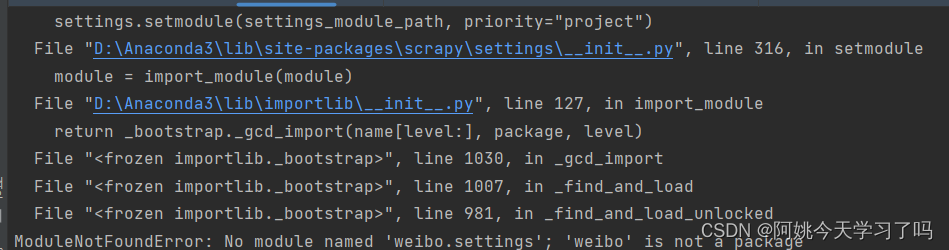

爬虫报错 ModuleNotFoundError: No module named ‘weibo.settings‘; ‘weibo‘ is not a package

爬虫报错 ModuleNotFoundError: No module named 'weibo.settings'; 'weibo' is not a package最后发现是python解释器的问题。

·

项目场景:

启动微博爬虫时,一直有这种情况,尝试解决了好几天,网上也没有具体能解决此问题的方法。经过很久的调试,最后发现是python解释器配置的问题。

问题描述

cd到爬虫项目目录,使用scrapy crawl search 启动爬虫时会遇到的情况:

原因分析:

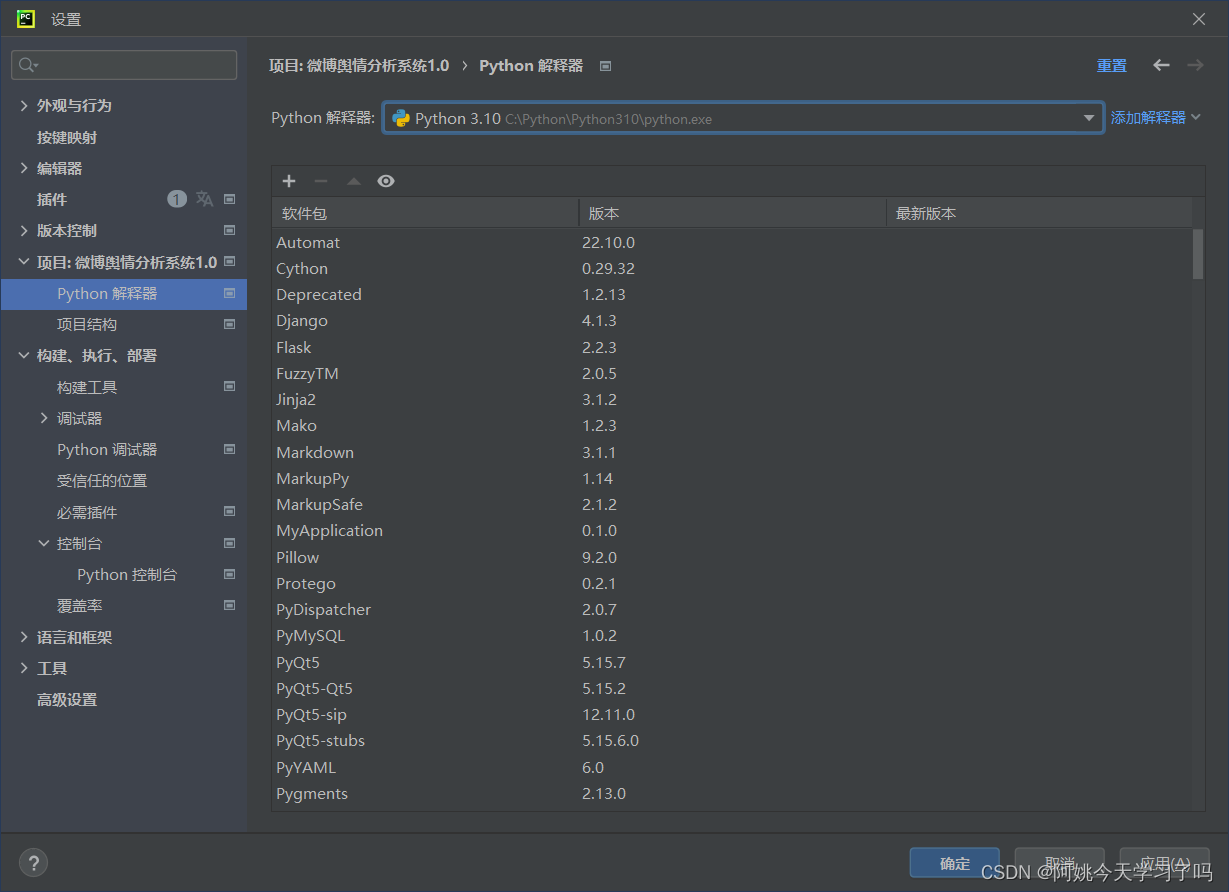

其实这是环境设置的问题,使用默认的解释器虽然方便,但是总会有意想不到的报错,所以最好使用虚拟环境。

这里使用的就是默认解释器,虽然安装了所有所需的包,但还是会报错,所以还是新建一个虚拟环境吧。

解决方案:

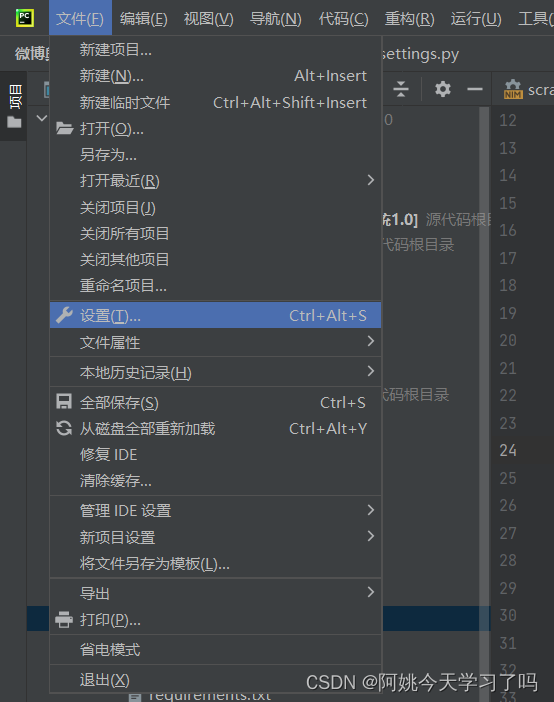

创建虚拟环境第一步,左上角文件-设置

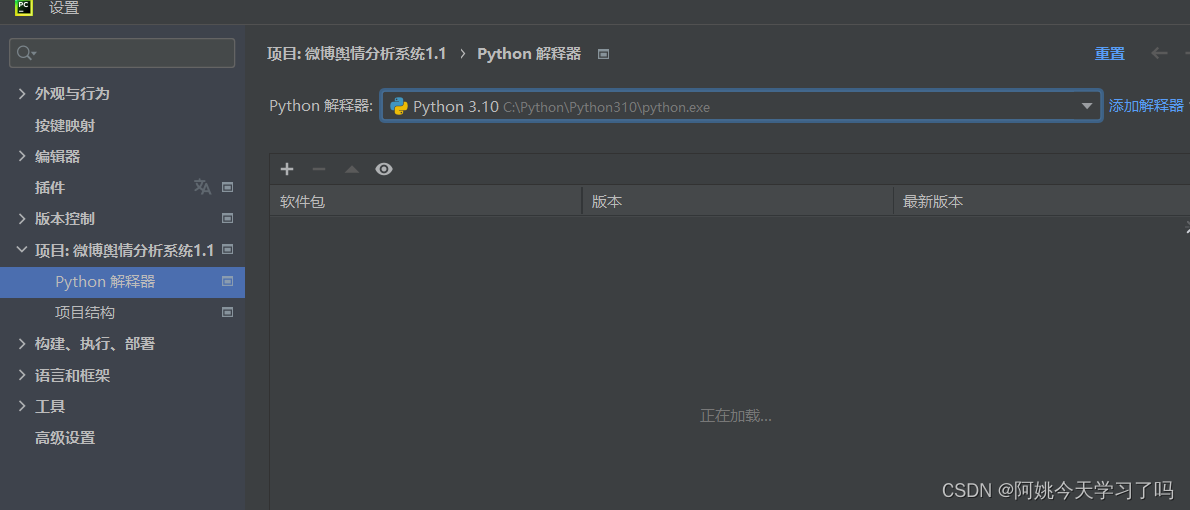

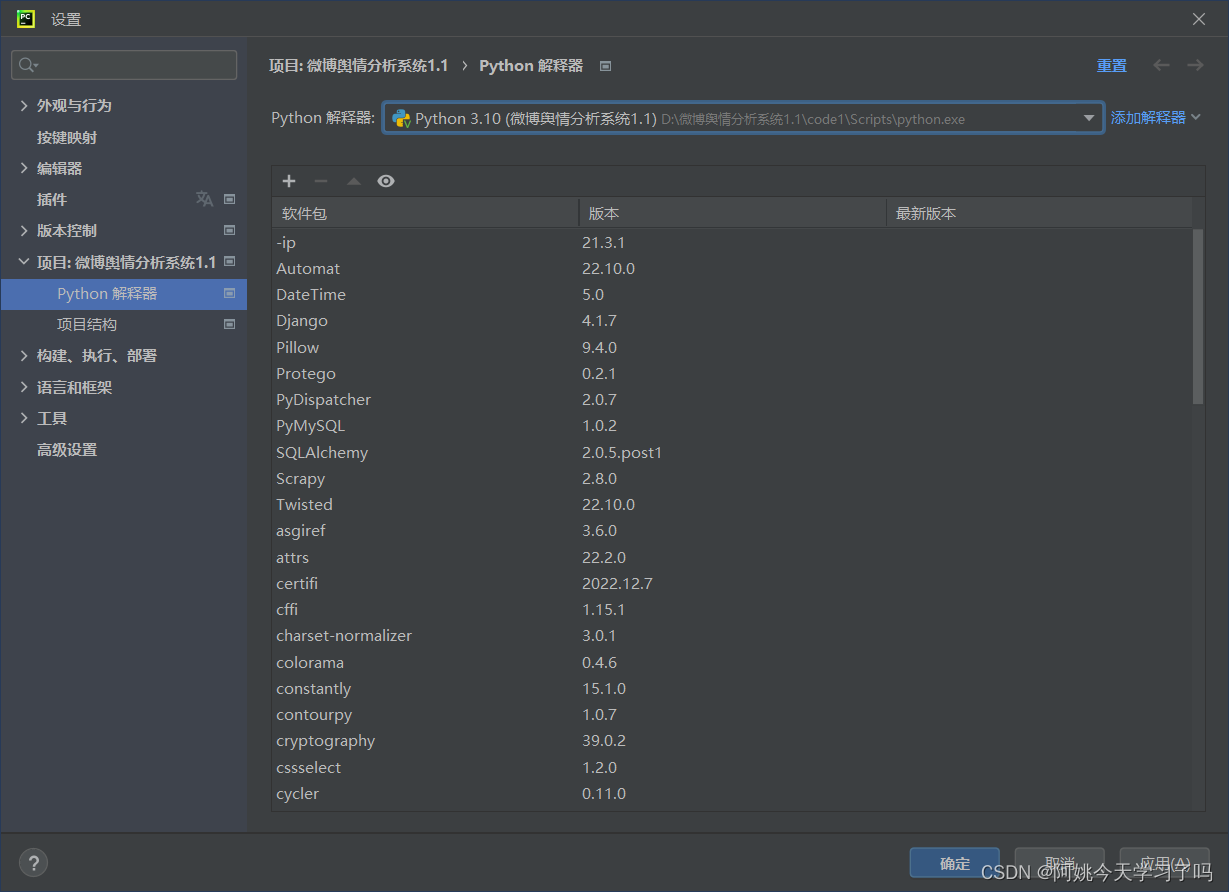

找到项目,然后找到右上角添加解释器,选择添加本地解释器

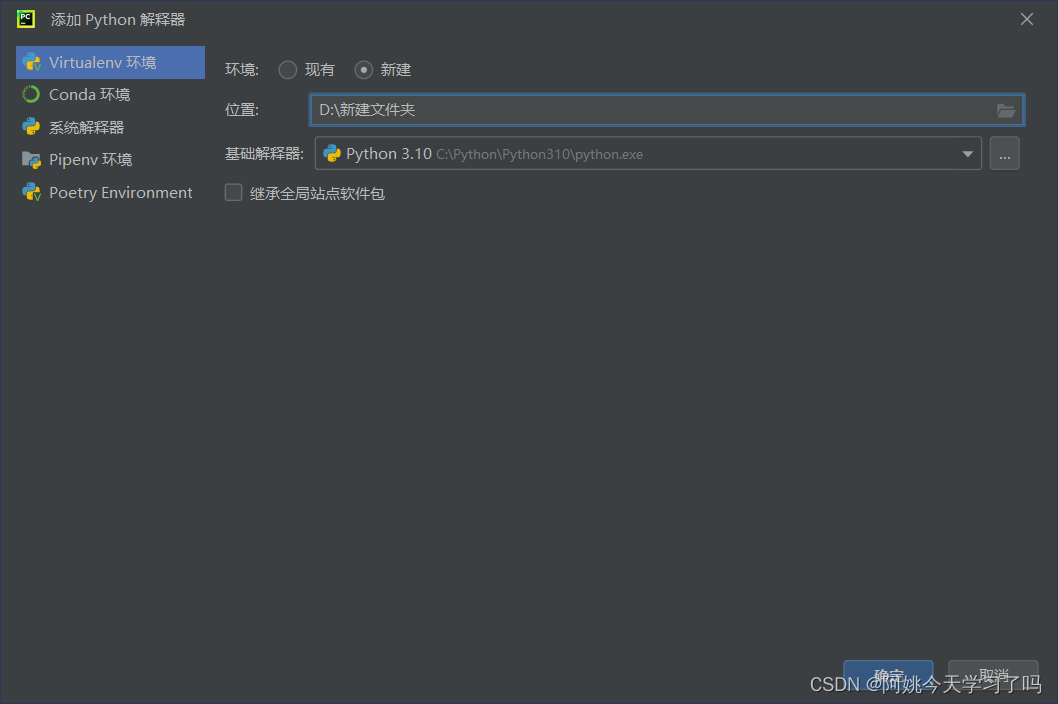

选择新建,位置可以选择在项目文件夹的位置,基础解释器就用之前的解释器。

虚拟环境就创建完成了,再在里面pip install需要的包就可以了,报错就消失了。

这个方法解决了我遇到的上述问题,但如果新建虚拟环境没有解决你遇到的问题,那建议你再看看是不是代码问题,或者再去找找其他解决办法,希望你的问题能够得到解决。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)