三种梯度下降(全量梯度下降,随机梯度下降,小批量梯度下降)

三种梯度下降方式区别仅在于求梯度所用到的X数据集的样本数量不同!全量梯度下降(BGD)全部的样本都用上优点:每次都会朝着正确的方向进行,最终保证收敛到极值点缺点:每次学习实践过长,并且如果训练集很大以至于需要消耗大量的内存,不能进行在线参数模型更新。随机梯度下降(SGD)每次从训练集中选择一个样本进行学习优点:每次只选择一个样本学习,那么学习的速度非常快,并且可以在线更新模型。缺点:每次更新可能不

·

三种梯度下降方式区别仅在于求梯度所用到的X数据集的样本数量不同!

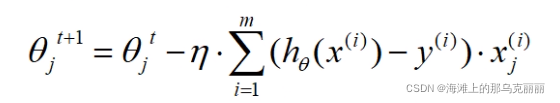

全量梯度下降(BGD)

全部的样本都用上

优点:

每次都会朝着正确的方向进行,最终保证收敛到极值点

缺点:

每次学习实践过长,并且如果训练集很大以至于需要消耗大量的内存,

不能进行在线参数模型更新。

随机梯度下降(SGD)

每次从训练集中选择一个样本进行学习

优点:

每次只选择一个样本学习,那么学习的速度非常快,并且可以在线更新模型。

缺点:

每次更新可能不会按照正确的方向进行,可能有扰动。

扰动也有好处,有可能从一个局部极小值跳到另一个局部极小值

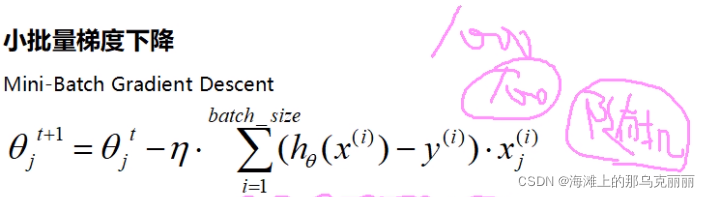

小批量梯度下降(折中的方法)(min_batchGD)

在每次更新速度和更新次数之间取一个平衡

优点:相较于随机梯度下降降低了收敛波动性,是更新更加稳定。

相较于全量梯度下降,提供了更新速度,不必担心内存瓶颈可以利用矩阵运算高效计算

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)