本地部署Xinference实现智能体推理工作流(一)

其他问题:conda activate xinference命令好像只有第一次运行的时候需要输入这个命令,后面再启动服务的话直接输入:xinference-local --host 0.0.0.0 --port 9997命令就可以了。① 首先创建一个实例,然后安装Xinference(安装原因:用Xinference安装会自己生成API接口,但使用其他人创建好的模型或官方模型不好使,不知道原因,有

提示:没有安装Docker的需要先提前安装好Docker

第一篇章 使用AutoDL平台快速部署xinference

备注:若使用AutoDL平台,以下过程使用无卡模型开机即可(省钱)

因为我本地电脑性能不够,所有这里我在AutoDL平台部署ChatGLM

① 首先创建一个实例,然后安装Xinference(安装原因:用Xinference安装会自己生成API接口,但使用其他人创建好的模型或官方模型不好使,不知道原因,有知道的可以打在评论区)

② 运行命令(需要下载很久,嫌慢的可以使用我下载安装好的镜像):

$ pip install "xinference[all]"

③ 创建xinference运行的python虚拟环境

运行命令:conda create -n xinference python=3.10

④ 运行虚拟环境

执行命令:conda activate xinference

⑤ 在虚拟环境中运行xinference

执行命令:

xinference-local --host 0.0.0.0 --port 9997

⑥ 可以看到服务已经起来了,然后我们用linux的隧道传输功能将AutoDL中的端口映射到自己的本地电脑。

⑦ 本来想用MAC代理的,但不知道什么原因,MAC无法建立连接,所以只能用另一台Windows系统了。

代理成功后后如图所示:

(坑:要代理的端口号必须和服务器上运行的服务的端口号保持一样,不然无法代理成功):

其他问题:conda activate xinference命令好像只有第一次运行的时候需要输入这个命令,后面再启动服务的话直接输入:xinference-local --host 0.0.0.0 --port 9997命令就可以了。

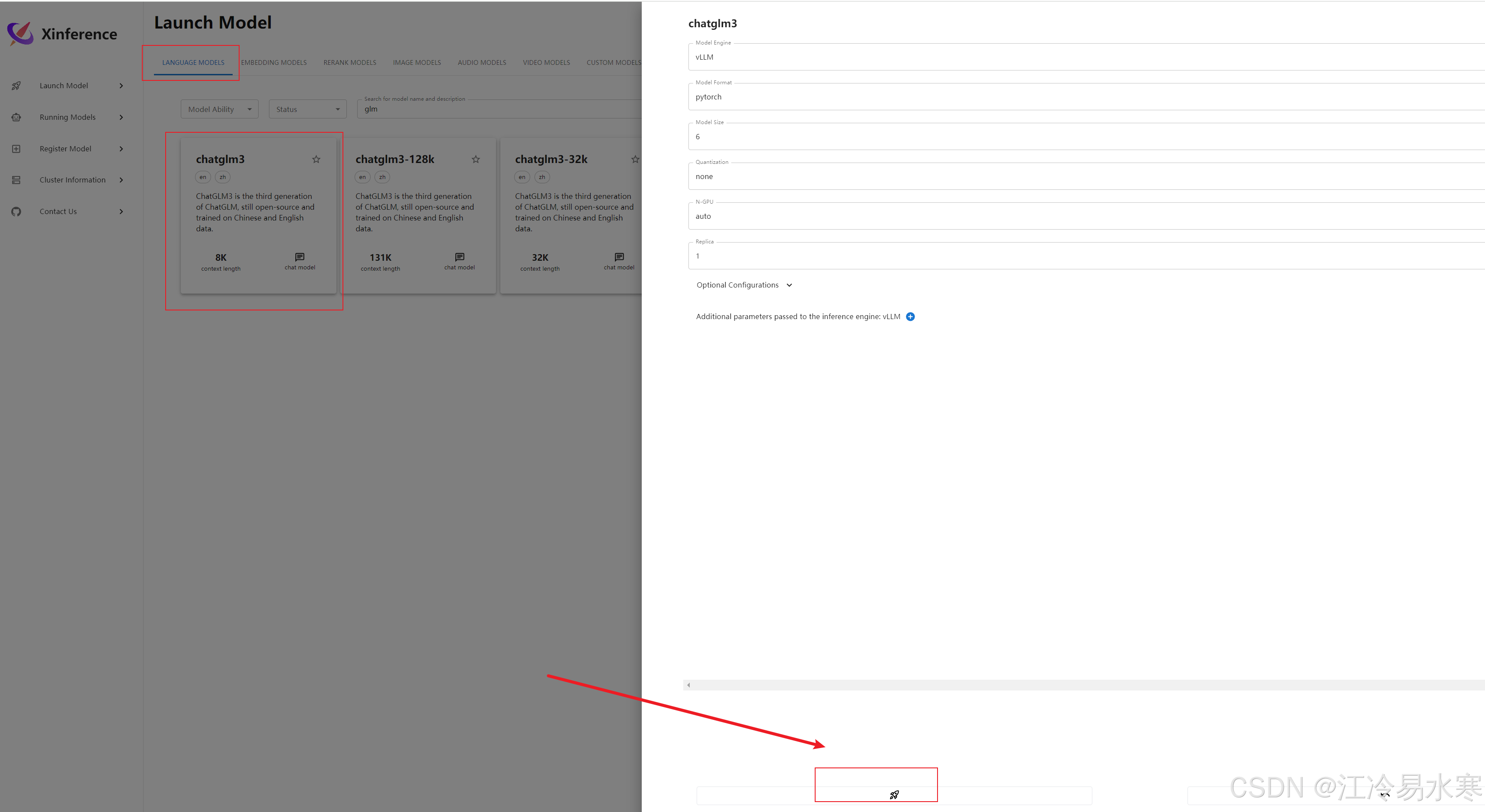

⑧ 下载商店中模型

以使用ChatGLM3为例,由于下载模型需要访问huggingface网站,所以需要科学上网,这里AutoDL已经提供了科学上网的方法:

在启动xinference前先运行如下命令:

source /etc/network_turbo

然后启动xinference服务,点击下面这个小火箭按钮

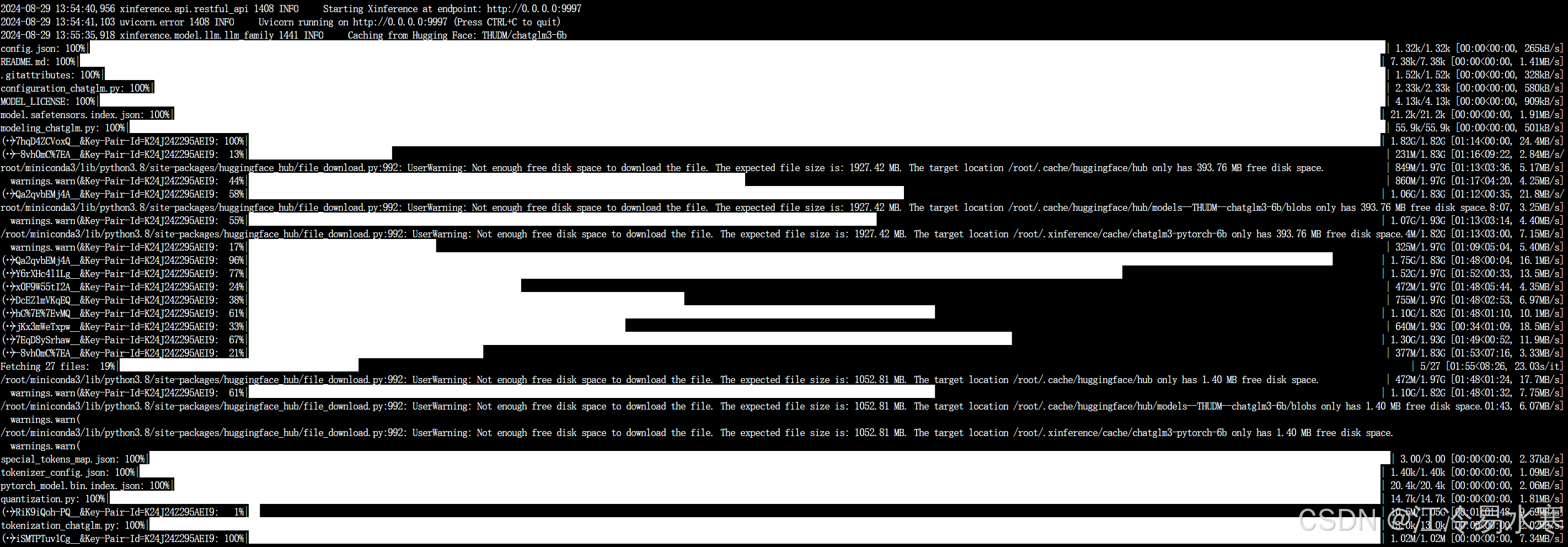

这时候可以看到后台日志正在下载模型:

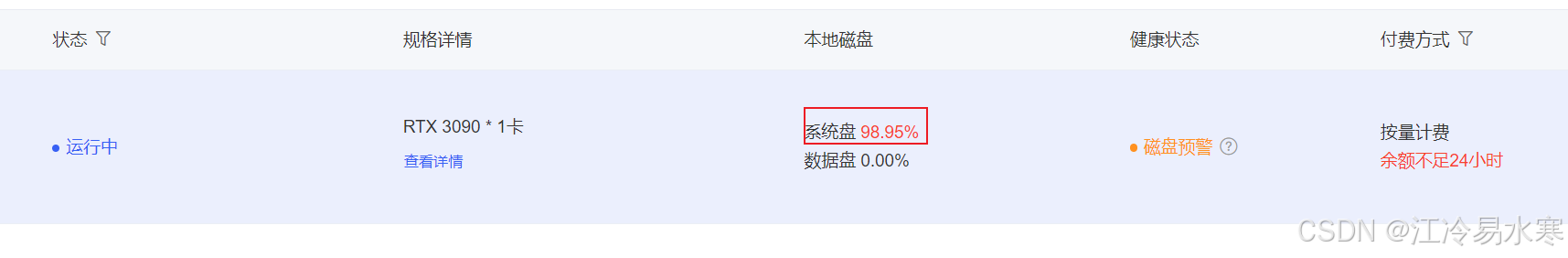

注意:默认镜像会下载到系统盘,而系统盘只有30GB内存,所以不要下载到系统盘中,要指定下载路径,不然系统盘会爆掉

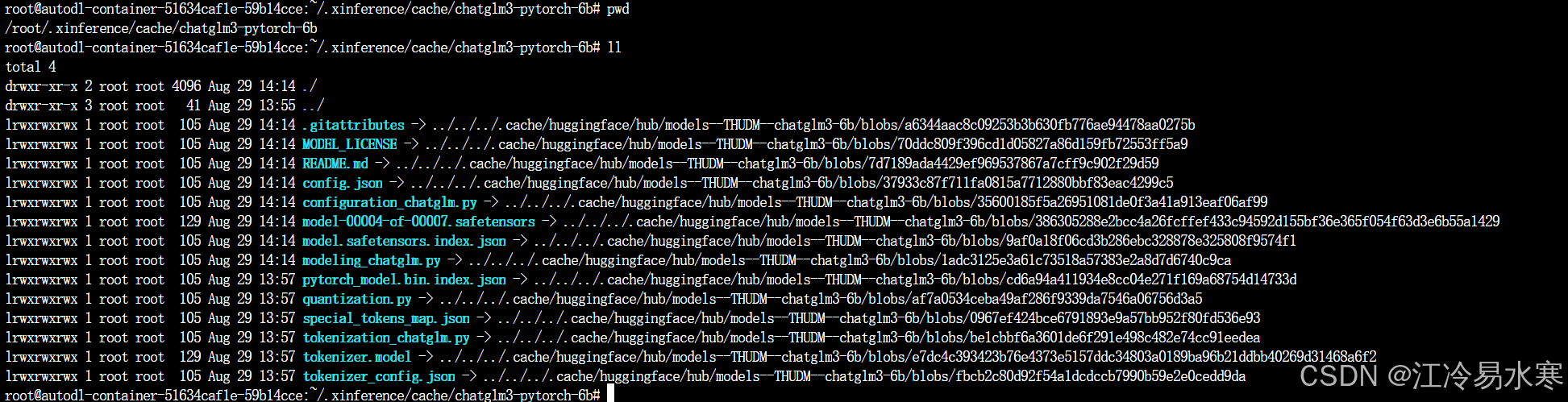

指定下载路径的方式:

默认情况下,Xinference 会使用

<HOME>/.xinference作为主目录来存储一些必要的信息,比如日志文件和模型文件,其中<HOME>就是当前用户的主目录。你可以通过配置环境变量

XINFERENCE_HOME修改主目录, 比如:XINFERENCE_HOME=/root/autodl-tmp/model xinference-local --host 0.0.0.0 --port 9997

科学上网:source /etc/network_turbo

不要安装vllm包,不要选择vllm版本的模型,否则会导致服务无法起来:pip install vllm

启动命令:XINFERENCE_HOME=/root/autodl-tmp/model xinference-local --host 0.0.0.0 --port 9997

XINFERENCE_HOME的作用:指定模型下载路径(export XINFERENCE_HOME)

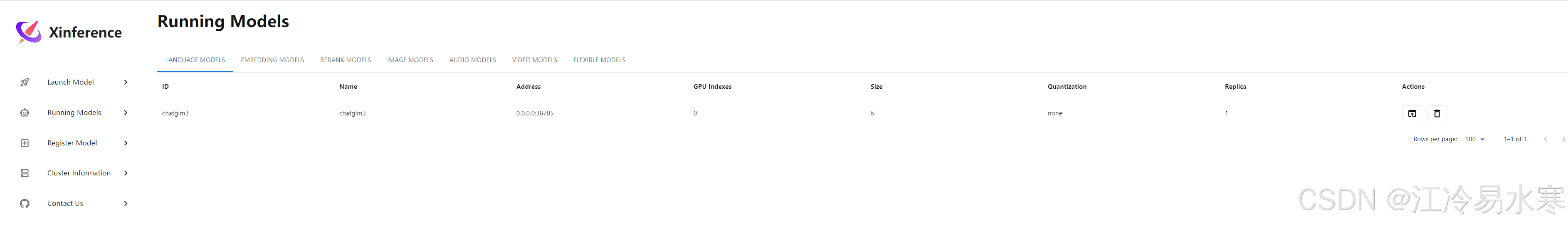

最后,等下载完成后就可以访问使用模型了

其他问题:

大模型启动后输入提问报错:

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)