掌握多层感知机(MLP)的基本原理(以BP神经网络为例)

公式:$$\frac{\partialL}{\partialw}=\frac{\partialL}{\partialy_{\text{pred}}}\cdot\frac{\partialy_{\text{pred}}}{\partialz}\cdot\frac{\partialz}{\partialw}$$在前向传播过程中,输入数据从输入层经过权重和偏置的计算,逐层传递到输出层。通过以上步骤,BP

多层感知机(MultilayerPerceptron,MLP)是一种经典的前馈神经网络,通常由输入层、隐藏层和输出层组成。MLP通过反向传播(Backpropagation,BP)算法进行训练,以学习数据的复杂模式和关联。

下面是关于MLP基本原理的详细解释,以BP神经网络为例:

###1.结构

**输入层**:

-输入层接收输入特征。每个输入节点代表一个特征。

**隐藏层**:

-隐藏层位于输入层和输出层之间,可以有一层或多层。

-每个隐藏层节点(神经元)与输入层的所有节点相连。

-隐藏层的作用是学习输入数据的复杂特征表示。

**输出层**:

-输出层生成模型的预测结果。

-输出层节点数取决于任务的类型,例如回归任务可能只有一个输出节点,而分类任务可能有多个输出节点(每个类别一个)。

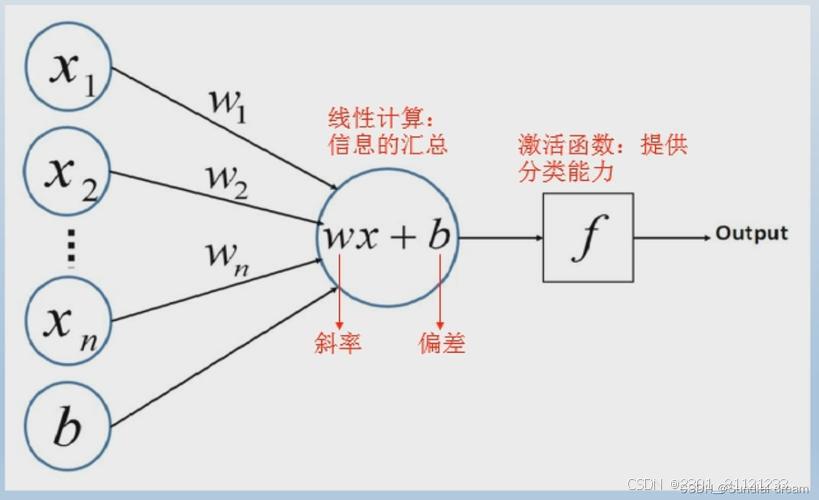

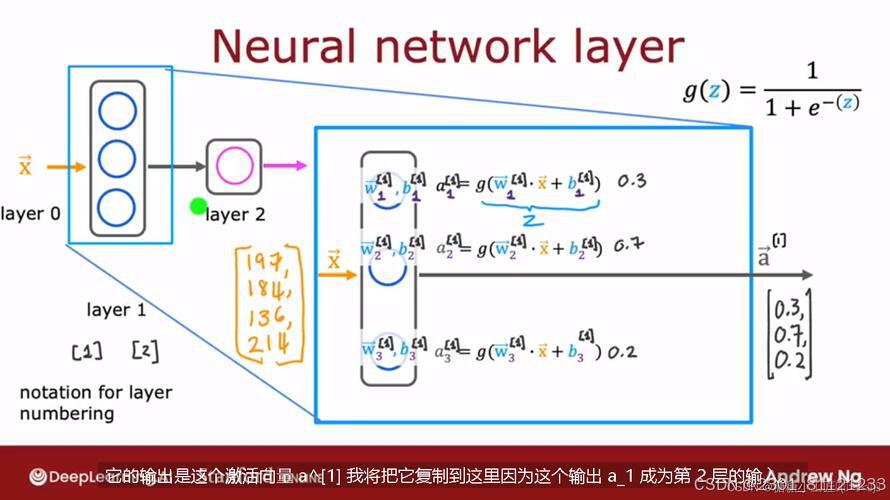

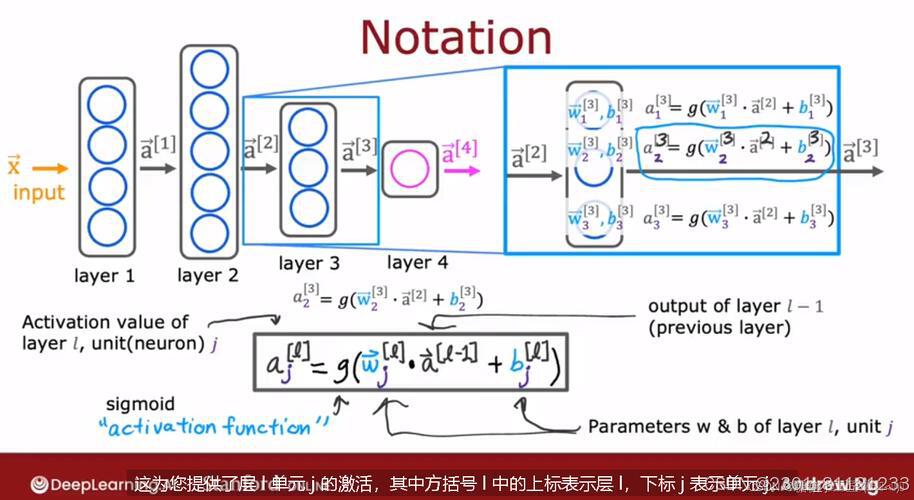

###2.前向传播

在前向传播过程中,输入数据从输入层传递到隐藏层,再传递到输出层,最终生成预测结果。每个神经元的计算过程如下:

1.**加权求和**:

-每个神经元接收来自前一层的输入,并将这些输入进行加权求和。

-公式:$$z=\sum_{i}w_ix_i+b$$

-其中,$w_i$是权重,$x_i$是输入,$b$是偏置。

2.**激活函数**:

-加权求和的结果通过激活函数,生成神经元的输出。

-常用的激活函数包括Sigmoid、Tanh和ReLU。

-例如,Sigmoid函数:$$\sigma(z)=\frac{1}{1+e^{-z}}$$

###3.反向传播

反向传播是用于更新神经网络权重和偏置的算法,基于预测结果与真实标签之间的误差。其步骤如下:

1.**计算损失**:

-使用损失函数(例如均方误差或交叉熵损失)计算预测值与真实值之间的误差。

-公式:$$L=\frac{1}{2}(y_{\text{pred}}-y_{\text{true}})^2$$

2.**计算梯度**:

-通过链式法则,计算损失函数对每个权重的偏导数。

-公式:$$\frac{\partialL}{\partialw}=\frac{\partialL}{\partialy_{\text{pred}}}\cdot\frac{\partialy_{\text{pred}}}{\partialz}\cdot\frac{\partialz}{\partialw}$$

3.**更新权重和偏置**:

-使用梯度下降算法更新权重和偏置,以最小化损失函数。

-公式:$$w_{\text{new}}=w_{\text{old}}-\eta\cdot\frac{\partialL}{\partialw}$$

-其中,$\eta$是学习率。

###4.训练过程

1.**初始化**:

-随机初始化权重和偏置。

2.**前向传播**:

-输入数据通过网络,生成预测结果。

3.**计算损失**:

-计算预测结果与真实标签之间的损失。

4.**反向传播**:

-计算梯度并更新权重和偏置。

5.**迭代**:

-重复前向传播、损失计算和反向传播,直到损失收敛或达到最大迭代次数。

###总结

MLP通过多层神经元的加权求和与非线性激活函数,能够学习复杂的非线性映射。BP算法通过计算损失函数对权重的梯度,并使用梯度下降法更新权重,实现对模型的训练。理解MLP和BP算法的基本原理对于掌握深度学习的基础非常重要。

多层感知机(Multilayer Perceptron,MLP)是一种前馈神经网络,常用于解决分类和回归问题。在实际应用中,常使用BP神经网络作为MLP的训练算法。

BP神经网络是基于误差反向传播算法(Backpropagation,BP)的一种神经网络模型。下面是BP神经网络的基本原理:

1. 网络结构:

BP神经网络通常由输入层、隐藏层和输出层组成。输入层负责接收输入数据,输出层负责输出模型预测结果,隐藏层用于处理数据并构建模型。

2. 权重与偏置:

每个连接都有一个权重,用来控制信号的传递强度。隐藏层和输出层的每个神经元都有一个偏置,用来调整神经元的激活状态。

3. 激活函数:

激活函数将输入转换为输出,常用的激活函数有sigmoid、ReLU等。在BP神经网络中,激活函数通常用来引入非线性,提高模型的拟合能力。

4. 前向传播:

在前向传播过程中,输入数据从输入层经过权重和偏置的计算,逐层传递到输出层。每个神经元根据权重和偏置进行加权求和,并经过激活函数的处理,得到输出。

5. 反向传播:

反向传播是BP神经网络的核心算法,用于更新权重和偏置。首先计算输出层的误差,然后根据误差逐层反向传播,更新每个神经元的权重和偏置。这个过程使用梯度下降算法,通过最小化损失函数来调整模型参数。

6. 训练过程:

在训练过程中,将输入数据输入到网络中进行前向传播和反向传播,计算误差并更新模型参数。重复这个过程直到达到预定的停止条件(如达到最大迭代次数或误差小于阈值)。

通过以上步骤,BP神经网络能够根据输入数据进行训练,并通过反向传播来不断调整模型参数,从而实现对输入数据的分类或回归预测。

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)