Stable Diffusion最牛垫图新玩法,不需要咒语,1分钟完美复刻原图!(附安装使用教程)

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。感兴趣的小伙伴,赠送

Stable Diffusion,一款基于深度学习的图像生成模型,以其强大的图像生成能力和个性化风格迁移能力,在艺术创作领域掀起了一场革命。如今,Stable Diffusion推出了全新的垫图功能,让你无需咒语,只需1分钟,就能完美复刻原图。本文将带你深入了解Stable Diffusion的垫图功能,并附上安装使用教程。

Stable Diffusion是一款基于深度学习的图像生成模型,它能够在没有任何人类指导的情况下生成高质量、逼真的图像。与传统的图像生成技术相比,Stable Diffusion具有更高的生成质量和更快的生成速度。

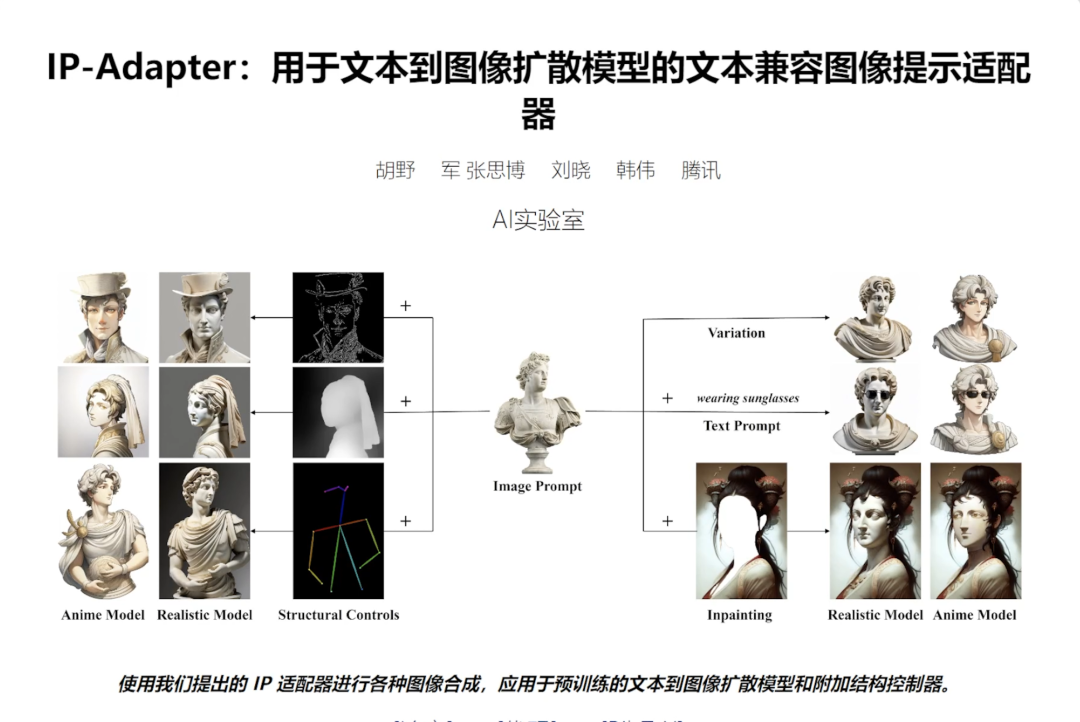

1.ip-adapter是什么?

ip-adapter是腾讯Ai工作室发布的一个controlnet模型,可以通过stable

diffusion的webui使用,这个新的功能简单来说,他可以识别参考图的艺术风格和内容,然后生成相似的作品,并且还可以搭配其他控制器使用。可以说SD已经学会临摹大师的绘画并且运用到自己的作品上了。

论文资料:

https://ip-adapter.github.io/

IP-adapter的github地址:

https://github.com/tencent-ailab/IP-Adapter

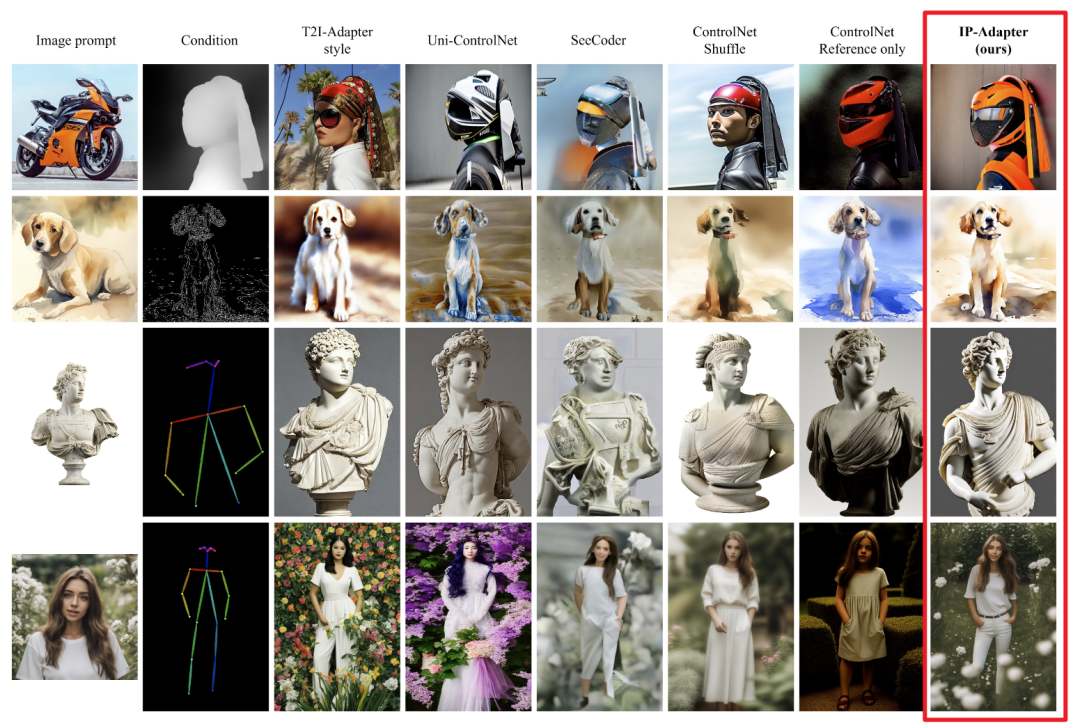

2.ip-adapter生成效果怎么样:

官方对ip-adapter进行了测试,如下图,第一列是输入的图片参考,第二列是输入的其他控制参数。

最后一列是使用ip-adapter生成的效果,看第一行摩托车的测试能明显看出,ip-

adapter的方法不仅在图像质量方面优于其他方法,而且生成的图像与参考图像更好地对齐。

官方给出的结论就是:ip-adapter非常好用。

但是根据我的测试,ip-adapter使用SD1.5的模型效果明显优于SDXL模型的效果,不知道是不是由于官方训练时使用的基本都是SD1.5模型的原因。

3.ip-adapter如何使用?

废话不多说我们直接看如何使用,和我测试的效果如何!

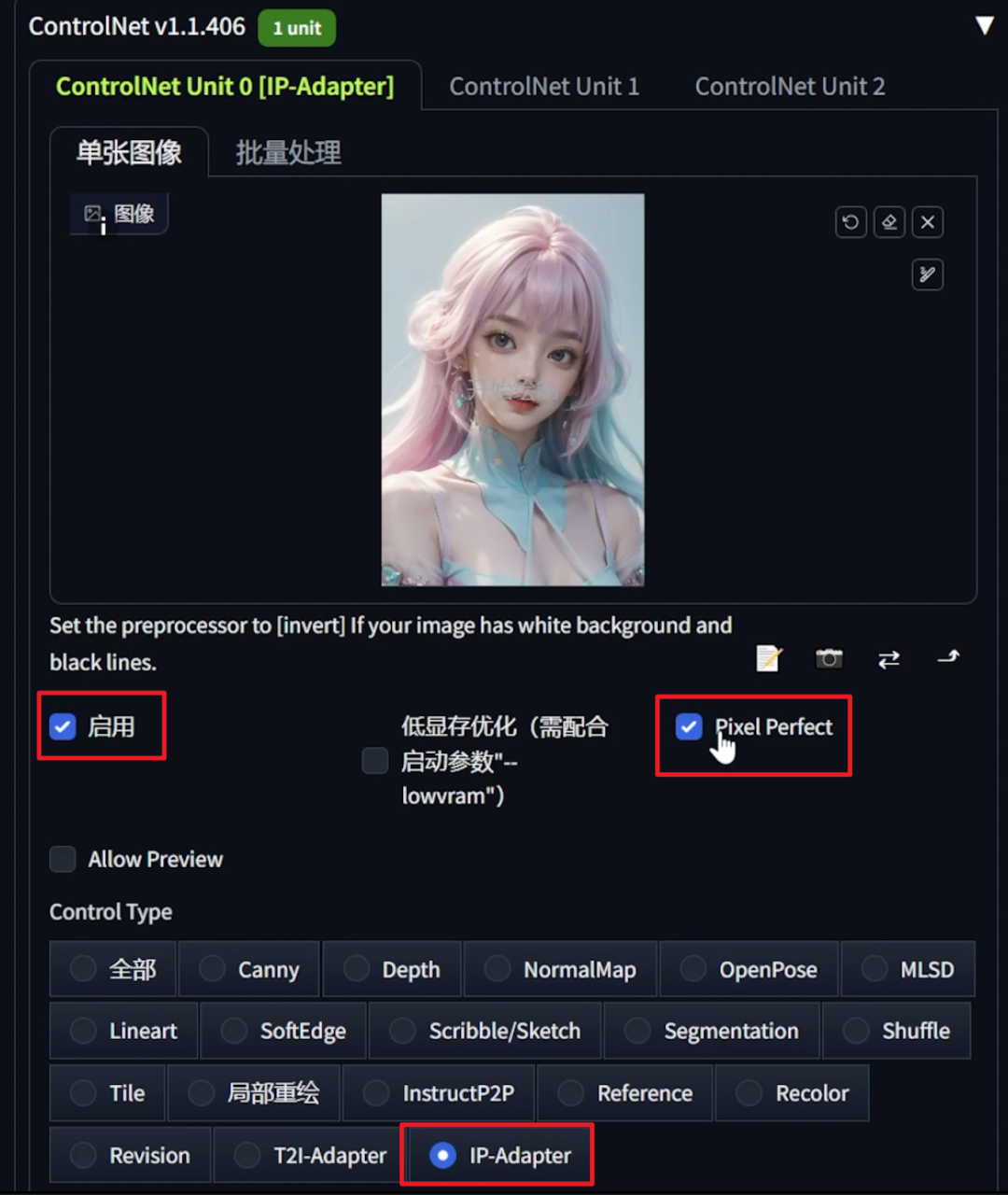

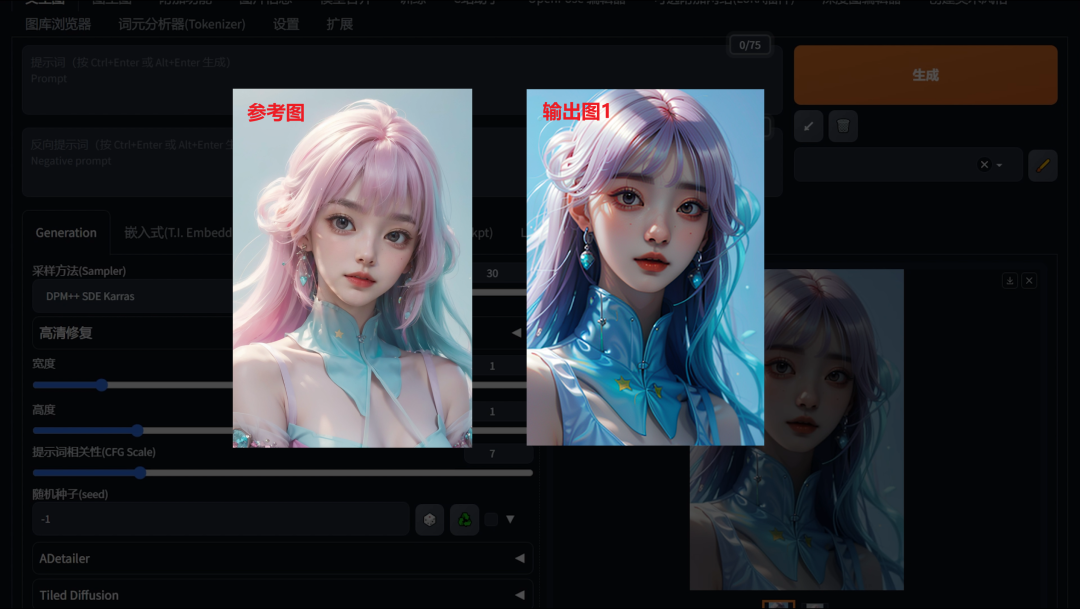

案例1 人物风格控制:

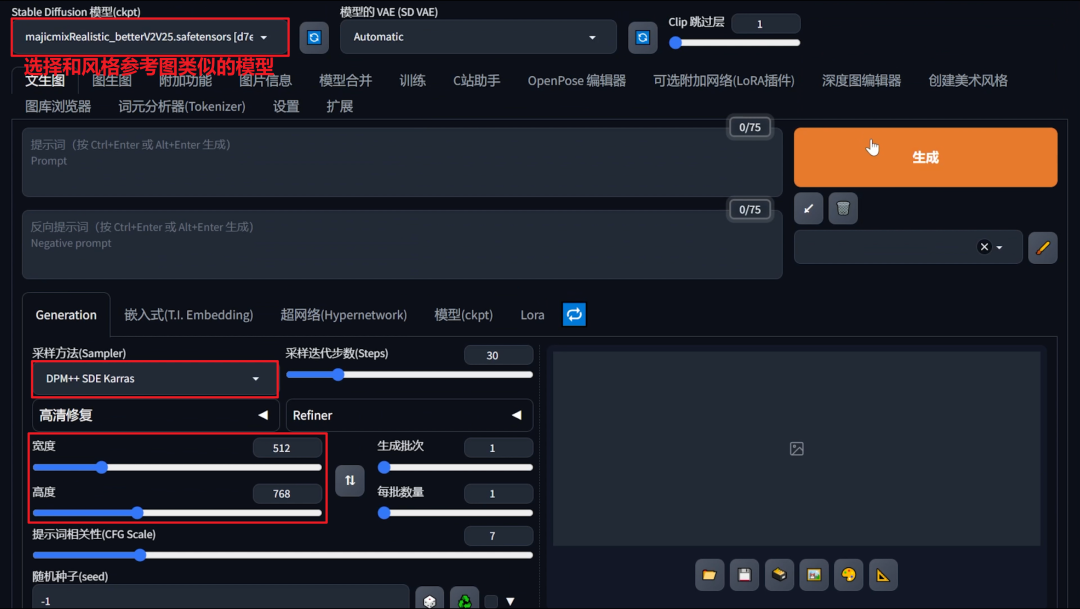

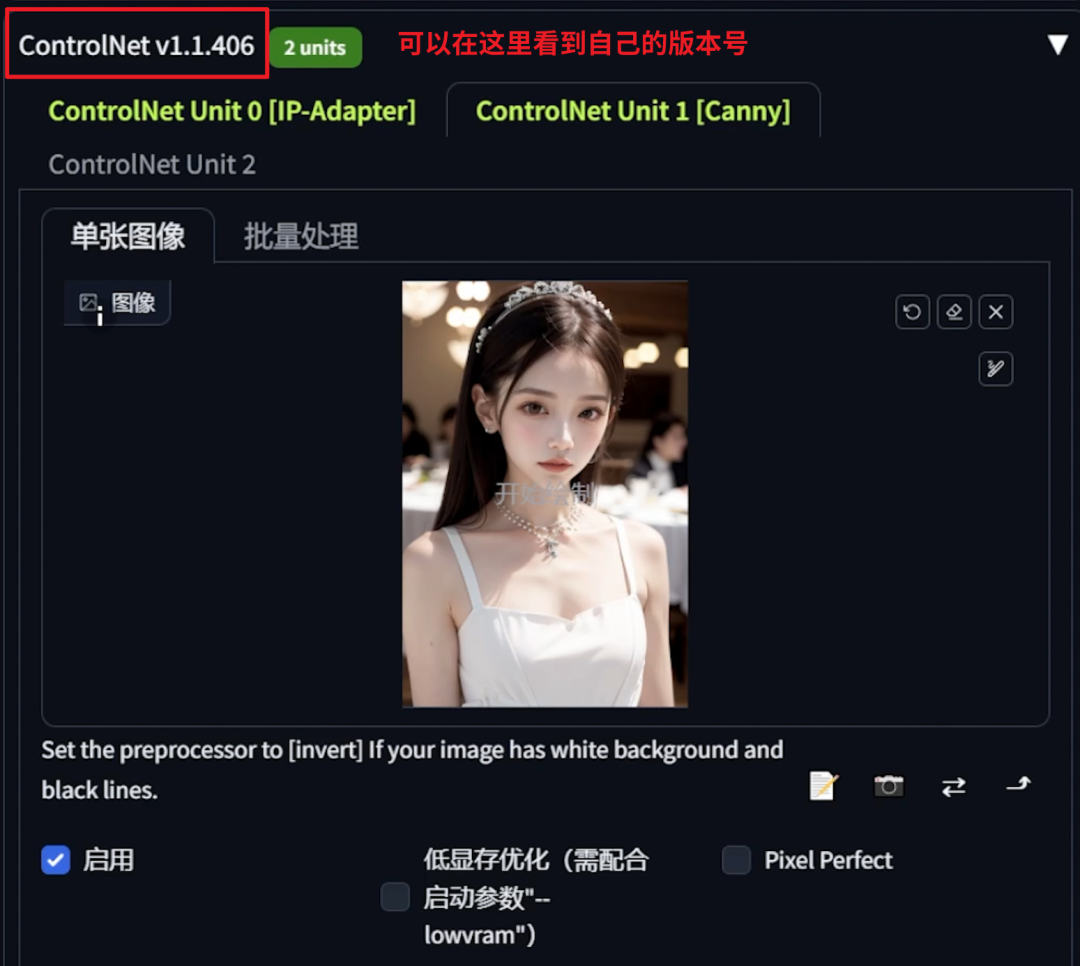

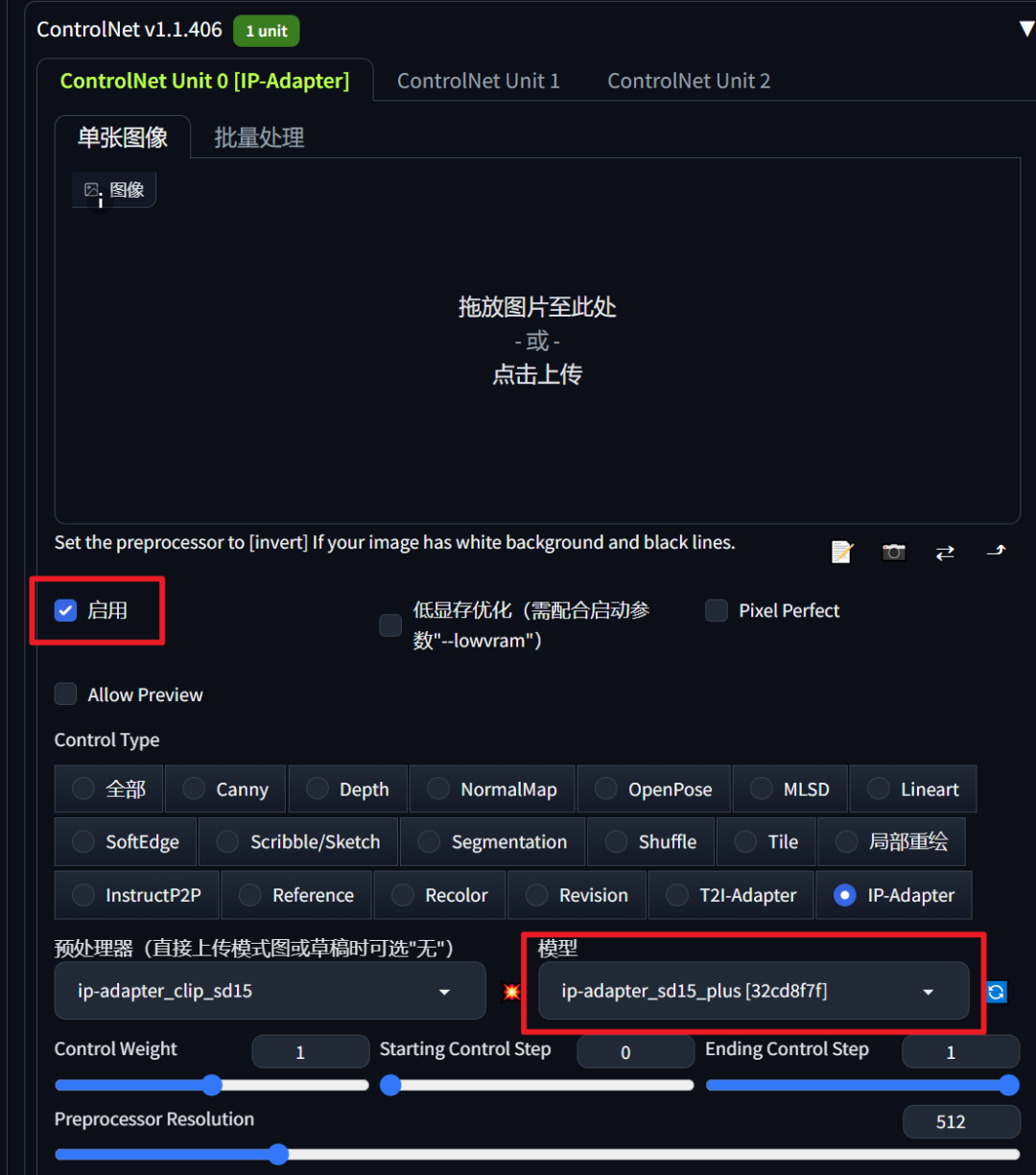

首先,我们打开webui界面,在controlnet选择ip-

adapter,选择一张参考图,我专门选了一张风格比较明显的女生。controlnet的其他参数可以不做调整。

然后,我们选择一个和参考图片风格类似的大模型,调整预处理器和图片尺寸,最后点击生成按钮。

可以看到我这里并没有填写任何提示词,是为了测试仅由controlnet的ip-adapter能输出怎样的效果图。大家使用的时候可以正常填写起手式提示词。

可以看到生成的人物不仅头发颜色,动作姿势类似,而且服装也有比较好的还原。

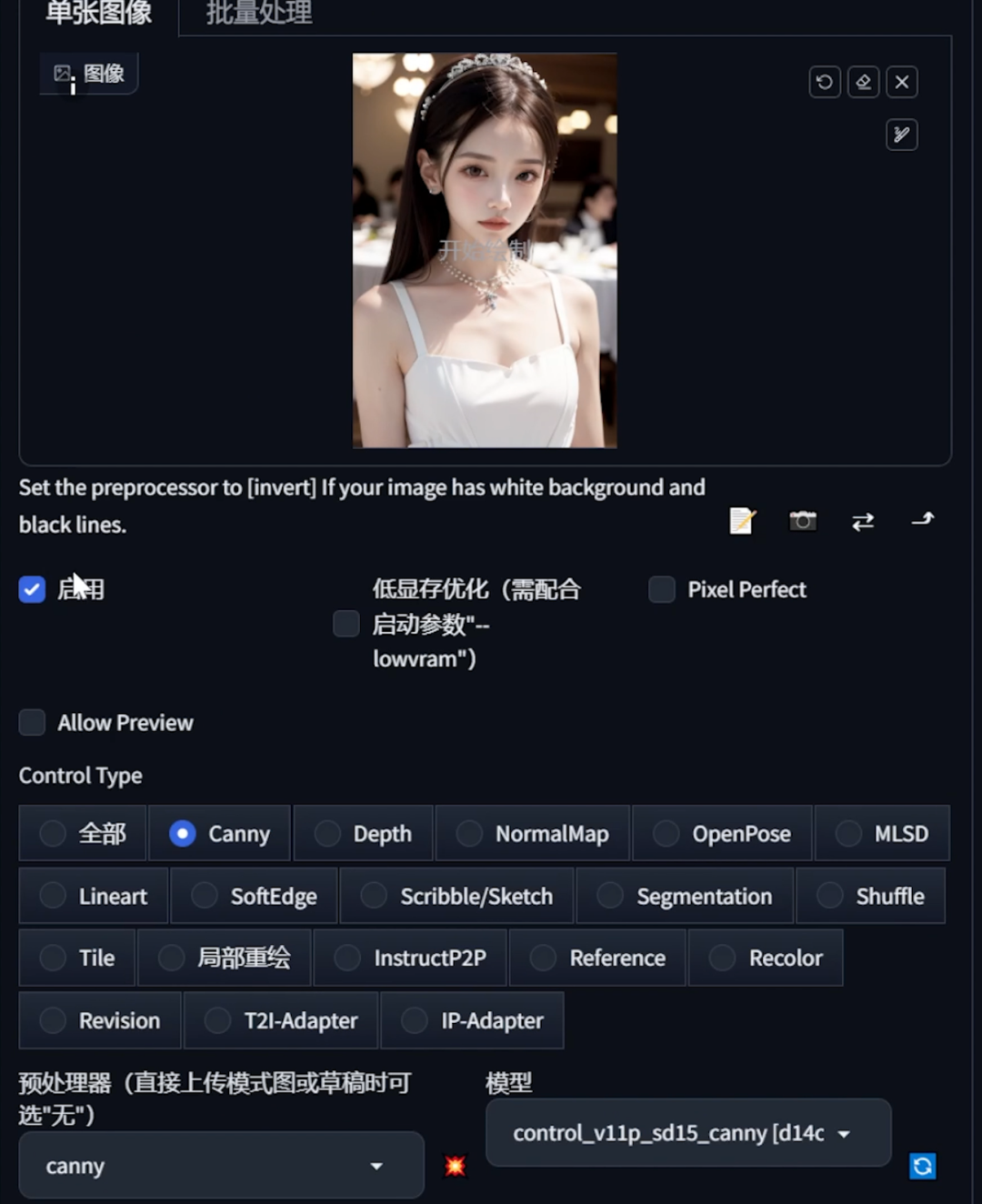

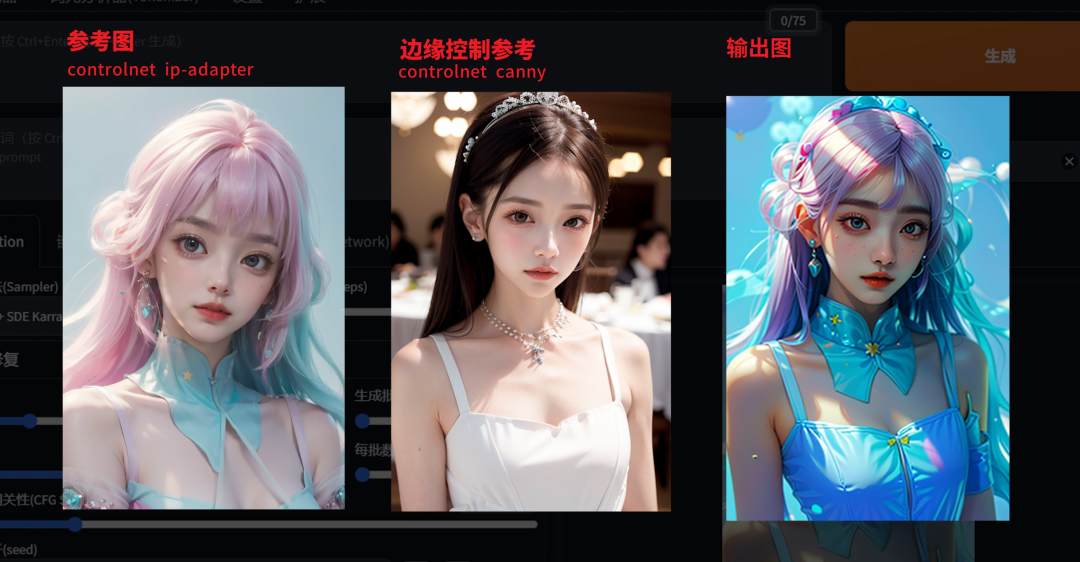

接着,我们再添加一张新图片到ControlNet中,选择Canny作为控制方式,推荐把控制参数调低一些,大约0.7左右,最后点击生成按钮。

生成的人物图片姿势符合参考图片,而且画风还能保持统一。

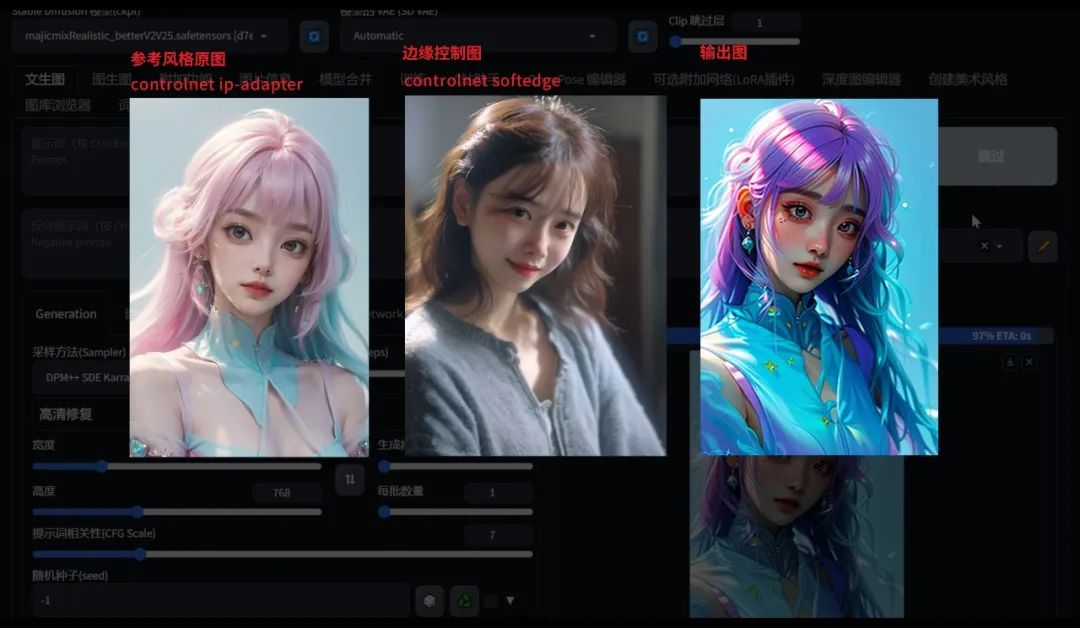

然后,我们再换一张图片,选择SoftEdge模式进行生成,结果同样令人满意。

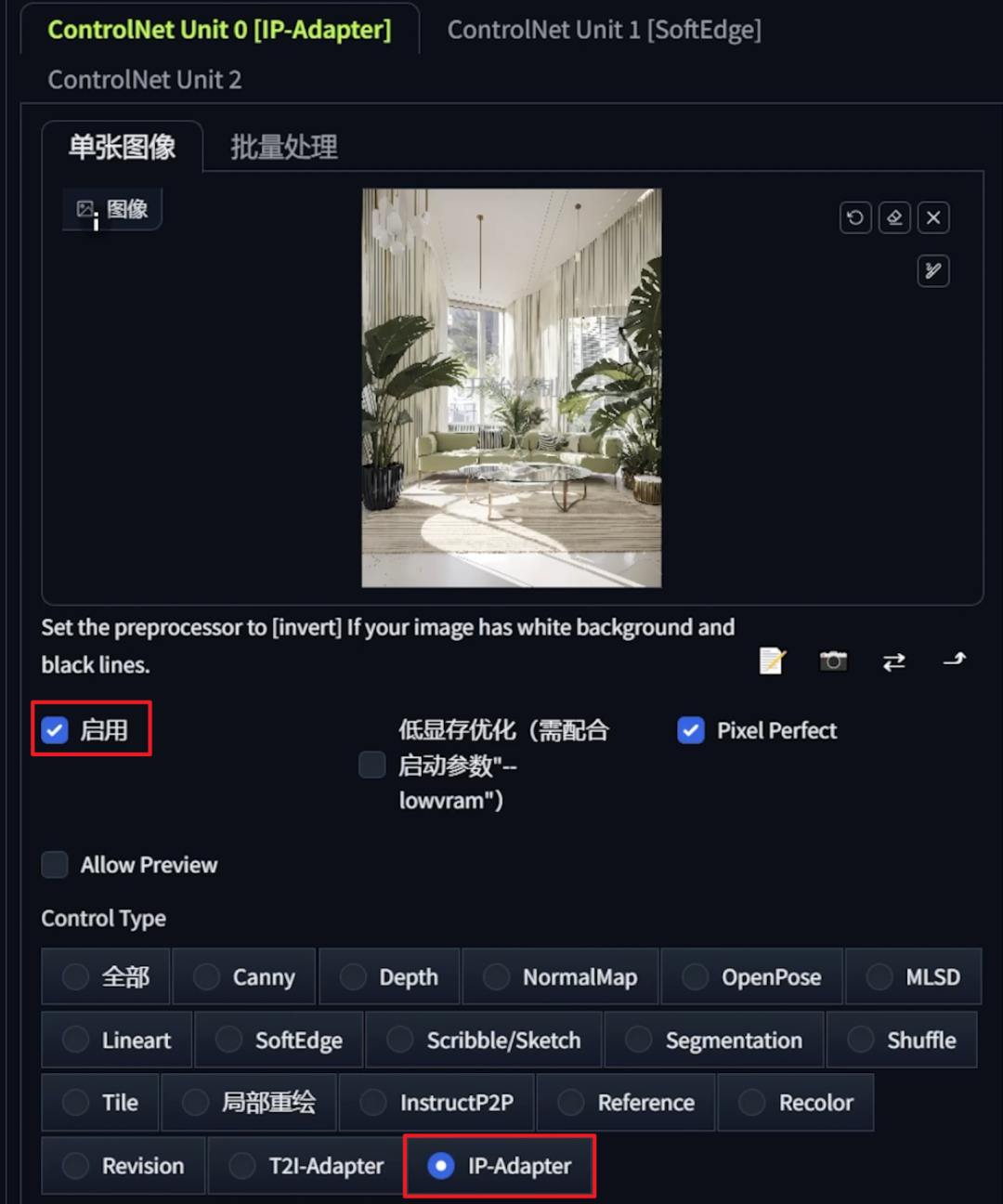

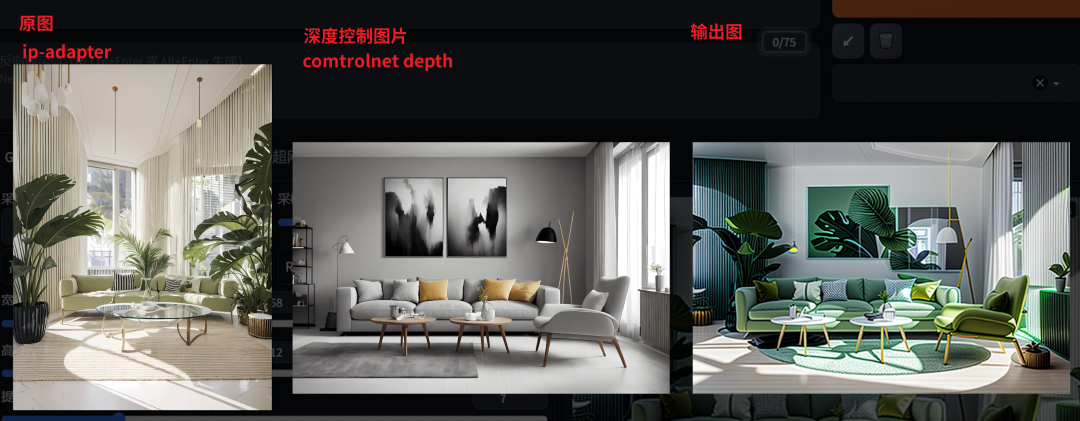

案例2 室内效果风格控制:

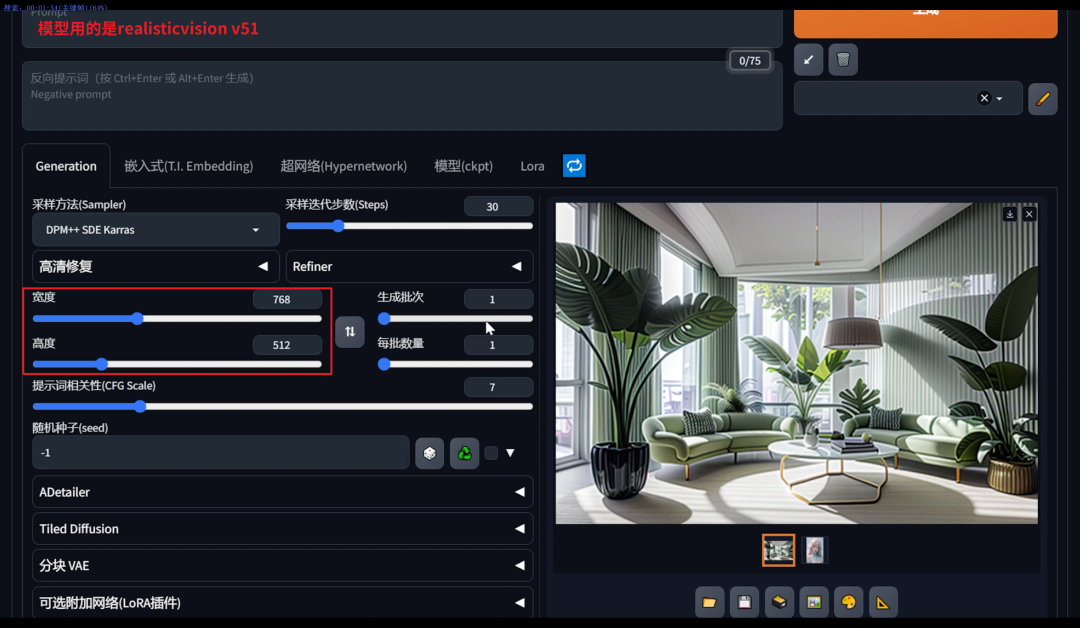

接下来,我们演示一下如何制作室内效果图。首先,我们选择一张室内效果图并将其放入ControlNet中。接着选择IP-Adapter进行适配,

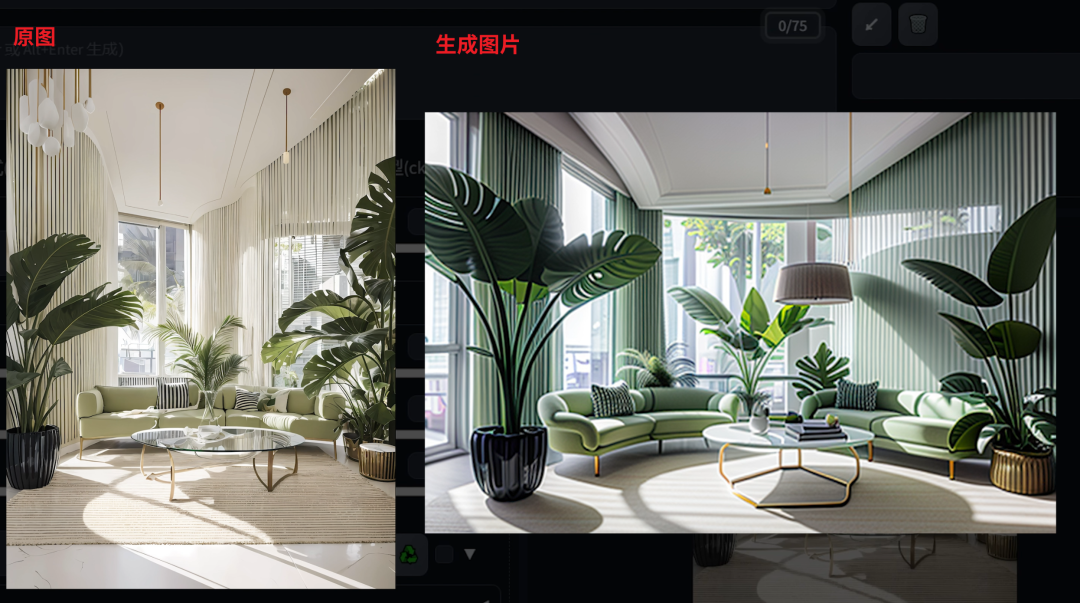

然后调整图片参数和更换大模型,我这里用的是RealisticVisionV51,最后直接点击生成按钮,可以看到生成的效果图风格非常接近原图。当然这个拿来直接使用还有一定的差距,还需要一些处理。

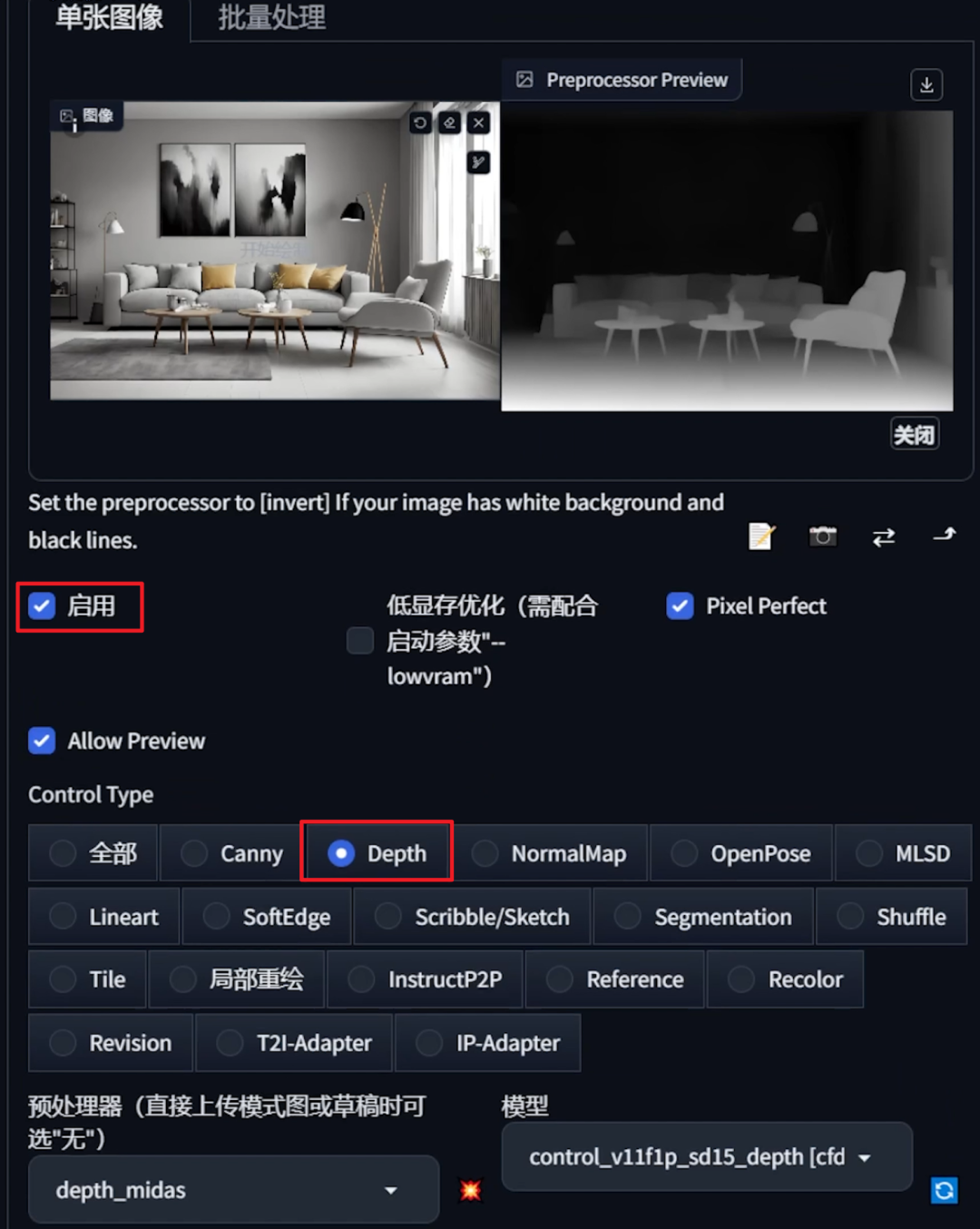

所以我再添加一个图作为构图参考,选择depth,深度图模型,点击生成。风格也是完美的迁移到了我们想要的构图上,

虽然现在看起来生成的图片有些模糊,是因为我使用的是SD1.5的模型,并且还没有输入任何的提示词。

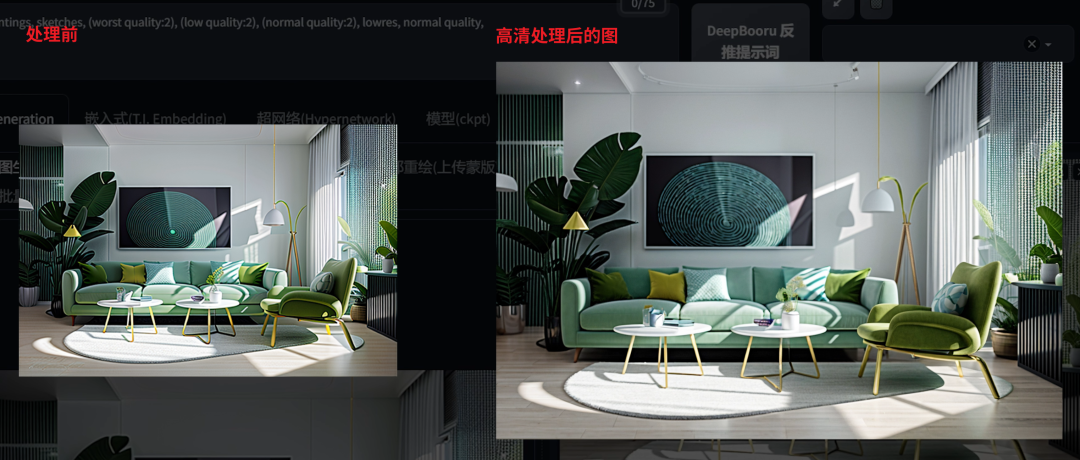

最后,我们再添加一个常用的质量提示词起手式,然后通过使用Tiled插件,提高生成图片的分辨率,最终达到1080分辨率。

这就是ControlNet插件V1.1.4版本的最新更新,ip-

adapter功能。我相信将为AI绘画带来新的可能性,无论你是艺术家、设计师,还是只是对技术感兴趣,这些工具都值得一试。

4.如何在stable diffusion-webui上下载使用ip-adapter呢?

环境要求:

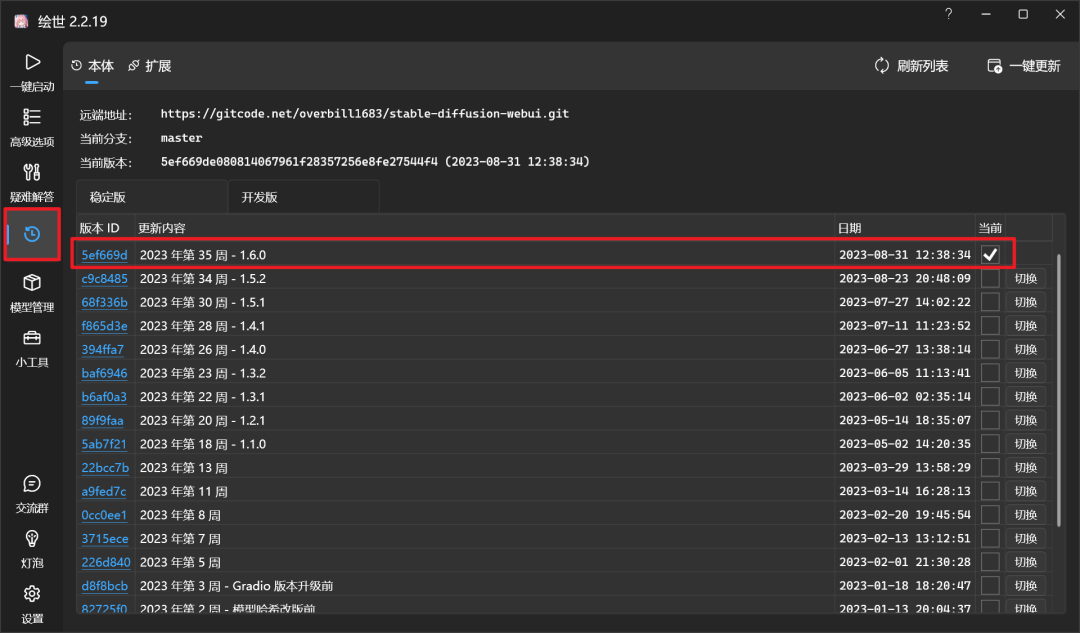

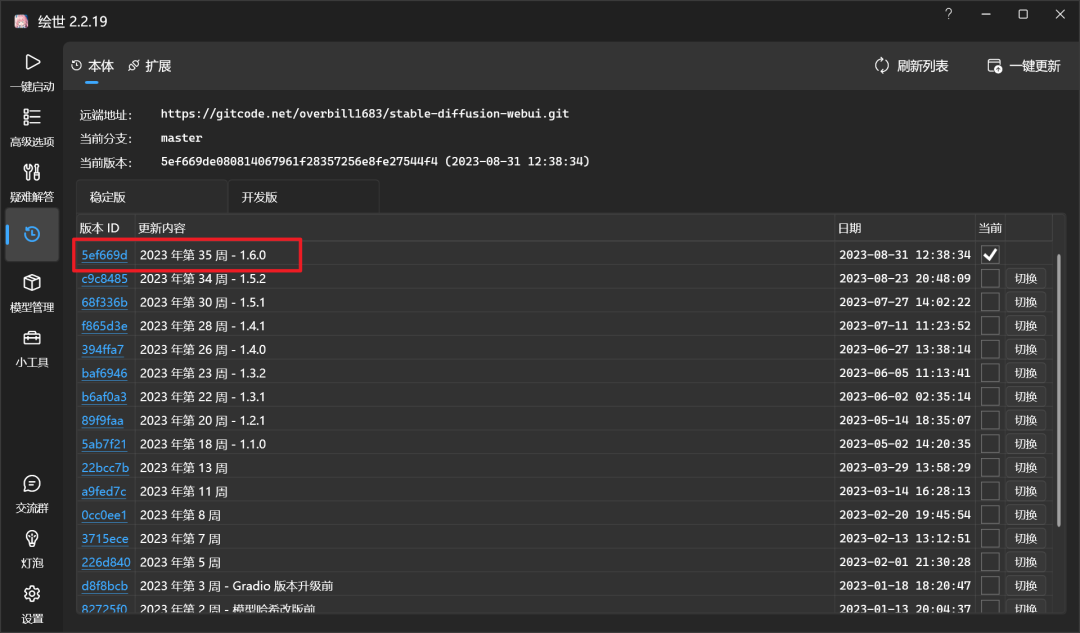

1.下载好秋叶的stable diffusion一键整合包,并且将webui的版本更新到v1.6。

如果没有安装过的小伙伴,我把一键整合包资源放文末了需要的同学可以文末自行扫描获取

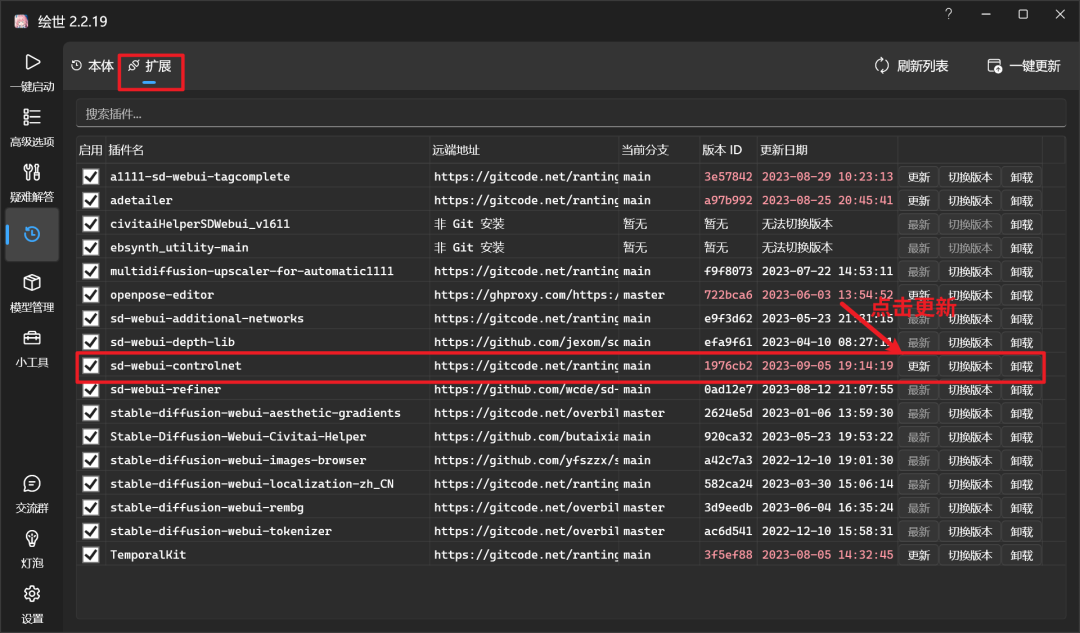

2.将controlnet更新到v1.1.4及之后的版本。

controlnet模型安装:

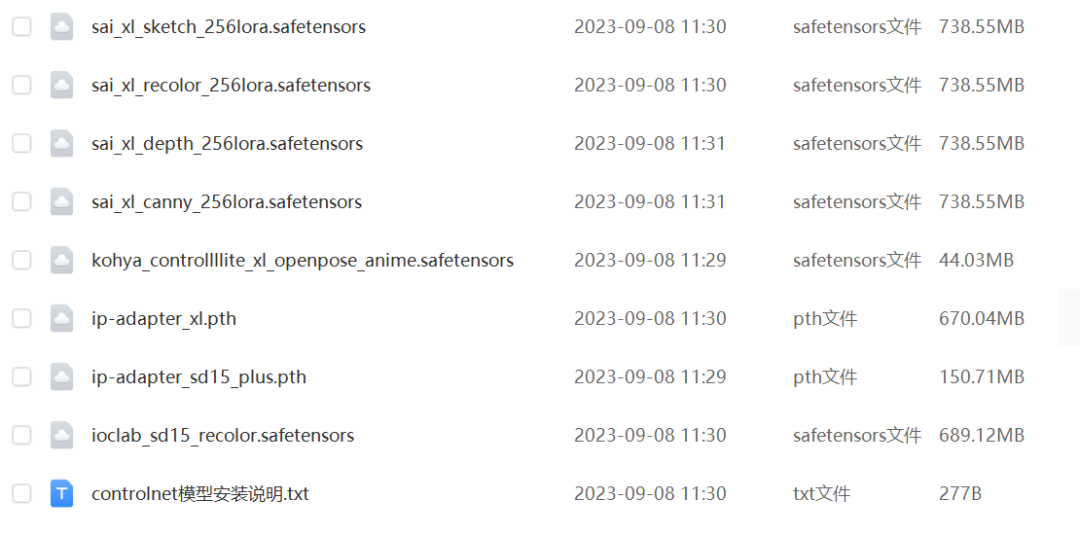

准备好环境之后,需要下载controlnet最新的ip-adapter模型,放在网盘中了,选择一个网盘全部下载下来,

放到stable-diffusion-webui根目录\extensions\sd-webui-controlnet’models或者stable-

diffusion-webuii根目录\models\ControlNet中即可。

(需要的同学可文末可自行扫描获取)

安装好模型再重启webui即可。

5.ip-adapter出现错误,无法生成类似图片如何解决?

按照以下方式逐一检查错误:

1.检查webui版本是否是v1.6及以后的版本。

2.controlnet的ip-adapter模型是否安装并启用。如果未安装,请使用上方的网盘链接进行下载,并且将controlnet模型放到stable-

diffusion-webui\extensions\sd-webui-controlnet\medels或者stable-diffusion-

webui\models\ControlNet中。

3.检查webui根目录\extensions\sd-webui-controlnet\annotator\downl oads\clip_vision

目录里有没有这两个模型:【clip_g.pth】【clip_h.pth】,如果没有,我将这两个clip模型放在我的公众号中了,发送“clip模型”将自动发送给你哟。

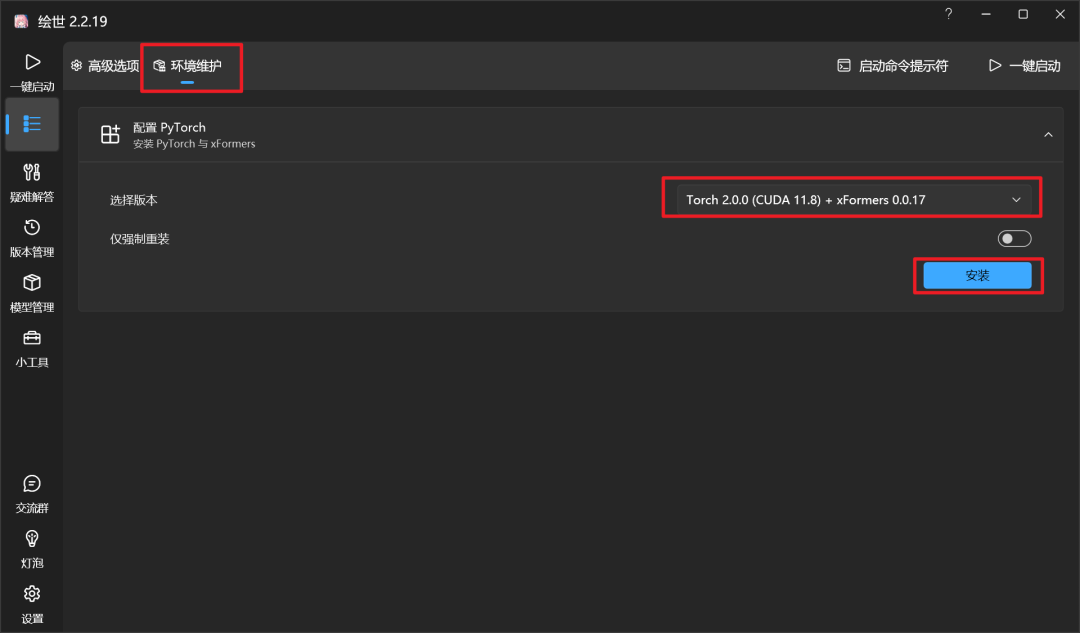

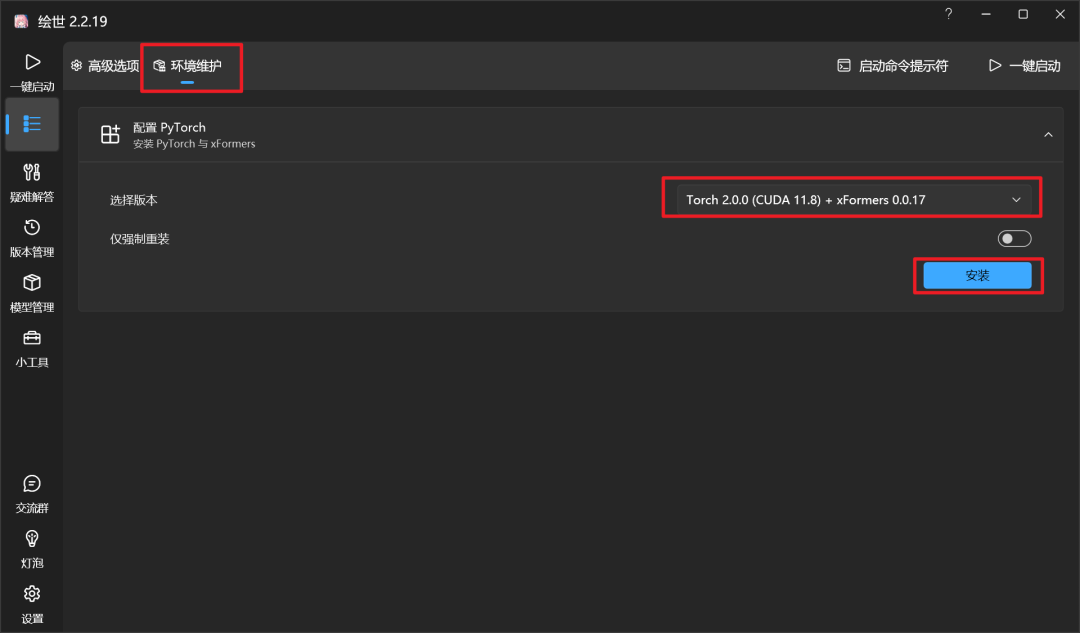

4.如果以上都不能解决问题,请更新一下pytorch版本。打开秋叶启动器,在“高级选项”-“环境维护”-选择至少torch2.0.0版本及以后的版本安装更新。

资料软件免费放送

次日同一发放请耐心等待

“高级选项”-“环境维护”-选择至少torch2.0.0版本及以后的版本安装更新。

资料软件免费放送

次日同一发放请耐心等待

写在最后

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的AIGC全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献129条内容

已为社区贡献129条内容

所有评论(0)