人工智能AI基础知识科普系列:神经网络是什么?

神经网络是模仿人脑结构的机器学习模型,通过输入层、隐藏层和输出层处理复杂数据。其核心优势在于能够通过前向传播和反向传播算法自动学习特征,无需人工编写规则。这种结构使其在图像识别、语音处理等任务中表现优异,如AlphaGo和ChatGPT的成功应用。然而,神经网络也存在数据需求大、计算资源消耗高、决策过程难以解释等挑战。深度学习作为神经网络的延伸,进一步提升了AI的能力。要系统学习神经网络和AI技术

今天,我们要深入探讨机器学习中的一个“明星”——“神经网络”(Neural Network)。你可能听说过这个词,尤其是在AI击败人类棋手、识别图片甚至生成文本的新闻里。那么,神经网络到底是什么?它为什么这么厉害?让我们一步步揭开它的秘密。

一、神经网络:模仿人脑的“魔法”

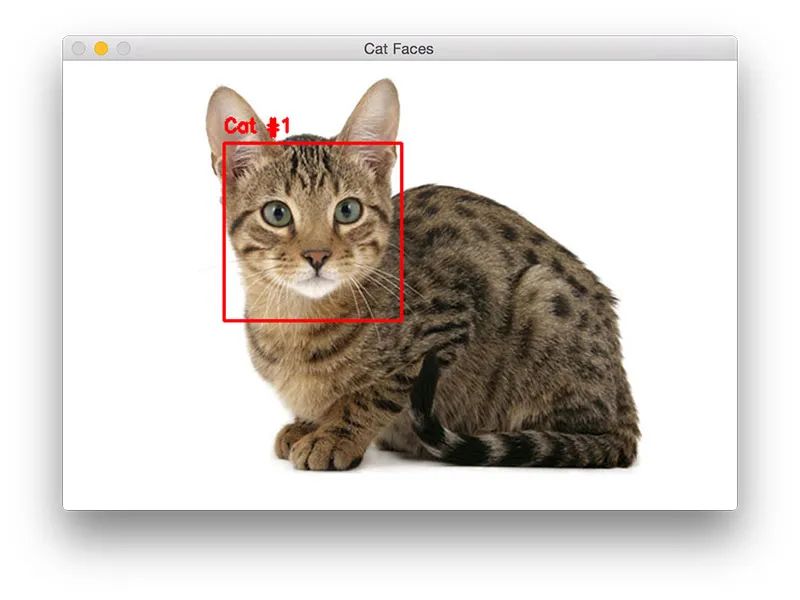

神经网络的灵感来源于人脑。我们的大脑里有大约860亿个神经元,它们通过电信号互相连接,帮我们思考、感知和决策。比如,你看到一只猫,大脑里的神经元会迅速处理眼睛传来的信号,最终让你认出“这是猫”。科学家们受到这个过程的启发,想:能不能用数学模型模仿人脑,让机器也能“像人一样”处理问题?于是,神经网络就诞生了。

简单来说,神经网络是一堆“人工神经元”组成的系统。这些神经元不是真的生物细胞,而是用数学公式模拟的“节点”。它们一层一层地连接在一起,接收输入(比如一张图片的数据),经过层层计算,输出结果(比如“这是一只猫”)。虽然它比不上人脑的复杂性,但这种模仿让神经网络在处理复杂任务时表现出色。

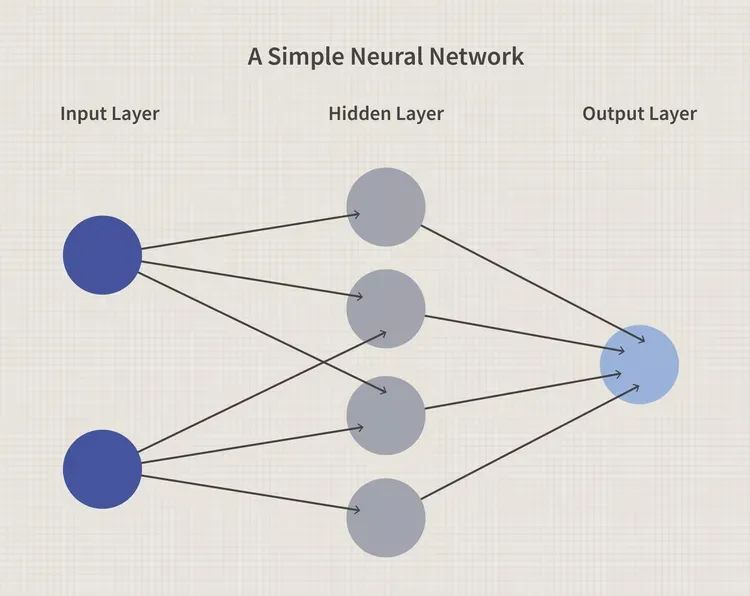

二、神经网络的基本结构

一个典型的神经网络有三部分,像是工厂里的流水线:

-

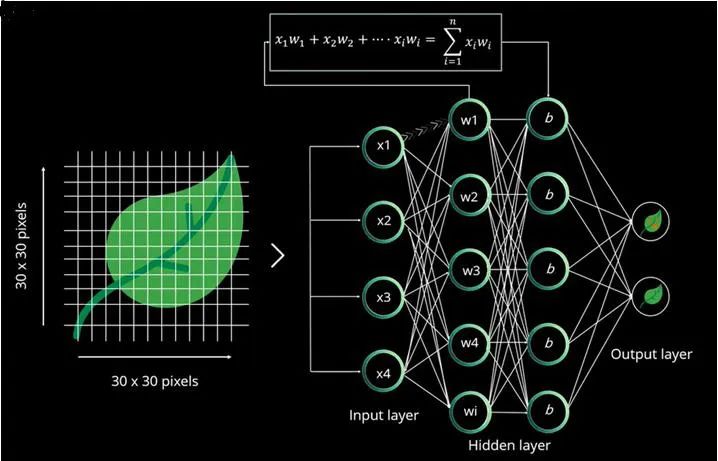

输入层(Input Layer)

这是神经网络的“眼睛”,负责接收外部数据。比如一张猫的图片,输入层会把每个像素的颜色值(比如红、绿、蓝,范围从0到255)变成数字,喂给网络。如果图片是28×28像素,那就是784个输入节点。 -

隐藏层(Hidden Layers)

这是神经网络的“大脑”,也是最神奇的部分。隐藏层里有很多节点,每个节点都对输入数据做一些数学运算——通常是把输入乘以“权重”(Weight),加上“偏差”(Bias),再通过一个“激活函数”(比如让结果变非线性)。然后,计算结果传给下一层。

举个例子:第一层隐藏层可能学会识别图片里的边缘(比如猫耳朵的轮廓),第二层可能认出形状(比如猫脸的圆形),第三层可能分辨纹理(比如猫毛的细节)。层数越多,网络越“深”,能处理的问题就越复杂。 -

输出层(Output Layer)

这是神经网络的“嘴”,负责给出最终答案。比如在猫的例子中,输出层可能有两个节点,一个表示“猫”的概率,一个表示“非猫”的概率。经过计算,它可能会输出:“90%是猫,10%不是猫。”

用生活比喻来说:假设你在菜市场挑西瓜。你先看外形(输入层),然后脑子里回忆“西瓜通常是圆的、皮上有条纹”(隐藏层),最后得出结论“这应该是个西瓜”(输出层)。神经网络也是这样,只不过它用数字和公式代替了直觉。

一个简单的神经网络通常由三部分构成

三、神经网络如何“学习”?

神经网络的强大之处在于它能“学习”。但它是怎么做到的呢?这就回到了机器学习的核心——训练过程。让我们用猫狗识别的例子,详细拆解一下:

-

前向传播(Forward Propagation)

一开始,神经网络的参数(每个节点的权重和偏差)是随机的。它把一张猫的图片数据“推”过网络,得到一个初步结果。比如,第一次看到猫,它可能胡乱猜:“60%是狗,40%是猫”,完全不对。 -

误差计算

接着,网络会比较自己的猜测和正确答案(标签告诉它“这其实是猫”),算出误差有多大。误差就像考试分数,分数越低,说明错得越离谱。数学上,这通常用“损失函数”(Loss Function)来衡量,比如“预测值和真实值的差距平方”。 -

反向传播(Backpropagation)

然后,网络从输出层往回调整参数,让误差变小。这有点像你做错数学题,老师告诉你答案是5,你就回头检查哪一步算错了,然后改过来。反向传播用的是“梯度下降”(Gradient Descent)方法,逐步调整每个权重,让网络的预测更接近正确答案。 -

反复训练

一张图片不够,网络需要看成千上万张图片(猫和狗的都有),反复进行前向传播和反向传播。慢慢地,它会发现:“哦,尖耳朵和胡须通常意味着猫,圆耳朵和短鼻子更像是狗。”最终,它就能准确识别了。

举个真实案例:手写数字识别(MNIST数据集)是一个经典例子。神经网络被喂了6万张手写数字图片(0到9),通过训练,它能识别新图片上的数字,准确率高达99%以上。

四、为什么神经网络这么厉害?

神经网络的“超能力”来源于它的结构和灵活性:

-

多层设计:一层可能识别边缘,两层能认出形状,三层能分辨纹理。多层叠加让它能处理复杂问题。比如在一张杂乱的照片里,它能从背景中挑出猫的脸。

-

大数据驱动:神经网络需要大量数据,但一旦喂饱了,它的表现往往碾压传统方法。比如,传统编程识别猫可能要写几千行规则,神经网络只要数据够多,就能自己搞定。

-

通用性:同一个神经网络结构,经过不同训练,可以干各种活。比如,卷积神经网络(CNN)擅长识别人脸,循环神经网络(RNN)能翻译语言,甚至生成音乐。

这也是为什么神经网络在AI领域大放异彩。比如,2016年AlphaGo用神经网络分析围棋棋局,击败了世界冠军李世乭;ChatGPT用它生成流畅的对话;自动驾驶用它识别路标和行人。

五、神经网络的局限与挑战

当然,神经网络也不是完美的“魔法棒”:

-

资源需求:它需要海量数据和强大算力。比如,训练一个大型神经网络可能需要几十个GPU,耗时几天甚至几周,电费都不便宜。

-

黑箱问题:神经网络有时像个“黑箱”,我们知道它管用,但很难解释它为什么这么判断。比如,它说“这张图是猫”,但具体是因为耳朵还是毛色,我们不清楚。

-

过拟合风险:如果数据不够多样,网络可能“死记硬背”,只认识训练过的猫,遇到新品种就懵了。

科学家们正在努力解决这些问题,比如用更少数据训练(少样本学习),或者开发“可解释AI”来揭开黑箱。

六、下期预告

这一期我们探索了神经网络,看到了它如何模仿人脑,驱动AI的惊人能力。但你可能听过“深度学习”(Deep Learning),它和神经网络有什么关系?下一期,我们将聊聊深度学习,看看它如何把神经网络推向新的高度,成为现代AI的支柱。敬请期待!

最后

如果你真的想学习人工智能,请不要去网上找那些零零碎碎的教程,真的很难学懂!你可以根据我这个学习路线和系统资料,制定一套学习计划,只要你肯花时间沉下心去学习,它们一定能帮到你!

这里也给大家准备了人工智能各个方向的资料,大家可以微信扫码找我领取哈~

也可以微信搜索gupao66回复32无偿获取哦~

GitCode 天启AI是一款由 GitCode 团队打造的智能助手,基于先进的LLM(大语言模型)与多智能体 Agent 技术构建,致力于为用户提供高效、智能、多模态的创作与开发支持。它不仅支持自然语言对话,还具备处理文件、生成 PPT、撰写分析报告、开发 Web 应用等多项能力,真正做到“一句话,让 Al帮你完成复杂任务”。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)