深度学习笔记-ResNet、Inception和Xception

ResNet(加深)resnet抛开数学层面的损失函数修改,从网络结构方面进行优化,通过残差块的方式,保证在更深的网络中也能保证良好的网络性能(VGG时代网络层数的过度加深会导致网络性能退化)Inception(加宽)除了网络深度问题,我们怎样在不增加计算成本的前提下扩展神经网络?Inception网络通过在每层模型中设置不同大小的卷积核,并用1*1卷积进行降维,让下一层自行决定使用什么卷积中的特

·

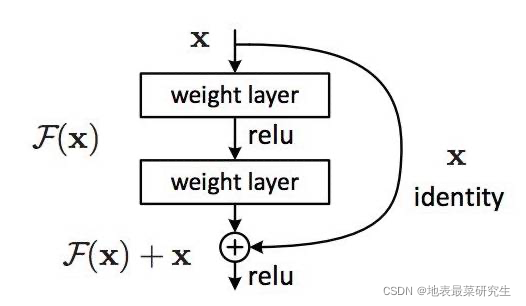

ResNet(加深)

resnet抛开数学层面的损失函数修改,从网络结构方面进行优化,通过残差块的方式,保证在更深的网络中也能保证良好的网络性能(VGG时代网络层数的过度加深会导致网络性能退化)

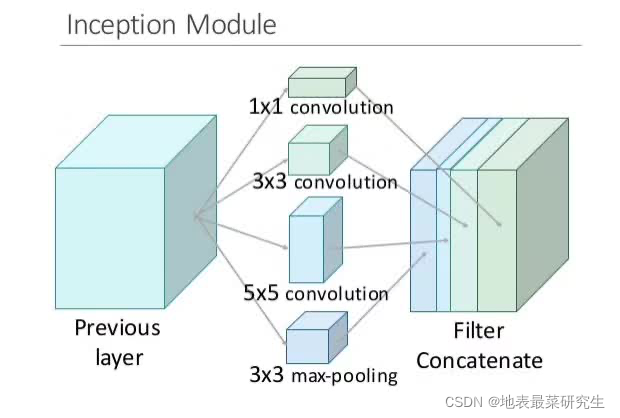

Inception(加宽)

除了网络深度问题,我们怎样在不增加计算成本的前提下扩展神经网络?Inception网络通过在每层模型中设置不同大小的卷积核,并用1*1卷积进行降维,让下一层自行决定使用什么卷积中的特征。

Xception(将通道上的关系和空间关系分离进行识别)

Xception的假设是:「跨通道的相关性和空间相关性是完全可分离的,最好不要联合映射它们。」

Xception 在Inception的基础上更进一步。不再只是将输入数据分割成几个压缩的数据块,而是为每个输出通道单独映射空间相关性,然后再执行 1×1 的深度方面的卷积来获取跨通道的相关性。(本质上相当于深度可分离卷积)它包含一个深度方面的卷积(一个为每个通道单独执行的空间卷积),后面跟着一个逐点的卷积(一个跨通道的 1×1 卷积)。我们可以将其看作是首先求跨一个 2D 空间的相关性,然后再求跨一个 1D 空间的相关性。可以看出,这种 2D+1D 映射学起来比全 3D 映射更加简单。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)